愿景:"让编程不再难学,让技术与生活更加有趣" xdclass.net

愿景:"让编程不再难学,让技术与生活更加有趣" xdclass.net

第一章 架构师系列-容器编排调度K8S最佳实践专题课程介绍

第1集 架构师系列-容器编排调度K8S最佳实践专题课程介绍

简介:架构师系列-容器编排调度K8S最佳实践专题课程介绍-课程适合人员和学后水平

课程介绍

本套课程 是全新录制,从0到1讲解新版kubernetes核心基础+高级知识点+可视化管理工具Rancher实战

核心介绍

- 从0到1教你掌握kubernetes核心组件,基于互联网项目部署方式演进,到整体容器编排调度组件架构。

- 使用阿里云ECS服务器多种方式搭建K8S集群,搭建MiniKube、KubeAdm等方式,5分钟带你部署第一个K8S应用

- 从k8s核心资源文件yaml解析到多个资源实战,包括 Pod、Label标签、NodeSelector选择器综合应用

- Pod控制器Deployment实现滚动升级、DeamonSet、Job等案例实战;

- 服务注册发现Service多类型ClusterIP、NodePort等应用;

- 数据存储持久化劵Volume实战,包括ConfigMap、Secret、NFS、PV、PVC多案例

- 基于当下热门框架SpringBoot+JDK11打包镜像,推送私有镜像仓库+K8S集群部署实战

- 互联网大厂DevOps链路解析,热门K8S可视化管理工具Rancher2.X实战,部署私有镜像SpringBoot应用和热门中间件Redis7、Mysql8.0实战

- 基于Kubectl操作对比Rancher管控台和备份导出,是一套从0学K8S到实战的快速上手课程

为什么要学习容器编排调度Kubernetes

多数互联网公司里面用的技术,实现跨主机多容器编排调度管理的最佳技术之一

可以实现服务注册发现、DevOps自动部署和回滚,能够自动实现请求的负载均衡分配网络流量

在多数互联网公司中,Kubernetes占有率很高,是近几年大量流行

可以作为公司内部培训技术分享必备知识,超多案例+实战等

有谁在用,进一线大厂(国内大厂多数都有用 )

- 国内:阿里、字节、腾讯 、微信、网易、虎牙、青云、新浪等

- 国外:谷歌、Facebook、亚马逊、苹果等

如果你想成为下面的一种,则这个课程是必备

- 后端高级开发工程师-大数据工程师

- 技术leader或者架构师

- 从传统软件公司过渡到互联网公司的人员

- 高级运维工程师 或 高级测试工程师

课程技术栈和测试环境说明

阿里云Linux CentOS 7服务器

技术不断更新,版本如何选择(跟着课程走,主流版本)

- 技术框架版本使用这块,不建议做第一个吃螃蟹的人

- 不同中间件,厂商不一样,不一定及时更新

学后水平

- 掌握kubernetes核心组件,基于互联网项目部署方式演进,到整体容器编排调度组件架构。

- 掌握阿里云ECS服务器多种方式搭建K8S集群,搭建MiniKube、KubeAdm等方式

- 掌握k8s核心资源文件yaml解析到多个资源实战,包括Pod、Label标签、NodeSelector选择器综合应用

- 掌握Pod控制器Deployment实现滚动升级、DeamonSet、Job等案例实战;

- 掌握服务注册发现Service多类型ClusterIP、NodePort等应用;

- 数据存储持久化劵Volume实战,包括ConfigMap、Secret、NFS、PV、PVC多案例

- 基于当下热门框架SpringBoot+JDK11打包镜像,推送私有镜像仓库+K8S集群部署实战

- 互联网大厂DevOps链路解析,热门K8S可视化管理工具Rancher2.X实战,部署私有镜像SpringBoot应用和热门中间件Redis7、Mysql8.0实战

- 基于Kubectl操作对比Rancher管控台和备份导出,是一套从0学K8S到实战的快速上手课程

学习形式

- 视频讲解 + 文字笔记 + 原理分析 + 交互流程图

- 配套源码 + 笔记 + 技术群答疑( 我答疑,联系客服进群)

- 只要是我的课程和项目-我会一直维护下去,大家不用担心!!!

【必做事情】更多技术问题+职业规划,可以加我微信

- 本职工作在比较忙,搬砖+带团队, 没法秒回,有空但都会很快回复的,见谅哈

第2集 架构师系列-容器编排调度K8S最佳实践课程大纲速览

简介:架构师系列-容器编排调度K8S最佳实践课程大纲速览

课程学前基础

- 有Linux+docker就行,不会的话我们有专题课程学习,联系客服小姐姐即可

- 框架整合这块:采用SpringBoot框架(采用其他语言或框架也行)

目录大纲浏览

学习要求:

课程有配套资料,如果有用到就会在对应章集的资料里面,如果自己操作的情况和视频不一样,仔细对比对比验证基本就可以发现问题了

K8S配置多,所以遇到和课程效果不一样的,建议看多几次,结合笔记里面的配置

重点先把概念+解决方案掌握

不同岗位对K8S的侧重点

- 后端/前端/测试/工程师、架构师 把这个k8s掌握即可

- 容器开发/运维工程师 可以做一个快速入门,后续可以找学习k8s底层原理这块知识

保持谦虚好学、术业有专攻、在校的学生,有些知识掌握也比工作好几年掌握的人厉害

文档

愿景:"让编程不再难学,让技术与生活更加有趣"

愿景:"让编程不再难学,让技术与生活更加有趣"

更多架构课程请访问 xdclass.net

第二章 互联网项目部署方式演进和K8S快速认知

第1集 老王的经历-互联网项目部署方式演进历史发展

简介:老王的经历-互联网项目部署方式历史发展

相信大家对K8S是又爱又恨

- 所谓爱的深、痛的深

- 爱:互联网大厂广泛使用,功能强大

- 痛:概念多、又抽象、底层复杂

应用程序部署方式

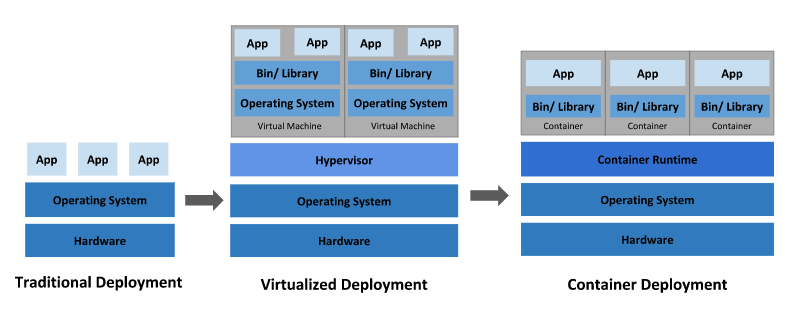

传统部署时代:

早期的时候,在物理服务器上运行应用程序

缺点

- 无法限制在物理服务器中运行的应用程序资源使用,会导致资源分配问题,过高或过低

- 部署多个物理机,维护许多物理服务器的成本很高。

虚拟化部署时代:

虚拟化技术允许在单个物理服务器的 CPU 上运行多台虚拟机(VM)。

虚拟化能使应用程序在不同 VM 之间被彼此隔离,且能提供一定程度的安全性

能够更好地利用物理服务器的资源,具有更高的可伸缩性,以及降低硬件成本等等的好处

缺点

- 需要单独一个系统,占用资源

- 不能灵活的扩容和缩容

容器部署时代:

容器类似于 VM,但是更宽松的隔离特性,使容器之间可以共享操作系统(OS)

最熟悉的就是Docker容器化技术

- 一行命令可以部署任意一个 mysql、nginx、redis、RabbitMQ、Kakfa等热门中间件

- docker命令可以操作当前机器上的1个容器

- docker-compose可以操作当前机器上的多个容器

容器比起 VM 被认为是更轻量级的,每个容器都具有自己的文件系统、CPU、内存、进程空间等。

跨云和操作系统发行版本的可移植性:可在 Ubuntu、CoreOS、CentOS、 Google Kubernetes Engine 和其他任何地方运行

- 那Docker容器化技术带来了哪些问题

- 更多技术问题+职业规划,可以加我微信(本职工作比较忙,没法秒回,见谅)

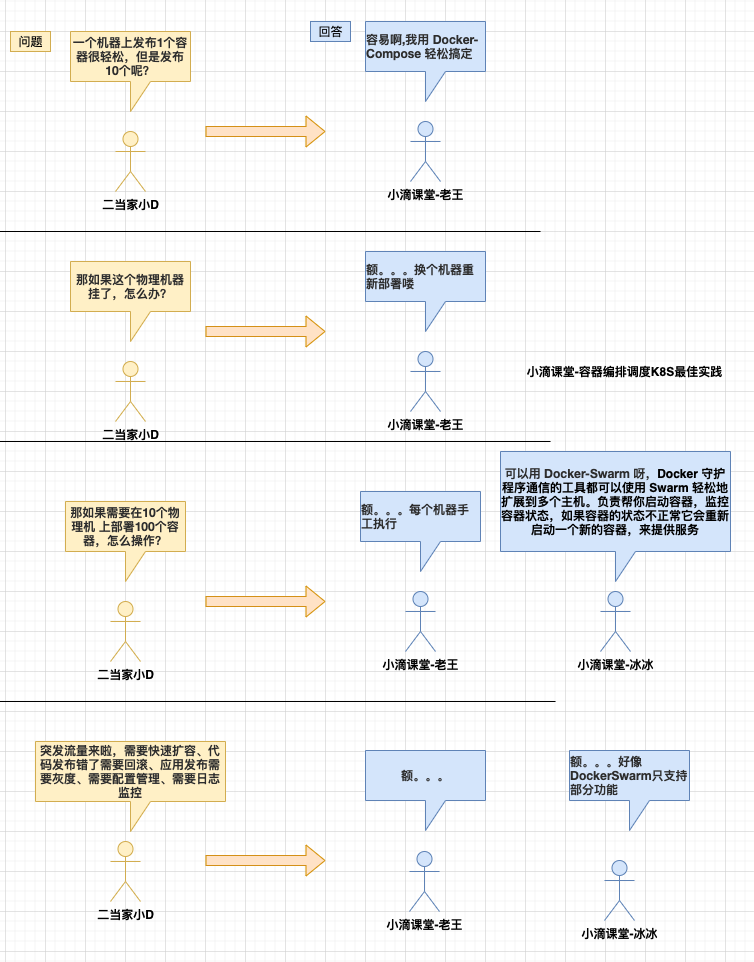

第2集 容器化带来的问题和Kuberntes快速认知

简介:容器化带来的问题和K8S快速认知

容器化部署存在的问题

问题

- 10个物理机发布100个容器,怎么快速发布和管理

- 用户请求过来,怎么分配请求到100个容器里面

- 突发海量请求过来,如何根据情况进行快速扩容

- 应用发布上线出现问题,需要进行回滚历史版本,如何进行回滚

- 某个容器故障了,如何快速启动新容器去替代

- ....

上面容器管理的问题称为容器编排,为了解决这些问题,产生了一些容器编排的软件

- Docker Swarm:Docker自己的容器编排工具

- Mesos:Apache的资源管控的工具,结合Marathon使用

- Kubernetes:Google开源的的容器编排工具, 基于内部Borg系统的开源版本

什么是Kubernetes?

- Kubernetes 这个名字源于希腊语,意为“舵手”或“飞行员”。

- k8s 这个缩写是因为 k 和 s 之间有八个字符的关系。

- Google 在 2014 年开源了 Kubernetes 项目。 Kubernetes 建立在Google 大规模运行生产工作负载十几年经验的基础上, 结合了社区中最优秀的想法和实践。

- Kubernetes是一个可移植、可扩展的开源平台,用于管理容器化的工作负载和服务,简称 K8S

- 官方文档:https://kubernetes.io/zh-cn/docs/home/

不说那么多废话了

- K8S的本质是一组服务器集群,可以在对应服务器集群的每个节点上运行程序,来对节点中的容器进行管理。

- 类似Master-Work方式,每个服务器上安装特定的k8s组件,就可以形成集群,然后部署对应的应用即可。

k8s常见的功能:

服务发现和负载均衡

- Kubernetes 可以使用 DNS 名称或自己的 IP 地址来暴露容器。

- 如果进入容器的流量很大, Kubernetes 能够自动实现请求的负载均衡分配网络流量,从而使部署稳定

存储编排

- Kubernetes 允许自动挂载选择的存储系统,例如本地存储、云提供商存储等。

自动部署和回滚

- 可以用k8s自动化部署创建新容器, 删除现有容器并将它们的所有资源用于新容器。

- 当版本发布错误,可以立刻回退到之前的版本

自我修复

- 如果某个容器宕机了,K8S 可以快速重新启动新的的容器,替换旧的容器

密钥与配置管理

K8S允许存储和管理敏感信息,例如密码、OAuth 令牌和 ssh 密钥

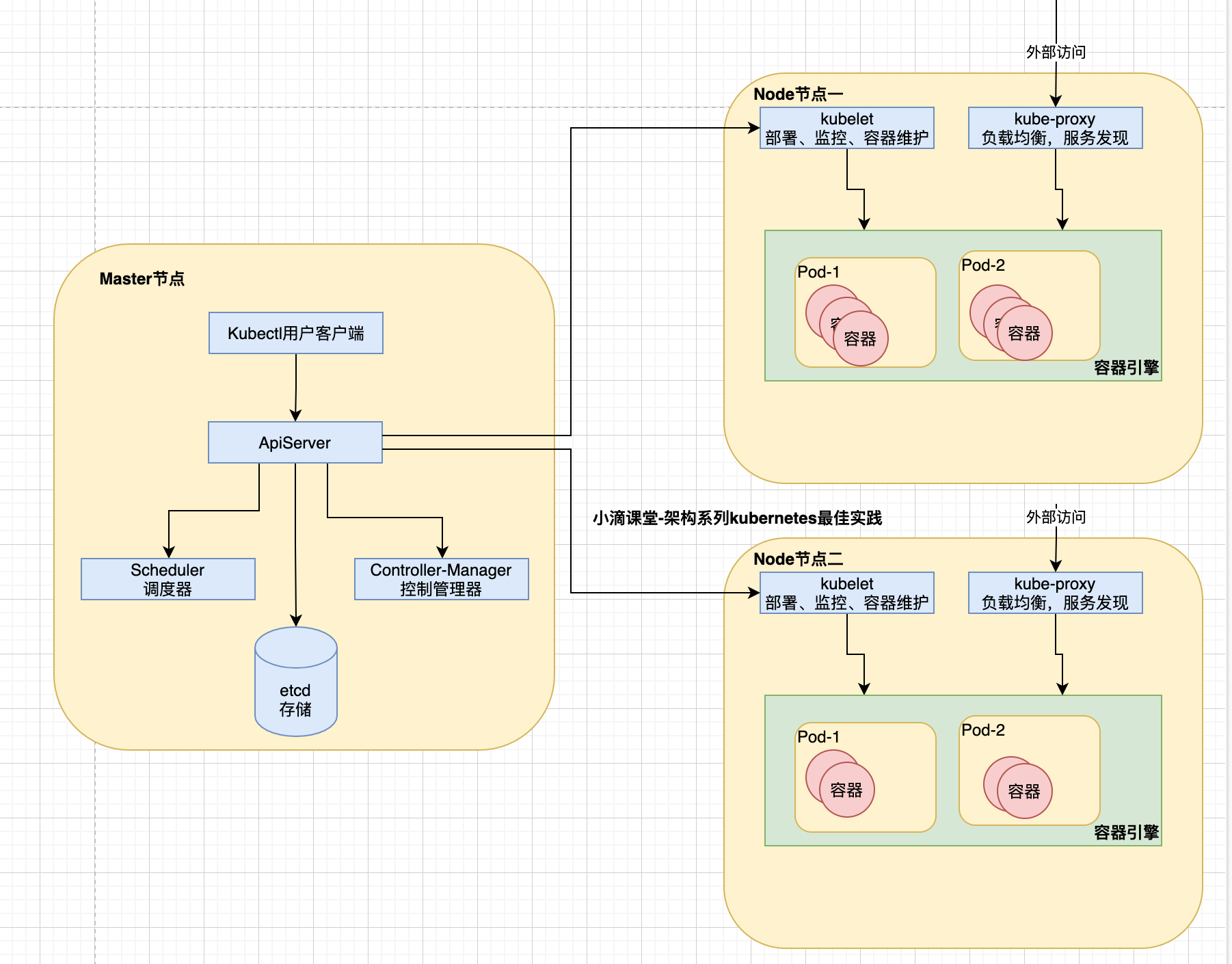

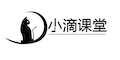

第3集 Kubernetes常见概念组件和整体架构讲解《上》

简介:Kubernetes常见组件和整体架构讲解《上》

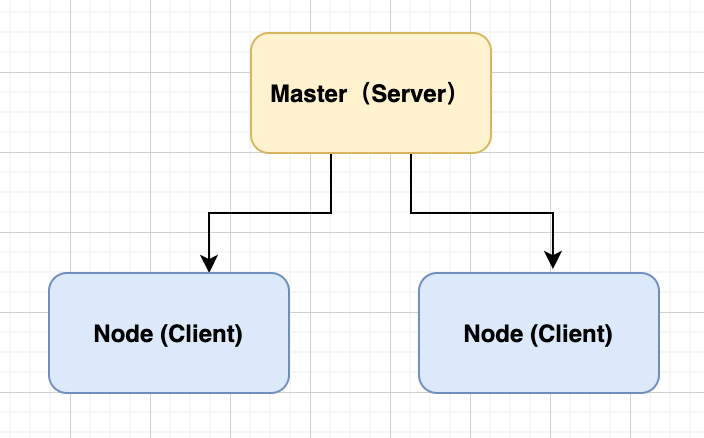

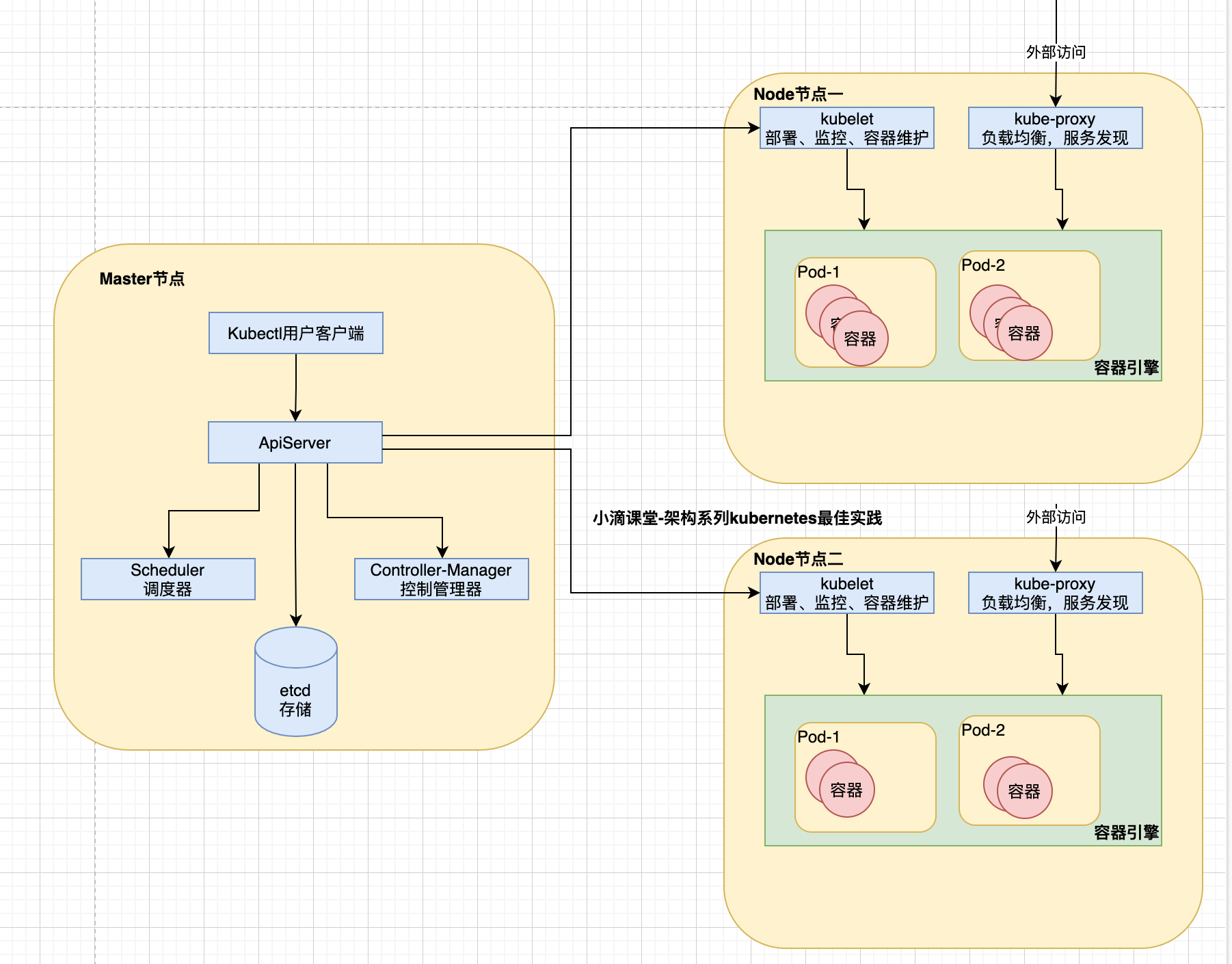

K8S整体架构,也是Client-Server模型

- 控制节点Master-Node,负责集群的管理

- 工作节点Worker-Node,负责为集群提供运行环境

kubernetes常见概念

Master

- 指的是集群控制节点(相当于整个集群的指挥中心),在每个Kubernetes集群里都需要有一个Master来负责整个集群的管理和控制

Node

- 除了master,k8s集群中的其他机器被称为Node节点,Node节点才是kubernetes集群中的工作负载节点

- 每个Node节点都会被master分配一些工作负载(docker容器),node节点上的docker负责容器的运行

Pod

Pod是一组容器, 在K8S中,最小的单位是Pod, 一个Pod可以包含多个容器,但通常情况下我们在每个Pod中仅使用一个容器

可以把Pod理解成豌豆荚, Pod内的每个容器是一颗颗豌豆

分类

- 自主创建:直接创建出来的Pod,这种pod删除后就没有了,也不会自动重建

- 控制器创建:通过控制器创建的pod,这类Pod删除了之后还会自动重建

Pod Controller

控制器是管理pod的中间层,只需要告诉Pod控制器,想要创建多少个什么样的Pod,它会创建出满足条件的Pod并确保每一个Pod资源处于用户期望的目标状态。如果Pod在运行中出现故障,它会基于指定策略重新编排Pod

通过它来实现对pod的管理,比如启动pod、停止pod、扩展pod的数量等等

类型

- ReplicaSet、Deployment、Horizontal Pod Autoscaler、DaemonSet等

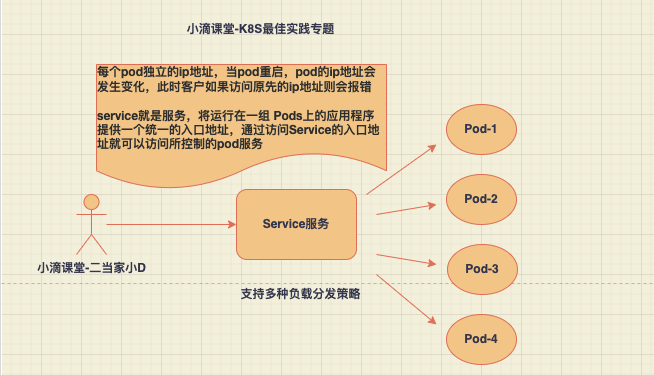

Service

- 在k8s里面,每个Pod都会被分配一个单独的IP地址,但这个IP地址会随着Pod的销毁而消失

- Service (服务)就是用来解决这个问题的, 对外服务的统一入口,用于为一组提供服务的Pod 抽象一个稳定的网络访问地址

- 一个Service可以看作一组提供相同服务的Pod的对外访问接口,作用于哪些Pod是通过标签选择器来定义的

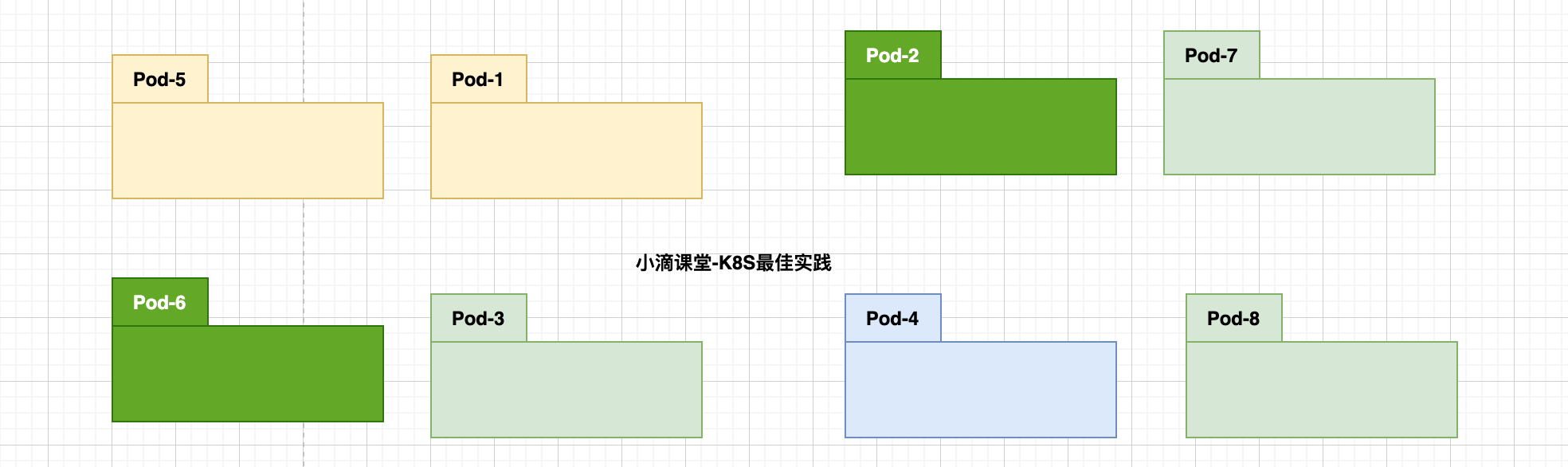

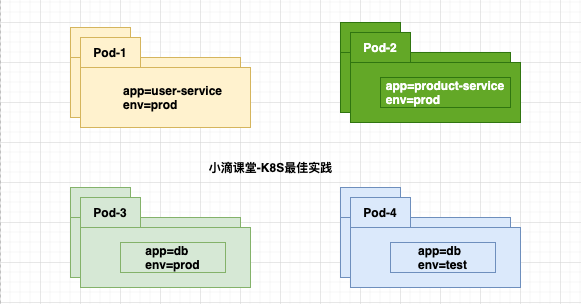

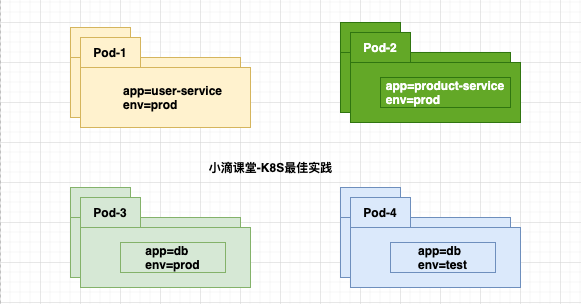

Label

K8S提供了一种机制来为Pod进行分类,那就是Label(标签),同一类pod会拥有相同的标签

Label的具体形式是key-value的标记对,可以在创建资源的时候设置,也可以在后期添加和修改

给某个资源对象定义一个Label,就相当于给它打了一个标签,可以通过Label Selector(标签选择器)查询和筛选拥有某些Label的资源对象,K8S通过这种方式实现了类似SQL的对象查询机制

应用场景

- 未使用前,分散难管理,如果需要部署不同版本的应用到不同的环境中,难操作

- 为Pod打上不同标签,使用Label组织的Pod,轻松管理

Label选择器

对应的资源打上标签后,可以使用标签选择器过滤指定的标签

标签选择器目前有两个

- 基于等值关系(等于、不等于)

- 基于集合关系(属于、不属于、存在)

NameSpace:

可以在一个物理集群上运行多个虚拟集群,这种虚拟集群被称作 命名空间,用来隔离pod的运行环境

同一个名字空间中的资源名称必须唯一,而不同名字空间之间则没有这个要求

NameSpace是不能嵌套的,每一个 Kubernetes 的资源都只能在一个NameSpace内

名字空间是在多个用户之间划分集群资源的一种方法(通过资源配额)

不必使用多个名字空间来分隔轻微不同的资源,例如同一软件的不同版本: 应该使用标签 来区分同一名字空间中的不同资源

Kubernetes 会创建四个初始NameSpace名称空间:

- default 没有指明使用其它名字空间的对象所使用的默认名字空间

- kube-system Kubernetes 系统创建对象所使用的名字空间

- kube-public

- kube-node-lease

应用分类

有状态应用

- 不能简单的实现负载均衡的服务,有数据产生的服务,Redis、MySql、RabbitMQ等

- 相关服务须通过一些较复杂的配置才能做到负载均衡。

- 有状态的应用,建议直接在物理机部署,方便维护管理

无状态应用

- 没有对应业务数据的应用,可以简单的实现负载均衡,复制一个节点即可快速扩容,如SpringCloud中的业务服务

- 无状态的应用适合部署在 Kubernetes(K8s)中或者容器中。

第4集 Kubernetes常见概念组件和整体架构讲解《下》

简介:Kubernetes常见组件和整体架构讲解《下》

K8S整体架构,也是Client-Server模型

控制节点Master-Node,负责集群的管理

- apiserver:提供操作【k8s集群资源】的唯一入口,RESTful方式请求,并提供认证、授权、访问控制、API注册和发现等

- scheduler:负责资源的调度,按照预定的调度策略,【计算】将Pod调度到相应的Node节点进行应用部署

- controller-manager:控制器管理中心,负责维护集群的状态,比如故障检测、滚动更新等,根据调度器的安排通知对应的节点创建pod

- etcd:存储中心,是兼具一致性和高可用性的键值数据库,可以作为保存 Kubernetes 所有集群数据的后台数据库

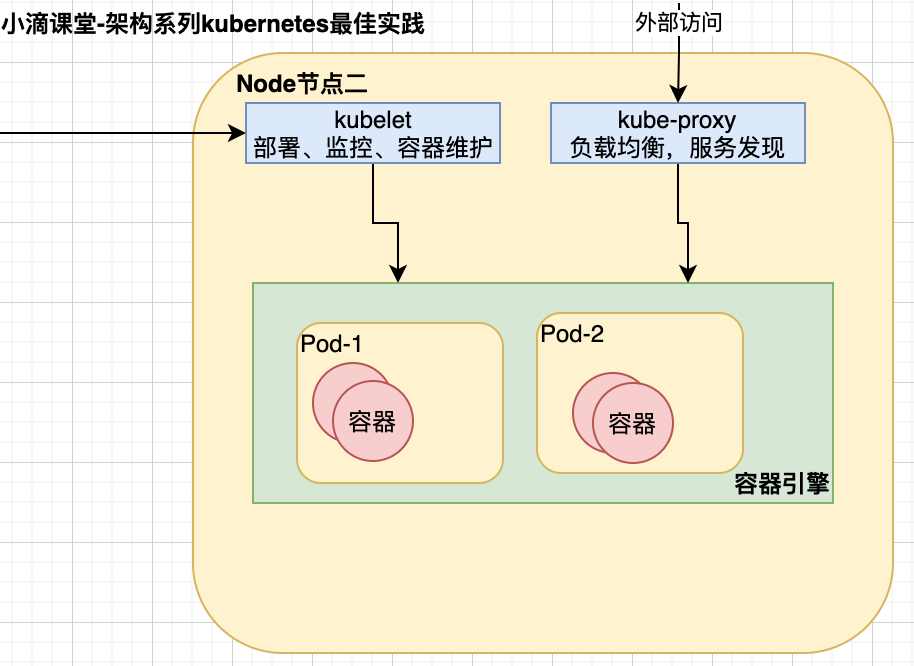

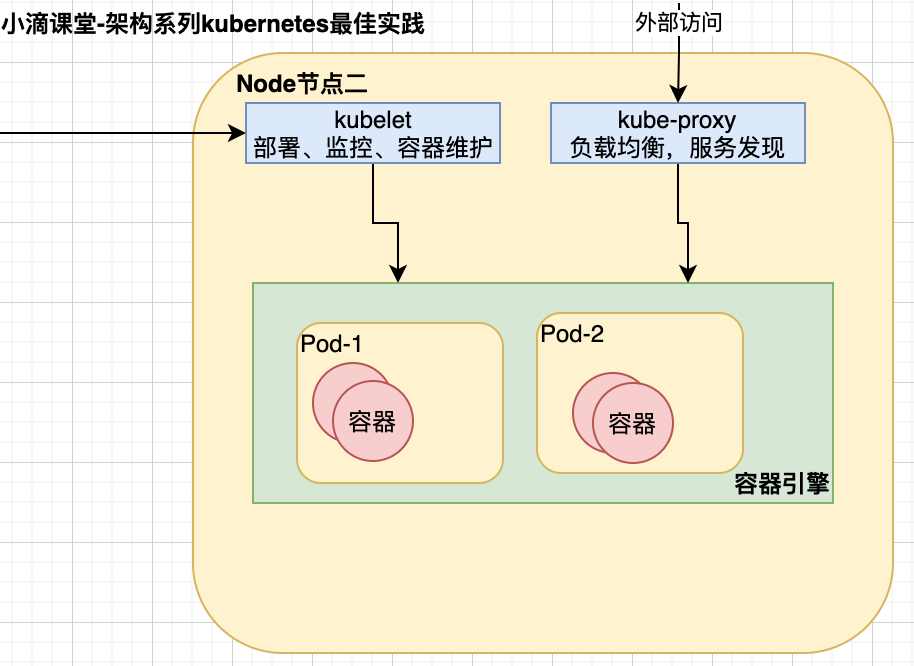

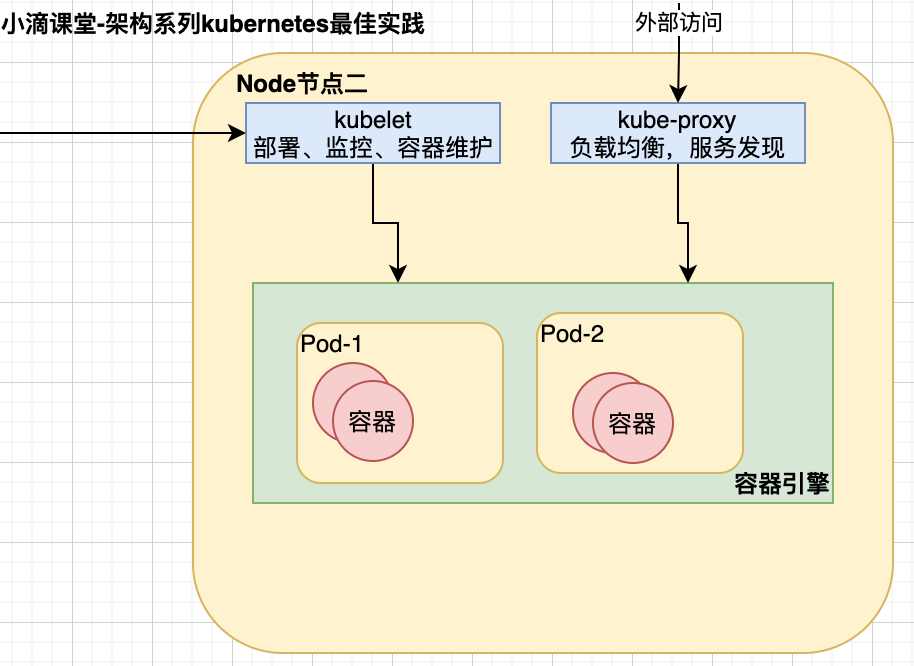

工作节点Worker-Node,负责为集群提供运行环境

- Node是Pod真正运行的主机,可以是物理机也可以是虚拟机, Node本质上不是K8S来创建的, K8S只是管理Node上的资源,为了管理Pod,每个Node节点上至少需要运行container runtime(Docker)、kubelet和kube-proxy服务

- kubelet:相当于主节点派到工作节点的一个代表,用于管理本机容器(相当于master节点的化身),负责维护容器的生命周期也负责Volume(CVI)和网络(CNI)的管理

- kube-proxy:负责为Service提供cluster内部的服务发现/网络代理/负载均衡等操作,为部署的应用程序提供访问入口,和apiserver是不一样的,后者是操作k8s集群内部的

- 架构图

愿景:"让编程不再难学,让技术与生活更加有趣"

愿景:"让编程不再难学,让技术与生活更加有趣"

更多架构课程请访问 xdclass.net

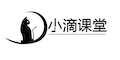

第三章 K8S常见集群架构和云服务器搭建实战

第1集 K8S常见集群架构和搭建方式介绍

简介:K8S常见集群架构和搭建方式介绍

k8s集群类型有多种

单master-Node集群

- 一主多从,推荐测试环境

- 服务器要求:服务器要求至少2台2核4G以上的云服务器

多master-Node集群

- 多主多从(高可用集群),推荐生产环境使用

- 服务器要求:服务器要求至少4台2核4G以上的云服务器

单节点k8s集群

- 单一个节点

- 服务器要求:服务器要求至少一台2核4G以上的云服务器

k8s搭建方式:

kubeadm搭建(推荐)

- 是一个K8s部署工具,提供kubeadm init和kubeadm join

- 用于快速搭建k8s集群,比较推荐

二进制包搭建

- 从github下载发行版的二进制包,手动部署每个组件, 组成Kubernetes集群

- 可以了解底层,但是步骤繁琐,坑比较多

Minikube搭建:

- 是一种轻量化的Kubernetes集群,是k8s社区为了帮助开发者和学习者能够更好学习和体验k8s功能而推出的,使用个人PC的虚拟化环境就快速构建启动单节点k8s

课程选择方案

方案一:Minikube搭建进行搭建,1台服务器

方案二:一主多从,共2台以上服务器

多种方案都可以,所以搭建不用纠结学习使用哪种,命令操作都一样的

每台机器配置需要 2核4G内存以上

云服务器说明【!!!!特别重要!!!!】

- 本地虚拟机或者其他系统,存在各种系统版本、内核参数调整、swap分区、网络问题等

- 每一个问题都可以都可以卡不少时间,浪费没必要的精力【本来3天的内容,愣是环境1周都没搭建好】

- 避免这些兼容性问题:统一使用阿里云Linux CentOS 7.8

- 如果多节点集群搭建,可以使用阿里云的按量付费选择多台ECS服务器即可

- 如果不会阿里云服务器,进入小滴课堂官网搜索【环境安装】学习

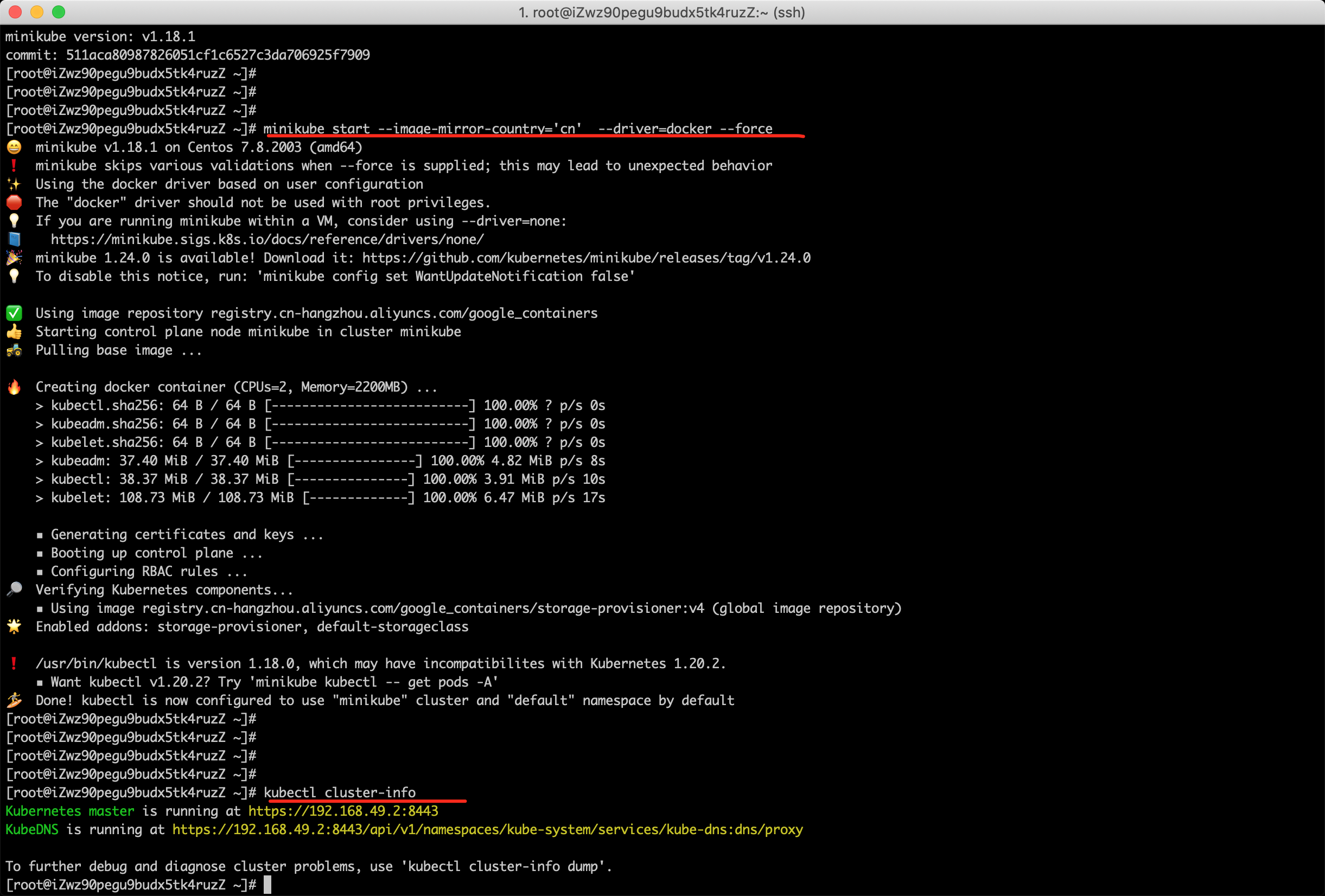

第2集 基于Minikube搭建单节点 k8s集群

简介:急速上手Minikube搭建单节点 k8s集群实战

Minikube搭建:

- 是一种轻量化的Kubernetes集群,是k8s社区为了帮助开发者和学习者能够更好学习和体验k8s功能而推出的,使用个人PC的虚拟化环境就快速构建启动单节点k8s

- 机器准备:阿里云 CentOS 7.x ,2核4g

安装

- 安装Docker

x# 1.先安装ymlyum install -y yum-utils device-mapper-persistent-data lvm2# 2.设置阿里云镜像sudo yum-config-manager --add-repo http://mirrors.aliyun.com/docker-ce/linux/centos/docker-ce.repo# 3.查看可安装的docker版本yum list docker-ce --showduplicates | sort -r#4. 安装dockeryum -y install docker-ce-20.10.10-3.el7#5. 查看docker版本docker -v#配置开机自启动systemctl enable docker.service#6. 启动dockersystemctl start docker#7. 查看docker 启动状态systemctl status docker- 配置镜像源

xxxxxxxxxxcat > /etc/yum.repos.d/kubernetes.repo << EOF[kubernetes]name=Kubernetesbaseurl=https://mirrors.aliyun.com/kubernetes/yum/repos/kubernetes-el7-x86_64enabled=1gpgcheck=0repo_gpgcheck=0gpgkey=https://mirrors.aliyun.com/kubernetes/yum/doc/yum-key.gpg https://mirrors.aliyun.com/kubernetes/yum/doc/rpm-package-key.gpgEOF- 安装kubectl

xxxxxxxxxxyum install -y kubectl-1.18.0- 安装minikube

xxxxxxxxxxcurl -LO https://storage.googleapis.com/minikube/releases/v1.18.1/minikube-linux-amd64 && sudo install minikube-linux-amd64 /usr/local/bin/minikube- 检查minikube安装是否成功

xxxxxxxxxxminikube version- 启动minikube

xxxxxxxxxxminikube start --image-mirror-country='cn' --driver=docker --force --kubernetes-version=1.18.1 --registry-mirror=https://registry.docker-cn.com#查看kubectl cluster-info

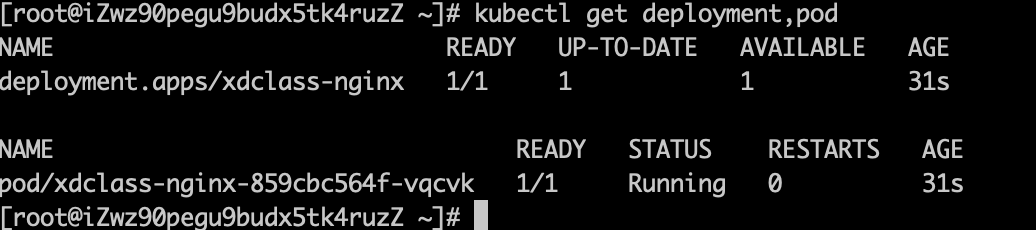

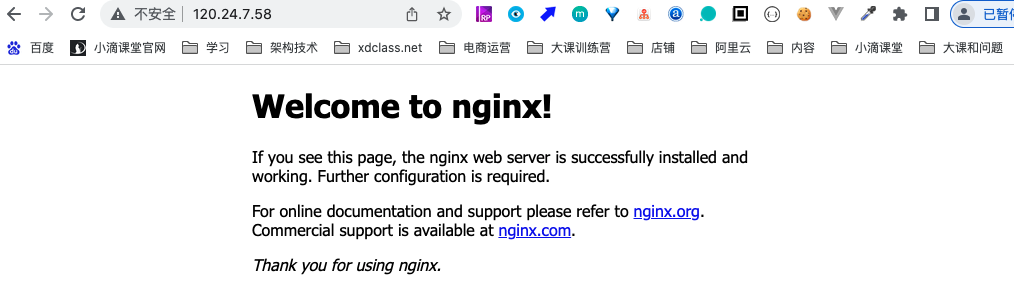

第3集 带你5分钟基于K8S单节点部署你的第一个K8S应用

简介:5分钟带你搭建 k8s部署第一个应用

- 查看k8s集群信息

xxxxxxxxxxkubectl cluster-info

- 查看节点信息

xxxxxxxxxxkubectl get node

- 查看内部组件

xxxxxxxxxxkubectl get pod -A

部署第一个K8S应用-Nginx,并通过公网ip访问

- 创建deployment(Pod控制器的一种, 直接删除pod后,会自动创建新的,需要删除deployment)

xxxxxxxxxxkubectl create deployment xdclass-nginx --image=nginx:1.23.0对比Docker部署docker run --name xdclass-nginx -p 8080:80 -d nginx:1.23.0- 查看deployment和pod

xxxxxxxxxxkubectl get deployment,pod,svc

- 暴露80端口, 就是service服务

xxxxxxxxxxkubectl expose deployment xdclass-nginx --port=80 --type=NodePort- 转发端口(Mini Kube临时)

xxxxxxxxxxkubectl port-forward --address 0.0.0.0 service/xdclass-nginx 80:80解释:kubectl port-forward 转发一个本地端口到 Pod 端口,不会返回数据,需要打开另一个终端来继续这个练习- 在浏览器访问公网ip(网络安全组记得开放80端口)

注意

Minikube的搭建跟用Kubeadm的有一点不一样

- Nodeport不能通过ip+端口直接访问,要通过minikube service(内网访问)和端口转发(公网访问)

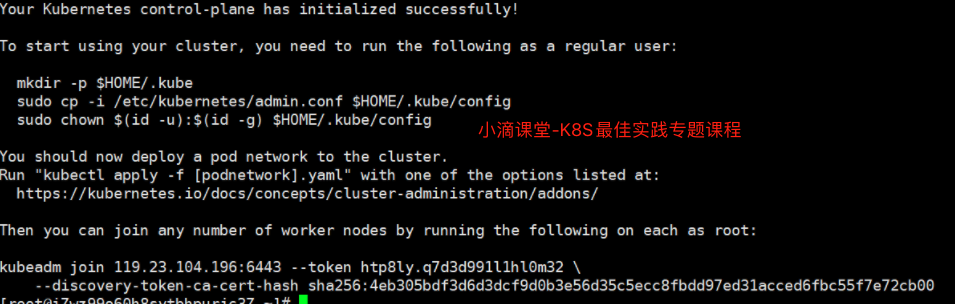

第4集 基于KubeAdm搭建多节点K8S集群

简介:基于KubeAdm搭建多节点K8S集群

安装步骤

安装docker(主节点+工作节点)

xxxxxxxxxx# 1.先安装ymlyum install -y yum-utils device-mapper-persistent-data lvm2# 2.设置阿里云镜像sudo yum-config-manager --add-repo http://mirrors.aliyun.com/docker-ce/linux/centos/docker-ce.repo# 3.查看可安装的docker版本yum list docker-ce --showduplicates | sort -r#4. 安装dockeryum -y install docker-ce-20.10.10-3.el7#5. 查看docker版本docker -v#配置开机自启动systemctl enable docker.service#6. 启动dockersystemctl start docker#7. 查看docker 启动状态systemctl status docker配置阿里云镜像源(主节点+工作节点)

xxxxxxxxxxcat > /etc/yum.repos.d/kubernetes.repo << EOF[kubernetes]name=Kubernetesbaseurl=https://mirrors.aliyun.com/kubernetes/yum/repos/kubernetes-el7-x86_64enabled=1gpgcheck=0repo_gpgcheck=0gpgkey=https://mirrors.aliyun.com/kubernetes/yum/doc/yum-key.gpg https://mirrors.aliyun.com/kubernetes/yum/doc/rpm-package-key.gpgEOF安装kubelet kubeadm kubectl(主节点+工作节点)

xxxxxxxxxxyum install -y kubelet-1.18.0 kubeadm-1.18.0 kubectl-1.18.0主节点初始化(主节点)

xxxxxxxxxxkubeadm init \--apiserver-advertise-address=172.31.101.9 \--image-repository registry.aliyuncs.com/google_containers \--kubernetes-version v1.18.0 \--service-cidr=10.96.0.0/12 \--pod-network-cidr=10.244.0.0/16只修改两个地方(master主机【内网IP】,k8s软件版本)说明:

- --apiserver-advertise-address:主节点的内网ip地址

- --image-repository 镜像仓库

- --kubernetes-version k8s版本

- --service-cidr + --pod-network-cidr 网段不重复即可

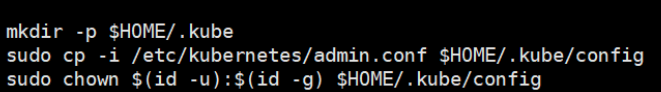

当初始化完成之后执行命令,并加入工作节点

- 主节点执行命令

加入工作节点

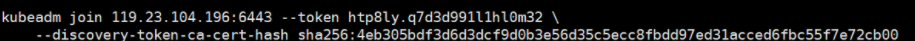

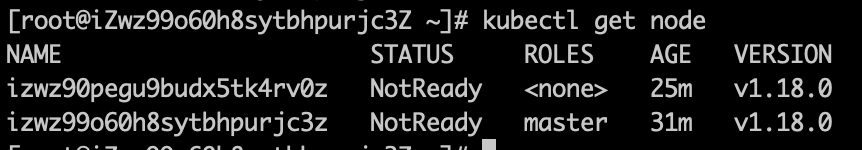

查看节点

xxxxxxxxxxkubectl get nodes#状态都是NotReady,需要配置网络插件安装网络插件

- 使用这个(官方改了源,直接使用这个命令)

xxxxxxxxxxkubectl apply -f https://raw.githubusercontent.com/flannel-io/flannel/master/Documentation/kube-flannel.yml- 下面的有问题(视频使用这个方式, 官方改了源,不可用,采用上面的命令即可)

xxxxxxxxxxkubectl apply -f flannel.yaml#flannel.yaml 文件内容---apiVersion: policy/v1beta1kind: PodSecurityPolicymetadata:name: psp.flannel.unprivilegedannotations:seccomp.security.alpha.kubernetes.io/allowedProfileNames: docker/defaultseccomp.security.alpha.kubernetes.io/defaultProfileName: docker/defaultapparmor.security.beta.kubernetes.io/allowedProfileNames: runtime/defaultapparmor.security.beta.kubernetes.io/defaultProfileName: runtime/defaultspec:privileged: falsevolumes:- configMap- secret- emptyDir- hostPathallowedHostPaths:- pathPrefix: "/etc/cni/net.d"- pathPrefix: "/etc/kube-flannel"- pathPrefix: "/run/flannel"readOnlyRootFilesystem: false# Users and groupsrunAsUser:rule: RunAsAnysupplementalGroups:rule: RunAsAnyfsGroup:rule: RunAsAny# Privilege EscalationallowPrivilegeEscalation: falsedefaultAllowPrivilegeEscalation: false# CapabilitiesallowedCapabilities: ['NET_ADMIN']defaultAddCapabilities: []requiredDropCapabilities: []# Host namespaceshostPID: falsehostIPC: falsehostNetwork: truehostPorts:- min: 0max: 65535# SELinuxseLinux:# SELinux is unsed in CaaSPrule: 'RunAsAny'---kind: ClusterRoleapiVersion: rbac.authorization.k8s.io/v1beta1metadata:name: flannelrules:- apiGroups: ['extensions']resources: ['podsecuritypolicies']verbs: ['use']resourceNames: ['psp.flannel.unprivileged']- apiGroups:- ""resources:- podsverbs:- get- apiGroups:- ""resources:- nodesverbs:- list- watch- apiGroups:- ""resources:- nodes/statusverbs:- patch---kind: ClusterRoleBindingapiVersion: rbac.authorization.k8s.io/v1beta1metadata:name: flannelroleRef:apiGroup: rbac.authorization.k8s.iokind: ClusterRolename: flannelsubjects:- kind: ServiceAccountname: flannelnamespace: kube-system---apiVersion: v1kind: ServiceAccountmetadata:name: flannelnamespace: kube-system---kind: ConfigMapapiVersion: v1metadata:name: kube-flannel-cfgnamespace: kube-systemlabels:tier: nodeapp: flanneldata:cni-conf.json: |{"cniVersion": "0.2.0","name": "cbr0","plugins": [{"type": "flannel","delegate": {"hairpinMode": true,"isDefaultGateway": true}},{"type": "portmap","capabilities": {"portMappings": true}}]}net-conf.json: |{"Network": "10.244.0.0/16","Backend": {"Type": "vxlan"}}---apiVersion: apps/v1kind: DaemonSetmetadata:name: kube-flannel-ds-amd64namespace: kube-systemlabels:tier: nodeapp: flannelspec:selector:matchLabels:app: flanneltemplate:metadata:labels:tier: nodeapp: flannelspec:affinity:nodeAffinity:requiredDuringSchedulingIgnoredDuringExecution:nodeSelectorTerms:- matchExpressions:- key: beta.kubernetes.io/osoperator: Invalues:- linux- key: beta.kubernetes.io/archoperator: Invalues:- amd64hostNetwork: truetolerations:- operator: Existseffect: NoScheduleserviceAccountName: flannelinitContainers:- name: install-cniimage: lizhenliang/flannel:v0.11.0-amd64command:- cpargs:- -f- /etc/kube-flannel/cni-conf.json- /etc/cni/net.d/10-flannel.conflistvolumeMounts:- name: cnimountPath: /etc/cni/net.d- name: flannel-cfgmountPath: /etc/kube-flannel/containers:- name: kube-flannelimage: lizhenliang/flannel:v0.11.0-amd64command:- /opt/bin/flanneldargs:- --ip-masq- --kube-subnet-mgrresources:requests:cpu: "100m"memory: "50Mi"limits:cpu: "100m"memory: "50Mi"securityContext:privileged: falsecapabilities:add: ["NET_ADMIN"]env:- name: POD_NAMEvalueFrom:fieldRef:fieldPath: metadata.name- name: POD_NAMESPACEvalueFrom:fieldRef:fieldPath: metadata.namespacevolumeMounts:- name: runmountPath: /run/flannel- name: flannel-cfgmountPath: /etc/kube-flannel/volumes:- name: runhostPath:path: /run/flannel- name: cnihostPath:path: /etc/cni/net.d- name: flannel-cfgconfigMap:name: kube-flannel-cfg查看节点状态

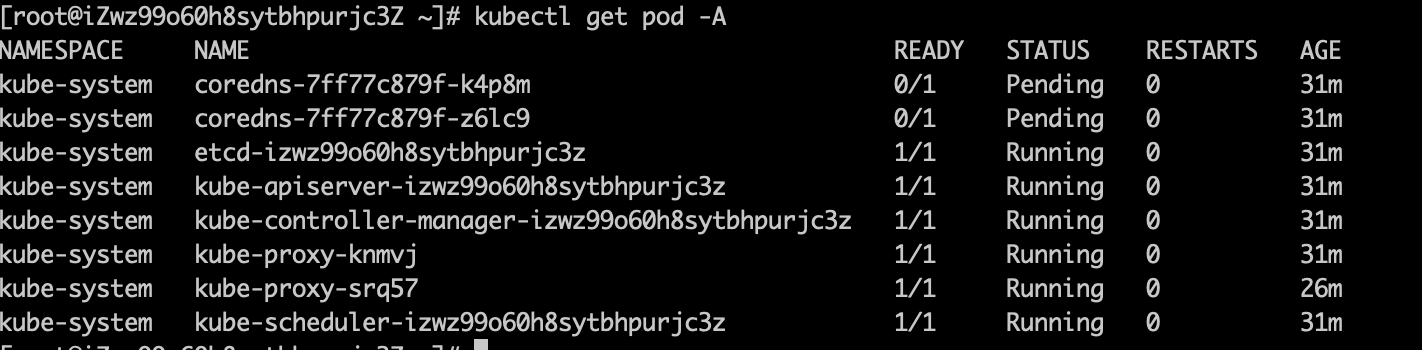

xxxxxxxxxxkubectl get node查看系统pod状态

xxxxxxxxxxkubectl get pods -n kube-system

第5集 带你5分钟基于K8S集群部署你的第一个K8S应用

简介: 带你5分钟基于K8S集群部署你的第一个K8S应用

- 查看k8s集群信息

xxxxxxxxxxkubectl cluster-info

- 查看节点信息

xxxxxxxxxxkubectl get node

- 查看内部组件

xxxxxxxxxxkubectl get pod -A

部署第一个K8S应用-Nginx,并通过公网ip访问

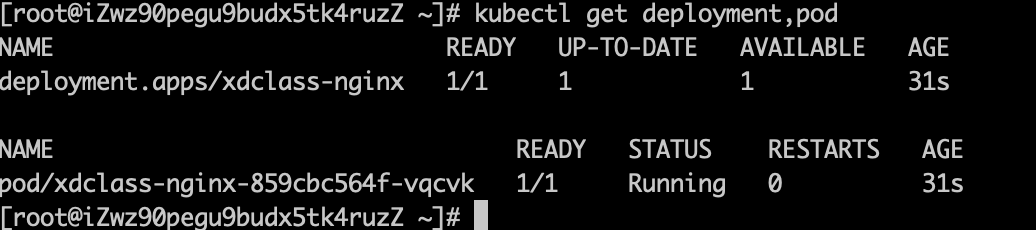

- 创建deployment(Pod控制器的一种)

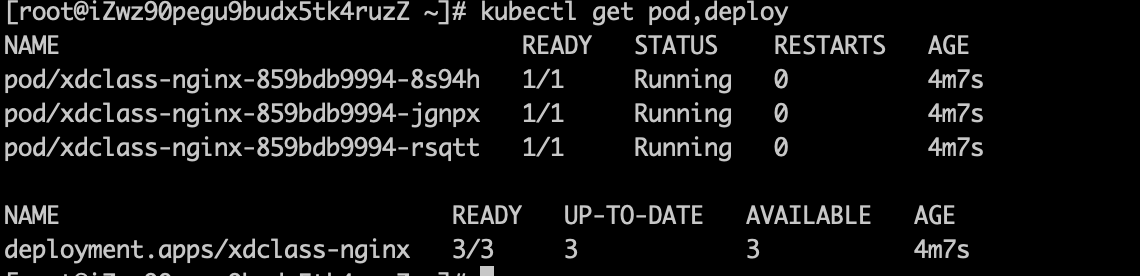

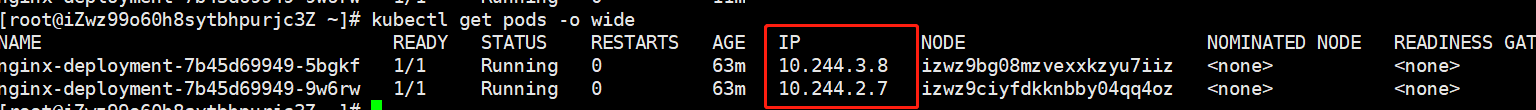

xxxxxxxxxxkubectl create deployment xdclass-nginx --image=nginx:1.23.0- 查看deployment和pod

xxxxxxxxxxkubectl get deployment,pod,svc

- 暴露80端口,创建service

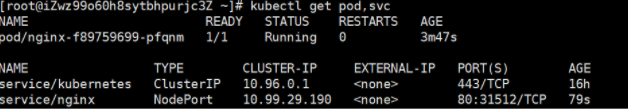

xxxxxxxxxxkubectl expose deployment xdclass-nginx --port=80 --type=NodePort- 查看端口映射

xxxxxxxxxxkubectl get pod,svc

在浏览器访问, 工作节点开放端口31512,访问工作节点ip:31512(网络安全组记得开放31512端口)

- master、node节点访问这个 开放的端口都可以

注意

- Minikube的搭建跟用Kubeadm的有一点不一样

- Kubeadm部署,暴露端口对外服务,会随机选端口,默认范围是30000~32767,可以修改指定,后续会讲

愿景:"让编程不再难学,让技术与生活更加有趣"

愿景:"让编程不再难学,让技术与生活更加有趣"

更多架构课程请访问 xdclass.net

第四章 Kubernetes核心资源管理操作实战

第1集 Kubernetes常见资源管理命令介绍

简介:Kubernetes常见资源管理命令介绍

概念

- k8s是一个服务器集群系统,用户可以在集群中部署各种服务,也就是在k8s集群上运行一个个的容器

- 在k8s中,pod是最小的管理单元而非容器,一个pod中可以有多个容器

- 在k8s集群中,所有内容都可以被抽象为资源,通过操作资源来管理k8s集群

使用kubectl来管理资源

kubectl用法:

xxxxxxxxxxkubectl [command] [TYPE] [NAME] [flags]- commad:对资源具体的操作,如create创建、 get获取 、 delete删除

- TYPE:指定资源类型,大小写敏感

- NAME:指定资源的名称,大小写敏感,如果省略名称则显示所有资源

- flags:指定可选的参数,如可用-s或者-server指定Kubernetes API server的地址和端口

例子

xxxxxxxxxx#获取全部节点kubectl get node#获取全部podkubectl get pod#查看某个pod内容kubectl get pod pod_name#获取全部名称空间kubectl get ns#查看创建的资源kubectl get pod,svc,deploy# 删除nginx pod,如果是靠deploy控制器创建的pod, 直接删除则会自动创建新的;kubectl delete pod pod名称# 如果需要删除则直接删除depoly控制器即可,pod会被删除资源管理方式:

命令式对象管理:直接使用命令去操作资源

xxxxxxxxxxkubectl run 资源名称 --image=镜像名称 --port=端口号例子:kubectl run xdclass-nignx-pod --image=nginx:1.23.0 --port=80kubectl create deployment xdclass-nginx --image=nginx:1.23.0命令式对象配置:通过命令配置和配置文件去操作资源

xxxxxxxxxxkubectl create -f 配置文件名称.yaml声明式对象配置:通过apply和配置文件操作资源

xxxxxxxxxxkubectl apply -f 配置文件名称.yaml

yaml例子

xxxxxxxxxxapiVersion: apps/v1kind: Deploymentmetadata:name: nginx-deploymentlabels:app: nginx-deploymentspec:replicas: 1selector:matchLabels:app: nginx-podtemplate:metadata:labels:app: nginx-podspec:containers:- name: nginximage: nginx:1.23.0imagePullPolicy: IfNotPresentports:- containerPort: 80xxxxxxxxxxapiVersion: v1kind: Podmetadata:name: nginxspec:containers:- image: nginx:1.23.0name: podports:- name: nginx-portcontainerPort: 80protocol: TCP

kubectl create 和 kubectl apply的区别:

- kubectl create 命令首次执行时会创建资源,当再次执行的时候会报错,因为资源名称在同一命名空间内是唯一的

- kubectl apply在首次执行的时候也会创建对应的资源,当再次执行的时候会根据配置文件进行升级、扩容等操作,即使配置文件没有变化也不影响

第2集 Kubernetes资源文件yaml参数介绍

简介:Kubernetes资源文件yaml参数介绍

yaml介绍

yaml是一个类似 XML、JSON 的标记性语言。它强调以数据为中心,并不是以标识语言为重点。

例如SpringBoot的配置文件application.yml也是一个yaml格式的文件

语法格式:

- 通过缩进表示层级关系

- 不能使用tab进行缩进,只能使用空格

- 一般开头缩进两个空格

- 大小写敏感

- 字符后缩进一个空格,如冒号、逗号

- 如果需要将多段yaml配置放在一个文件中,中间要使用

---分隔 - 使用#表示注释

yaml文件的编写:

不需要从零手写,快速编写yaml文件,通过命令导出新的yaml文件

xxxxxxxxxx#创建nginx资源文件并且不启动资源kubectl create deployment xdclass-nginx --image=nginx:1.23.0 -o yaml --dry-run=client > nginx.yaml#查看nginx.yamlcat nginx.yaml精简版 yaml

xxxxxxxxxxapiVersion: apps/v1kind: Deploymentmetadata:creationTimestamp: nulllabels:app: xdclass-nginxname: xdclass-nginxspec:replicas: 1selector:matchLabels:app: xdclass-nginxstrategy: {}template:metadata:creationTimestamp: nulllabels:app: xdclass-nginxspec:containers:- image: nginx:1.23.0name: nginxresources: {}status: {}

pod的yaml文件示例

yaml文件示例:

xxxxxxxxxx# pod的最基础的yaml文件最少需要以下的几个参数apiVersion: v1 # API版本号,注意:具有多个,不同的对象可能会使用不同APIkind: Pod # 对象类型,podmetadata: # 元数据name: string # POD名称namespace: string # 所属的命名空间spec: # specification of the resource content(资源内容的规范)containers: # 容器列表- name: string # 容器名称image: string # 容器镜像

常用字段含义

必须存在的属性

参数名 字段类型 说明 version String k8s API的版本,可使用kubectl api-versions命令查询 kind String 这里指定k8s资源的类型,比如Pod、Deployment metadata Object 元数据对象,固定写值metadata metadata-name String 元数据对象的名字,比如命名pod的名字 metadata-namespace String 元数据对象的命名空间 spec Object 详细定义对象,固定值写Spec spec.container[] list spec对象的容器列表定义 spec.container[].name String 容器对象的名字 spec.container[].image String 定义要用到的对象名称 spec主要对象【大体知道即可】

- spec.containers

参数名 字段类型 说明 spec.containers[].name String 定义容器的名字 spec.containers[].image String 定义要用到的镜像名称 spec.containers[].imagePullPolicy String 定义镜像拉取策略,有Always、Never、IfNotPresent三个值可选(1)Always:意思是每次都尝试重新拉取镜像 (2)Never:表示仅使用本地镜像 (3)IfNotPresent:如果本地有镜像就使用本地镜像,没有就拉取在线镜像。 上面三个值都没设置的话,默认是Always。 spec.containers[].command[] List 指定容器启动命令,因为是数组可以指定多个,不指定则使用镜像打包时使用的启动命令。 spec.containers[].args[] List 指定容器启动命令参数,因为是数组可以指定多个。 spec.containers[].workingDir String 指定容器的工作目录 spec.containers[].volumeMounts[] List 指定容器内部的存储卷配置 spec.containers[].volumeMounts[].name String 指定可以被容器挂载的存储卷的名称 spec.containers[].volumeMounts[].mountPath String 指定可以被容器挂载的存储卷的路径 spec.containers[].volumeMounts[].readOnly String 设置存储卷路径的读写模式,ture 或者false,默认为读写模式 spec.containers[].ports[] List 指定容器需要用到的端口列表 spec.containers[].ports[].name String 指定端口名称 spec.containers[].ports[].containerPort String 指定容器需要监听的端口号 spec.containers[].ports[].hostPort String 指定容器所在主机需要监听的端口号,默认跟上面containerPort相同,注意设置了hostPort 同一台主机无法启动该容器的相同副本(因为主机的端口号不能相同,这样会冲突) spec.containers[].ports[].protocol String 指定端口协议,支持TCP和UDP,默认值为TCP spec.containers[].env[] List 指定容器运行前需设置的环境变量列表 spec.containers[].env[].name String 指定环境变量名称 spec.containers[].env[].value String 指定环境变量值 spec.containers[].resources Object 指定资源限制和资源请求的值(这里开始就是设置容器的资源上限) spec.containers[].resources.limits Object 指定设置容器运行时资源的运行上限 spec.containers[].resources.limits.cpu String 指定CPU的限制,单位为core数,将用于 docker run --cpu-shares参数(这里前面文章Pod资源限制有讲过) spec.containers[].resources.limits.memory String 指定MEM内存的限制,单位为MIB、GiB spec.containers[].resources.requests Object 指定容器启动和调度时的限制设置 spec.containers[].resources.requests.cpu String CPU请求,单位为core数,容器启动时初始化可用数量 spec.containers[].resources.requests.memory String 内存请求,单位为MIB、GiB,容器启动的初始化可用数量 - spec.volumes

参数名 字段类型 说明 spec.volumes[].name String 定义Pod的共享存储卷的名称,容器定义部分的spec.containers[].volumeMounts[].name的值跟这里是一样的。 spec.volumes[].emptyDir Object 指定Pod的临时目录,值为一个空对象:emptyDir:{} spec.volumes[].hostPath Object 指定挂载Pod所在宿主机的目录 spec.volumes[].hostPath.path String 指定Pod所在主机的目录,将被用于容器中mount的目录 spec.volumes[].secret Object 指定类型为secret的存储卷,secret意为私密、秘密的意思,很容易理解,它存储一些密码,token或者秘钥等敏感安全文件。挂载集群预定义的secret对象到容器内部。 spec.volumes[].configMap Object 指定类型为configMap的存储卷,表示挂载集群预定义的configMap对象到容器内部。 spec.volumes[].livenessProbe Object 指定Pod内容器健康检查的设置,当探测无响应几次后,系统将自动重启该容器。这个在前面的文章中有说,具体可以设置:exec、httpGet、tcpSocket。 spec.volumes[].livenessProbe.exec Object 指定Pod内容器健康检查的设置,确定是exec方式 spec.volumes[].livenessProbe.exec.command[] String 指定exec方式后需要指定命令或者脚本,用这个参数设置 spec.volumes[].livenessProbe.httpGet Object 指定Pod内容器健康检查的设置,确定是httpGet方式 spec.volumes[].livenessProbe.tcpSocket Object 指定Pod内容器健康检查的设置,确定是tcpSocket方式 spec.volumes[].livenessProbe.initialDelaySeconds Number 容器启动完成后手册探测的时间设置,单位为s spec.volumes[].livenessProbe.timeoutSeconds Number 对容器健康检查的探测等待响应的超时时间设置,单位为S,默认为1s。若超过该超时时间设置,则认为该容器不健康,会重启该容器。 spec.volumes[].livenessProbe.periodSeconds Number 对容器健康检查的定期探测时间设置,单位为S,默认10s探测一次。

第3集 Kubernetes常见资源类型和命令速览

简介:Kubernetes常见资源类型和缩写

- 查看资源类型和命令

xxxxxxxxxx#查看资源kubectl api-resources#查看命令帮助kubectl --help

常用资源分类和缩写

节点 nodes ,缩写 no

名称空间 namespaces,缩写ns

pod资源 pods, 缩写 po

pod控制器

- replicasets,缩写rs

- deployments,缩写 deploy

服务发现

- 统一pod对外接口 services ,缩写 svc

- 统一pod对外接口ingress ,缩写 ing

存储资源

- persistentvolumes,缩写pv

- persistentvolumeclaims,缩写pvc

- 常用资源操作命令

| 命令分类 | 命令 | 翻译 |

|---|---|---|

| 基本命令 | create | 创建资源 |

| delete | 删除资源 | |

| edit | 编辑资源 | |

| get | 获取资源 | |

| patch | 更新资源 | |

| explain | 解释资源 | |

| 运行和调试 | run | 运行指定的镜像 |

| expose | 暴露服务 | |

| describe | 描述资源内部信息 | |

| logs | 打印容器在 pod 中的日志 | |

| attach | 进入运行中的容器 | |

| exec | 执行容器中的一个命令 | |

| cp | 在Pod内外复制文件 | |

| scale | 扩容/缩容Pod的数量 | |

| autoscale | 扩容/缩容Pod的数量 | |

| 高级命令 | apply | rc |

| label | 标签 | |

| 其他命令 | cluster-info | 集群信息 |

| version | 版本 |

愿景:"让编程不再难学,让技术与生活更加有趣"

愿景:"让编程不再难学,让技术与生活更加有趣"

更多架构课程请访问 xdclass.net

第五章 Kubernetes核心资源之名称空间和Pod实战

第1集 Kubernetes名称空间介绍和资源操作实战

简介:Kubernetes名称空间介绍和资源操作实战

什么是名称空间Namespace

- Namespace是k8s系统中的一种非常重要资源,它的主要作用是用来实现多套环境的资源隔离或者多用户的资源隔离。

- 默认情况下,k8s集群中的所有的Pod都是可以相互访问的。

- 但是在实际中,可能不想让两个Pod之间进行互相的访问,那此时就可以将两个Pod划分到不同的namespace下。

- k8s通过将集群内部的资源分配到不同的Namespace中,可以形成逻辑上的"组",以方便不同的组的资源进行隔离使用和管理。

- 可以通过k8s的授权机制,将不同的namespace交给不同租户进行管理,这样就实现了多租户的资源隔离。

- 结合k8s的资源配额机制,限定不同租户能占用的资源,例如CPU使用量、内存使用量等等,来实现租户可用资源的管理。

Kubernetes 会创建四个初始NameSpace名称空间:

default

- 没有指明使用其它名字空间的对象所使用的默认名字空间

kube-system

- Kubernetes 系统创建对象所使用的名字空间

kube-public

- 是自动创建的,命名空间下的资源可以被所有人访问(包括未认证用户)

kube-node-lease

- 集群节点之间的心跳维护

查看所有命令空间

xxxxxxxxxxkubectl get namespace缩写kubectl get ns

命名空间操作

xxxxxxxxxx# 创建新命名空间kubectl create ns dev# 查看命名空间详情kubectl describe ns dev# 指定输出格式 命令:kubectl get ns ns名称 -o 格式参数, 常见的是wide、json、yaml# 输出命名空间详细信息kubectl get ns dev -o yaml# 删除命名空间kubectl delete ns dev# 基于配置文件方式 namespace-dev.yamlapiVersion: v1kind: Namespacemetadata:name: dev创建:kubectl create -f namespace-dev.yaml创建:kubectl apply -f namespace-dev.yaml删除:kubectl delete -f namespace-dev.yaml

第2集 Kubernetes的Pod资源讲解实战

简介:K8S中最小的单位Pod资源讲解实战

Pod

Pod是一组容器, 在K8S中,最小的单位是Pod, 一个Pod可以包含多个容器,但通常情况下我们在每个Pod中仅使用一个容器,可以把Pod理解成豌豆荚, Pod内的每个容器是一颗颗豌豆

Pod 的核心是运行容器,必须指定容器引擎,比如 Docker是其中一种技术

分类

- 自主创建:直接创建出来的Pod,这种pod删除后就没有了,也不会自动重建

- 控制器创建:通过控制器创建的pod,这类Pod删除了之后还会自动重建

Pod运行容器数量

- 每个Pod中一个容器,的模式是最常见的用法,Pod是容器的简单封装,K8S管理Pod而不是直接管理容器

- 一个Pod中同时运行多个需要互相协作的容器,它们共享资源,同一个Pod中的容器可以作为service单位

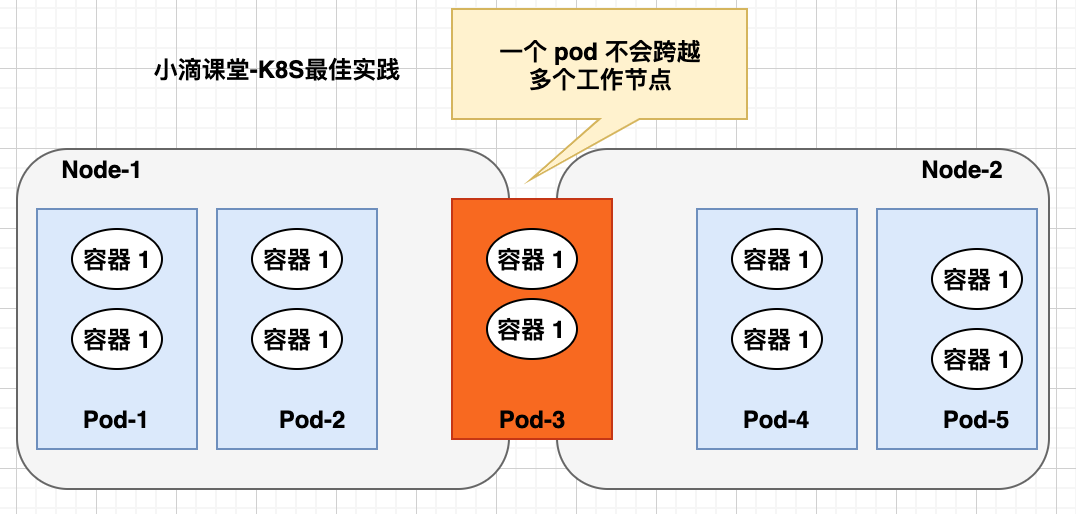

Pod网络

- 一个 pod 包含一组容器,一个 pod 不会跨越多个工作节点

- 每个Pod都会被分配一个唯一的IP地址,Pod中的所 有容器共享网络空间,包括IP地址和端口

- Pod内 部的容器可以使用localhost互相通信

Pod存储

- Volume 也可以用来持久化Pod中的存储资源,以防容器重启后文件丢失

- Pod中 的所有容器都可以访问共享的Volume

K8S集群中的系统组件都是以Pod方式运行的

xxxxxxxxxxkubectl get pod -n kube-system命令

xxxxxxxxxx#查看创建的资源kubectl get pod,deploy# 删除nginx pod,如果是靠deploy控制器创建的pod, 直接删除则会自动创建新的;kubectl delete pod pod名称 -n 名称空间#通过控制器创建pod,则删除控制器即可kubectl delete pod控制器名称 -n 名称空间# 运行pod,指定名称空间kubectl run xdclass-nignx-pod --image=nginx:1.23.0 --port=80 --namespace dev# 通过 deployment控制器导出yaml文件,指定名称空间kubectl create deployment xdclass-nginx --image=nginx:1.23.0 --namespace dev -o yaml --dry-run=client > nginx.yaml#一次性部署3个pod,修改nginx.yaml 下面的从 1 改为 3#使用 kubectl apply -f nignx.yamlspec:replicas: 3

访问

xxxxxxxxxx#查看某个名称空间下 pod 更多信息kubectl get pod -n dev -o wide#访问pod,同个集群下面,master和node节点都可以访问(同个K8S内部网络)curl 10.244.1.20#备注,如果使用了Service,即NodePort端口,开放了网络安全组则外网也可以访问

第3集 Kubernetes中Pod资源进阶底层讲解

简介:Kubernetes中Pod资源进阶底层讲解

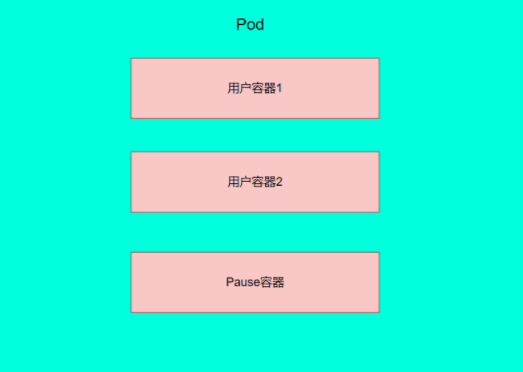

Pod底层原型

每个Pod中都可以包含一个或者多个容器,这些容器可以分为两类

用户程序所在的容器,数量可多可少

Pause容器,这是每个Pod都会有的一个根容器,它的作用有两个:

以它为依据,评估整个Pod的健康状态

可以在根容器上设置Ip地址,其它容器都此Ip(Pod IP),以实现Pod内部的网路通信

实现机制

通过共享网络

- 通过pause容器,把其他业务容器加入到pause容器里面,让所有业务容器在同一个namespace中,可以实现网络共享

通过共享存储

- 引入数据卷volume的概念,使用数据卷进行持久化存储

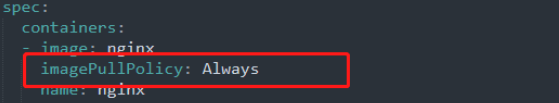

pod镜像拉取策略imagesPullPolicy

- IfNotPresent:默认值,镜像在宿主机上不存在时才拉取

xxxxxxxxxx- Always:每次创建pod都会重新拉取一次镜像

xxxxxxxxxx- Never:pod永远不会主动拉取这个镜像

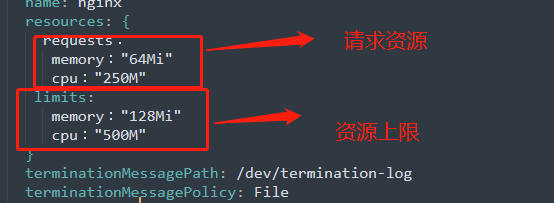

pod资源限制

说明:

- requests: 资源请求量,当容器运行时,向Node申请的最少保障资源

- limits: 资源上限,容器在Node上所能消耗的最高上限

xxxxxxxxxxresources:requests:memory:"内存大小"cpu:"cpu占用大小"limits:memory:"内存占用大小"cpu:"cpu占用大小"——————————————————————————————————————————————CPU 资源以 CPU 单位度量。Kubernetes 中的一个 CPU 等同于:1 个 AWS vCPU1 个 Azure vCore例如 100m CPU、100 milliCPU 和 0.1 CPU 都相同文档地址:https://kubernetes.io/zh-cn/docs/tasks/configure-pod-container/assign-cpu-resource/

pod的创建流程

- 通过kubectl apply -f xxx.yaml 创建pod

- 创建pod的时候:

xxxxxxxxxx- kubectl向apiserver发送创建pod的请求- apiserver把pod的创建信息存储到etcd进行保存- scheduler监听到未绑定node的pod资源,通过调度算法对该pod资源选定一个合适的node进行绑定,然后响应给apiserver,更新pod状态并存储到etcd中- 在绑定的node中,Controller-Manager通知kubelet收到分配到自身节点上的pod,调用容器引擎api创建容器,并把容器状态响应给apiserver

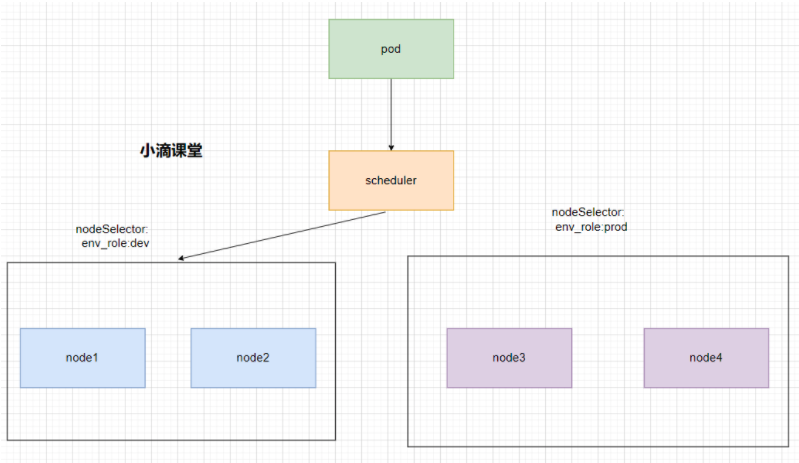

Pod的调度策略

在默认情况下,一个Pod在哪个Node节点上运行,是由Scheduler组件采用相应的算法计算出来的,这个过程是不受人工控制的。但是在实际使用中,这并不满足的需求,因为很多情况下,我们想控制某些Pod到达某些节点上,那么应该怎么做呢?这就要求了解k8s对Pod的调度规则

影响pod调度的因素:

pod资源限制:scheduler根据requests找到足够大小的node进行调度

节点选择器标签(nodeSelector)

- 把节点进行区分,例如dev开发环境和prod生产环境

- 例如,当前需要把pod调度到开发环境中,则可以通过scheduler将pod调度到标签选择器中为env_role:dev的node中

xxxxxxxxxxnodeSelector:env_role:dev/prod

第4集 Kubernetes标签Label和标签选择器实战

简介:Kubernetes标签Label和标签选择器实战

Label

K8S提供了一种机制来为资源进行分类,那就是Label(标签),同一类资源会拥有相同的标签

具体形式是key-value的标记对,可以在创建资源的时候设置,也可以在后期添加和修改

可以附加到各种资源对象上,如Node,Pod,Service,RC等,一个资源拥有多个标签,可以实现不同维度的管理

给某个资源对象定义一个Label,就相当于给它打了一个标签,可以通过Label Selector(标签选择器)查询和筛选拥有某些Label的资源对象,K8S通过这种方式实现了类似SQL的对象查询机制

每个资源都存在多维度属性

xxxxxxxxxx版本标签:"release" : "stable" , "release" : "canary"...环境标签:"environment" : "dev" , "environment" : "production"架构标签:"tier" : "frontend" , "tier" : "backend" , "tier" : "middleware"分区标签:"partition" : "customerA" , "partition" : "customerB"...应用场景

- 未使用前,分散难管理,如果需要部署不同版本的应用到不同的环境中,难操作

- 为Pod打上不同标签,使用Label组织的Pod,轻松管理

标签选择器Label selector

是Kubernetes核心的分组机制,通过label selector客户端/用户能够识别一组有共同特征或属性的资源对象

对应的资源打上标签后,可以使用标签选择器过滤指定的标签

标签选择器目前有两个

matchLabels 用于定义一组Label , 基于等值关系(等于、不等于) ,类似于SQL语句中的=或!=

matchExpressions 基于集合关系(属于、不属于、存在) ,类似于SQL语句中的in或 not in

备注

- 如果同时设置了matchLabels和matchExpressions,则两组条件为 AND关系

- 即需要同时满足所有条件才能完成Selector的筛选

操作

xxxxxxxxxx# 通过 deployment控制器导出yaml文件,指定名称空间kubectl create deployment xdclass-nginx --image=nginx:1.23.0 --namespace dev -o yaml --dry-run=client > nginx.yaml#命令默认不会列出任何标签kubectl get pods# 使用 --show-labels 选项来查看kubectl get pod -n dev --show-labels# 查看 deploy控制器标签kubectl get deploy -n dev --show-labels# 查看 pod 标签kubectl get pod -n dev --show-labels# 查看node节点标签kubectl get node --show-labels#给Pod资源打标签kubectl label pod pod名称 -n dev version=1.0例子:kubectl label pod xdclass-nginx-859bdb9994-kglj8 -n dev version=1.0#给Pod资源更新标签kubectl label pod pod名称 -n dev version=2.0 --overwrite例子:kubectl label pod xdclass-nginx-859bdb9994-kglj8 -n dev version=2.0 --overwrite#使用标签选择器kubectl get pod -l "version=2.0" -n dev --show-labelskubectl get pod -l "version!=2.0" -n dev --show-labels#删除标签 语法 kubectl label pod pod名称 -n dev 标签名-kubectl label pod pod名称 -n dev version-例子kubectl label pod xdclass-nginx-859bdb9994-kglj8 -n dev version-

- 配置查看案例

xxxxxxxxxxapiVersion: apps/v1kind: Deploymentmetadata:creationTimestamp: nulllabels:app: xdclass-nginxname: xdclass-nginxnamespace: devspec:replicas: 2selector:matchLabels:app: xdclass-nginxstrategy: {}template:metadata:creationTimestamp: nulllabels:app: xdclass-nginxspec:containers:- image: nginx:1.23.0name: nginxresources: {}status: {}

第5集 Kubernetes的NodeSelector标签选择器实战

简介:Kubernetes的NodeSelector标签选择器实战

nodeSelector

- 是 PodSpec 的一个字段

- 使用NodeSelector,测试 pod 并指定 nodeSelector 选项绑定节点

xxxxxxxxxx# 查看node节点标签kubectl get node --show-labels配置文件

xxxxxxxxxxapiVersion: v1kind: Podmetadata:name: xdclass-nginxspec:containers:- name: nginximage: nginx:1.23.0imagePullPolicy: IfNotPresentnodeSelector:env: test- 使用

xxxxxxxxxx#创建podkubectl apply -f nginx.yaml#查看pod资源kubectl get pod# 当Pod 一直处于 Pending 状态时,说明该 Pod 还未被调度到某个节点上# Pod 中 nodeSelector 指定了节点 Label,调度器将只考虑调度 Pod 到包含该 Label 的 Node 上# 当不存在符合该条件的 Node 时,Pod 将无法被调度#给Node资源打标签,不能给master打标签kubectl label node node名称 env=testkubectl label node izwz90pegu9budx5tk4rv0z env=test#删除 node的标签 kubectl label node 删除指定的labels(标签 key 接 - 号即可)kubectl label node node名称 env-kubectl label node izwz90pegu9budx5tk4rv0z env-

愿景:"让编程不再难学,让技术与生活更加有趣"

愿景:"让编程不再难学,让技术与生活更加有趣"

更多架构课程请访问 xdclass.net

第六章 Kubernetes核心资源之Pod控制器实战

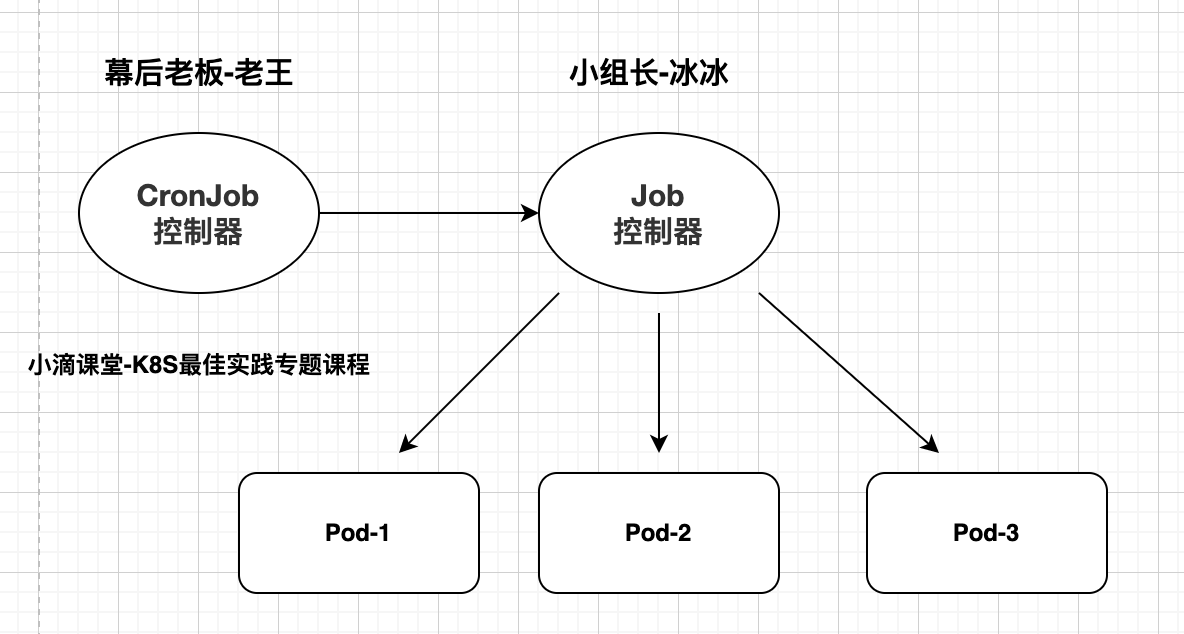

第1集 Kubernetes的Pod的幕后老板控制器讲解

简介:Kubernetes的Pod控制器讲解实战

Pod Controller控制器

- 控制器是管理pod的中间层,只需要告诉Pod控制器,想要创建多少个什么样的Pod,它会创建出满足条件的Pod,相当于一个状态机,用来控制Pod的具体状态和行为。controller会自动创建相应的pod资源,并在当pod发生故障的时候按照策略进行重新编排

- 通过它来实现对pod的管理,比如启动pod、停止pod、扩展pod的数量等等

- 通俗来说就是【幕后老板】

- yaml文件中 kind 填写对应的类型即可

Pod Controller的类型概述

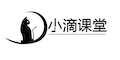

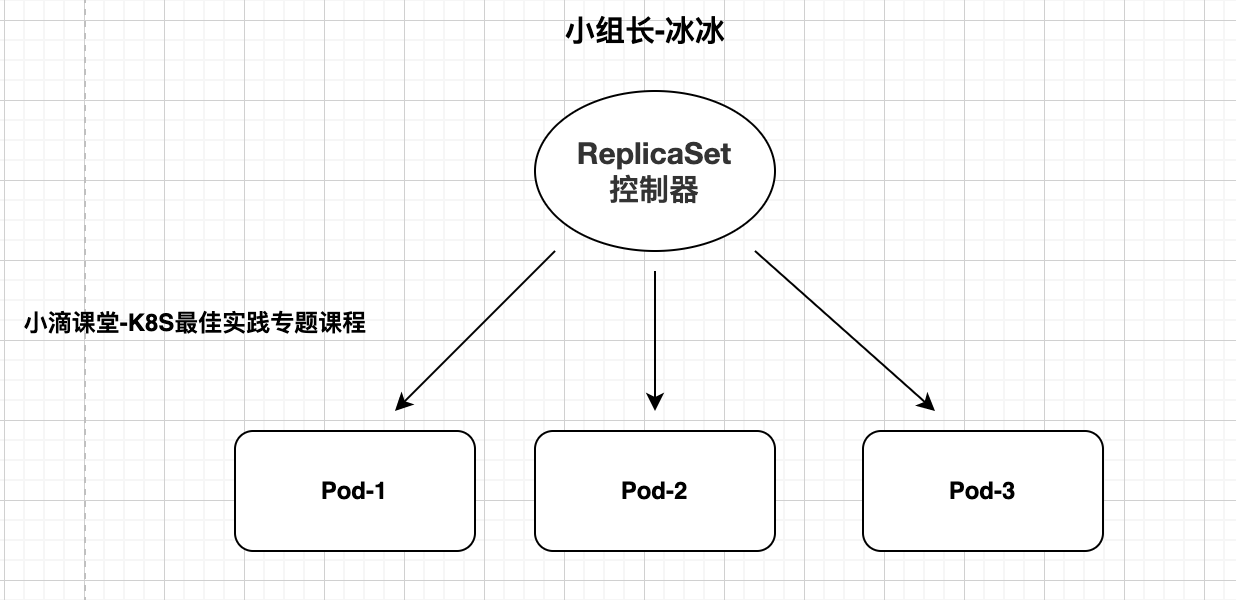

ReplicaSet

- 一种副本控制器,简称

rs,主要是控制由其管理的pod,使pod副本的数量始终维持在预设的个数 - 并支持pod数量扩缩容,镜像版本升级

- 官方建议不要直接使用ReplicaSet,用Deployments更好,并提供很多其它有用的特性

- 一种副本控制器,简称

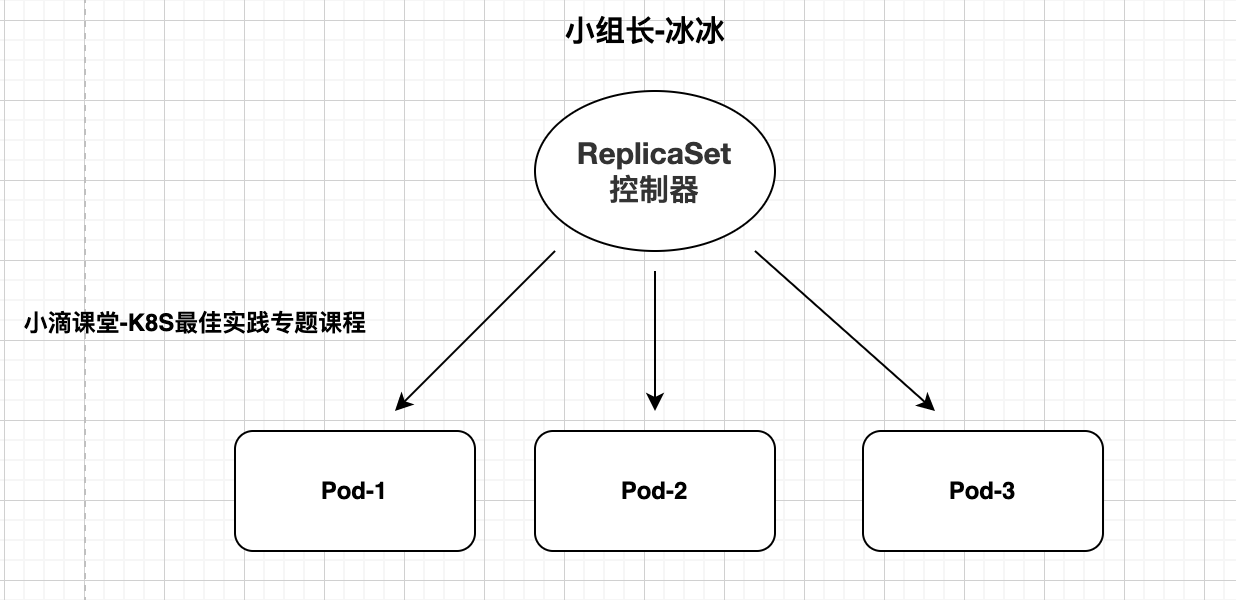

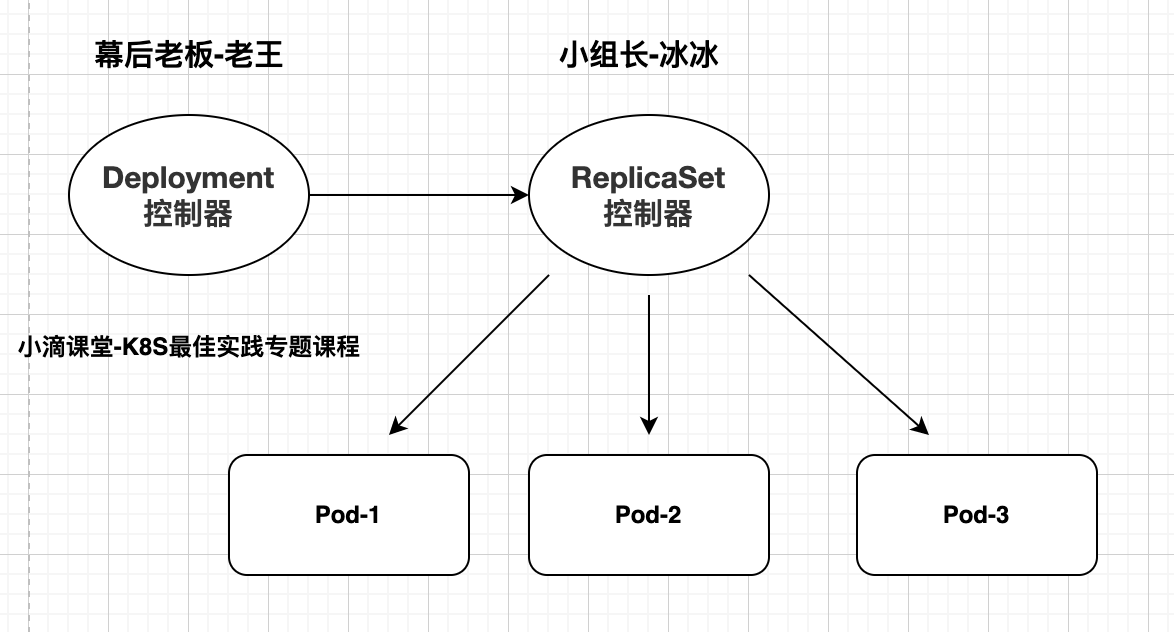

Deployment

- 通过控制ReplicaSet来控制Pod,并支持滚动升级、回退版本,适合无状态的服务部署

- 当某个应用有新版本发布时,Deployment会同时操作两个版本的ReplicaSet

- 其内置多种滚动升级策略,会按照既定策略降低老版本的Pod数量,同时也创建新版本的Pod

- Deployment控制器不直接管理Pod对象,而是 Deployment 管理ReplicaSet, 再由ReplicaSet管理Pod对象

DaemonSet

- 在K8S集群部署中由于节点数量不定,那么如果我们需要对每个节点中都运行一个守护进程、日志收集进程等情况时,在k8s中如何实现呢?这个时候就是DaemonSet应用场景了

- 这类Pod 运行在K8S 集群里的每一个节点(Node)上,确保所有节点上有且仅有一个pod

- 有新的节点加入 K8S集群后,该 Pod 会自动地在新节点上被创建出来

- 而当旧节点被删除后,它上面的 Pod也相应地会被回收掉

- 应用场景:监控告警Agent、日志组件、监控组件等

StatefulSet

- 像RS、Deployment、DaemonSet都是面向无状态的服务,所管理的Pod的IP、名字,启停顺序都是随机

- StatefulSet就是有状态的集合,管理所有有状态的服务,

- StatefulSet 中的 Pod 具有黏性的、独一无二的身份标识,重新调度后PodName和HostName不变

- Pod重新调度后还是能访问到相同的持久化数据,基于PVC实现

- 分配给每个 Pod 的唯一顺序索引,Pod 的名称的形式为

xxxxxxxxxx<statefulset name>-<ordinal index>- 应用场景:比如MySQL、MongoDB集群

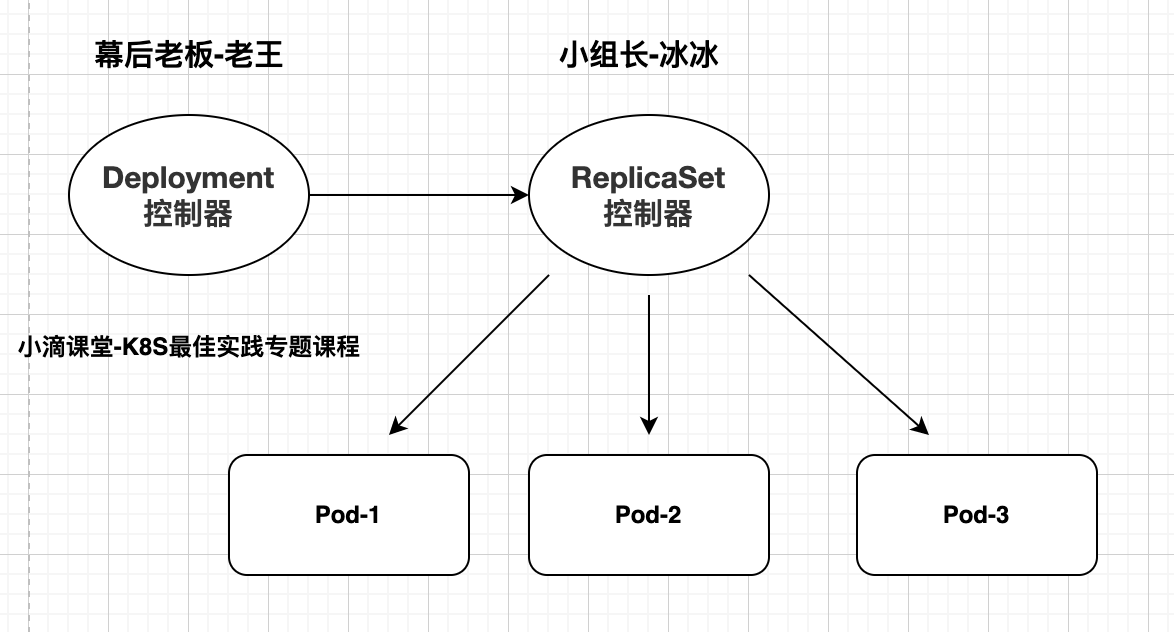

Horizontal Pod Autoscaler

- 可以基于 CPU 利用率或其他指标实现Pod水平自动扩缩

- 被伸缩的pod需要是通过deployment或者replica set管理

- HPA不能应用于不可伸缩的对象,如:DaemonSets

- 由资源来决定控制器行为,控制器周期性调整目标pod的副本数量,让目标pod的实际cpu使用率符合用户指定的数值

Job

- 普通任务容器控制器,只会执行一次,只要完成任务就立即退出,不需要重启或重建

- 容器中的进程在正常运行结束后不会对其进行重启,而是将pod对象置于completed状态

- 若容器中的进程因错误而终止,则需要依据配置确定是否需要重启

- 应用场景:批处理程序,完成后容器就退出等

Cronjob:

- Linux 中有 cron 程序定时执行任务,K8s的 CronJob 提供了类似的功能,可以定时执行 Job

- 创建的Pod负责周期性任务控制

- 应用场景:执行周期性的重复任务,如备份数据、发送邮件、数据报表、报告生成等

- 接下去我们会挑选几个常用的进行讲解

第2集 K8S核心控制器之ReplicaSet和控制器yaml模板介绍

简介:K8S核心控制器之ReplicaSet控制器和控制器模板介绍

备注

- 早期k8s没那么多控制器,使用Replication Controller 来部署、升级Pod,简称RC

- Replica Set – 下一代Replication Controller

ReplicaSet

- 一种副本控制器,简称

rs,主要是控制由其管理的pod,使pod副本的数量始终维持在预设的个数 - 并支持pod数量扩缩容,镜像版本升级

- 官方建议不要直接使用ReplicaSet,用Deployments更好,并提供很多其它有用的特性

- 一种副本控制器,简称

可控制器Yaml模板介绍

xxxxxxxxxxapiVersion: apps/v1 # 版本号kind: ReplicaSet #资源文件metadata: # 元对象信息name: xdclass-rs #rs控制器名称namespace: dev #名称空间spec: #具体详情replicas: 5 #副本数量selector: # 选择器,指定rs控制器管理哪些pod资源matchLabels: # 标签匹配规则app: xdclass-nginx-pod #标签key是app,值是xdclass-nginx-podtemplate: # pod模板,当数量不满足的时候,根据下面编码创建pod副本metadata: # 元对象信息labels: # pod资源标签app: xdclass-nginx-podspec: #具体详情containers: # 容器数组列表- name: xdclass-nginx #容器名称image: nginx:1.23.0 # 镜像和版本

- 案例文件 replicaset-nginx.yaml

xxxxxxxxxxapiVersion: apps/v1kind: ReplicaSetmetadata:name: xdclass-rsnamespace: devspec:replicas: 5selector:matchLabels:app: xdclass-nginx-podtemplate:metadata:labels:app: xdclass-nginx-podspec:containers:- name: xdclass-nginximage: nginx:1.23.0

- 执行

xxxxxxxxxx#创建kubectl apply -f replicaset-nginx.yaml

- 其他操作

xxxxxxxxxx#查看kubectl get pods,deploy,replicaset -o wide -n dev# 命令行缩容kubectl scale rs xdclass-rs --replicas=2 -n dev# 删除,可以直接删除rs;也可以通过yaml删除kubectl delete -f replicaset-nginx.yaml

第3集 K8S核心控制器之Deployment控制器实战

简介:K8S核心控制器之Deployment控制器实战

Deployment

- 通过控制ReplicaSet来控制Pod,并支持滚动升级、回退版本,适合无状态的服务部署

- 当某个应用有新版本发佈时,Deployment会同时操作两个版本的ReplicaSet

- 其内置多种滚动升级策略,会按照既定策略降低老版本的Pod数量,同时也创建新版本的Pod

- Deployment控制器不直接管理Pod对象,而是 Deployment 管理ReplicaSet, 再由ReplicaSet管理Pod对象

- 总结:Deployment、ReplicaSet、Pod三者之间是一种阶梯控制的关系

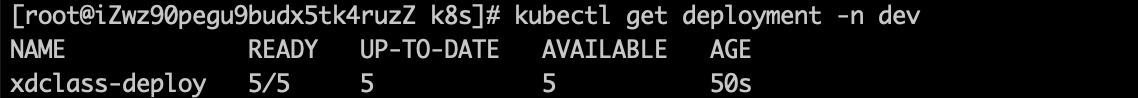

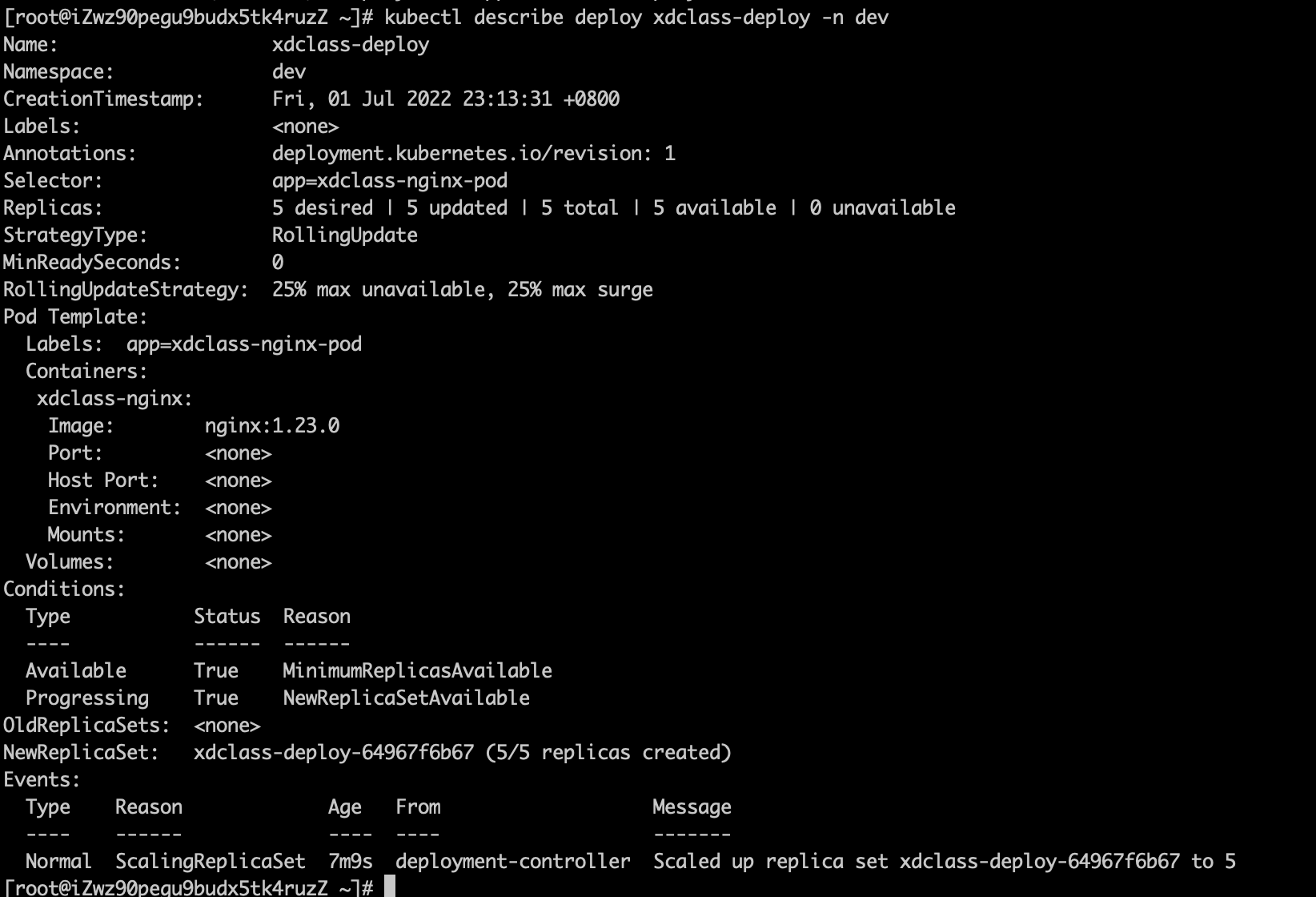

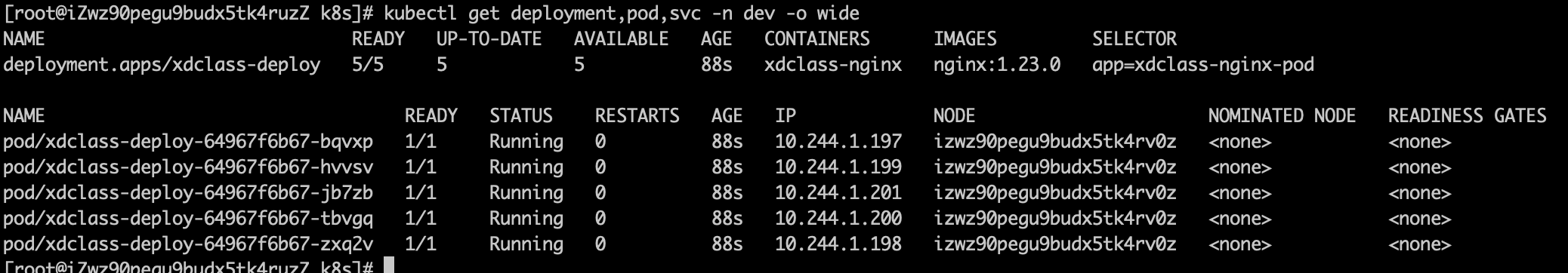

配置文件 deploy-nginx-pod.yaml

xxxxxxxxxxapiVersion: apps/v1kind: Deploymentmetadata:name: xdclass-deploynamespace: devspec:replicas: 5selector:matchLabels:app: xdclass-nginx-podtemplate:metadata:labels:app: xdclass-nginx-podspec:containers:- name: xdclass-nginximage: nginx:1.23.0

- 执行

xxxxxxxxxx#创建kubectl apply -f deploy-nginx-pod.yaml# 查看deploymentkubectl get deployment -n dev#查看kubectl get pods,deploy,replicaset -o wide -n dev# 删除,通过yaml删除kubectl delete -f deploy-nginx-pod.yaml

检查集群中的 Deployment 时,所显示的字段有:

NAME列出了集群中 Deployment 的名称。READY显示应用程序的可用的“副本”数,格式是“就绪个数/期望个数”。UP-TO-DATE显示为了达到期望状态已经更新的副本数。AVAILABLE显示可用的副本数。AGE应用程序运行的时间。

第4集 Deployment控制器rollout实现滚动升级

简介:Deployment控制器rollout实现滚动升级

Deployment控制器核心

- 适合部署无状态的应用服务

- 用来管理pod和replicaset

- 上线部署、副本控制、滚动更新、回滚等功能

K8S的Deployment控制器滚动升级 (金丝雀发布 or 灰度发布)

对各个实例批次进行单独更新,而非同一时刻对所有实例进行全部更新,达到不中断服务的更新升级方式

Deployment控制器 给旧版本(old_rs)副本数减少至0、给新版本(new_rs)副本数量增至期望值(replicas)

Deployment更新有两种方式

xxxxxxxxxxspec:strategy: # 策略type: RollingUpdateRecreate : 删除全部旧的pod,然后创建新的pod

RollingUpdate:滚动升级更新,删除部分,更新部分,在整个更新过程中,存在两个版本的pod

- maxUnavailable

xxxxxxxxxx升级过程中不可用Pod的最大数量,默认为25%在滚动更新时,我们可以忍受多少个 Pod 无法提供服务值越小越能保证服务稳定,更新越平滑- maxSurge

xxxxxxxxxx升级过程中可以超过期望的Pod的最大数量,默认为25%;在滚动更新时,可以有多少个额外的 Pod值调的越大,副本更新速度越快例子 deploy-rollout.yaml

xxxxxxxxxxMaxUnavailable为0, 在新 Pod 启动并就绪之前,不要关闭任何旧PodMaxSurge 为100%, 立即启动所有新 Pod,也就是有足够的资源希望尽快完成更新。默认两个值都是 25%如果更新一个 100 Pod 的 Deployment,会立刻创建 25 个新 Old,同时会关闭 25 个旧 Pod;每次有 Pod 启动就绪,就可以关闭旧 PodxxxxxxxxxxapiVersion: apps/v1kind: Deploymentmetadata:name: xdclass-deploynamespace: devspec:replicas: 5revisionHistoryLimit: 5 #保留历史版本5个strategy:type: RollingUpdateselector:matchLabels:app: xdclass-nginx-podtemplate:metadata:labels:app: xdclass-nginx-podspec:containers:- name: xdclass-nginximage: nginx:1.23.0

查看控制器参数

- 可以使用describe查看

xxxxxxxxxxkubectl describe deploy xdclass-deploy -n dev

滚动升级

- 将nginx版本更新至1.15.8

xxxxxxxxxxkubectl set image deployment/xdclass-deploy xdclass-nginx=nginx:1.15.8 -n dev备注追加 --record 以保存正在更改资源的 kubectl 命令,方便查看history版本列表修改命令kubectl set image deployment/xdclass-deploy xdclass-nginx=nginx:1.15.8 -n dev --record=truekubectl set image deployment/xdclass-deploy xdclass-nginx=nginx:1.23.0 -n dev --record=true- 动态查看升级过程,存在多个不同版本

xxxxxxxxxxkubectl get pods -n dev -w发布回滚

kubectl rollout 版本升级相关介绍

- history 升级历史记录

- undo 默认回滚上一版本 ,使用--to-revision回滚到指定版本

- pause 暂停版本升级发布

- resume 继续恢复刚暂停的版本升级

- status 升级状态

查看历史版本列表

xxxxxxxxxxkubectl rollout history deployment/xdclass-deploy -n dev- 查看具体某一个历史版本信息

xxxxxxxxxxkubectl rollout history deployment/xdclass-deploy -n dev --revision=2- 回滚上一版本

xxxxxxxxxxkubectl rollout undo deployment/xdclass-deploy -n dev- 查看升级情况

xxxxxxxxxxkubectl rollout status deployment/xdclass-deploy -n dev- 回滚指定版本

xxxxxxxxxxkubectl rollout undo deployment/xdclass-deploy -n dev --to-revision=2

删除deployment

xxxxxxxxxxkubectl delete -f deploy-nginx-pod.yaml

第5集 K8S核心控制器之DaemonSet控制器实战

简介:K8S核心控制器之DaemonSet控制器实战

DaemonSet(节点级别的pod)

- 在K8S集群部署中由于节点数量不定,那么如果我们需要对每个节点中都运行一个守护进程、日志收集进程等情况时,在k8s中如何实现呢?这个时候就是DaemonSet应用场景了

- 这类Pod 运行在K8S 集群里的每一个节点(Node)上,确保所有节点上有且仅有一个pod

- 有新的节点加入 K8S集群后,该 Pod 会自动地在新节点上被创建出来

- 而当旧节点被删除后,它上面的 Pod也相应地会被回收掉

- 应用场景:监控告警Agent、日志组件、监控组件等

案例 daemonset-nginx.yaml

xxxxxxxxxxapiVersion: apps/v1kind: DaemonSetmetadata:name: xdclass-dsnamespace: devspec:selector:matchLabels:app: xdclass-nginx-podtemplate:metadata:labels:app: xdclass-nginx-podspec:containers:- name: xdclass-nginximage: nginx:1.23.0imagePullPolicy: IfNotPresent命令验证

xxxxxxxxxx#创建kubectl apply -f daemonset-nginx.yaml#只有一个节点,多个节点的话,每个节点都有一个podkubectl get pod,deploy,rs,ds -n dev

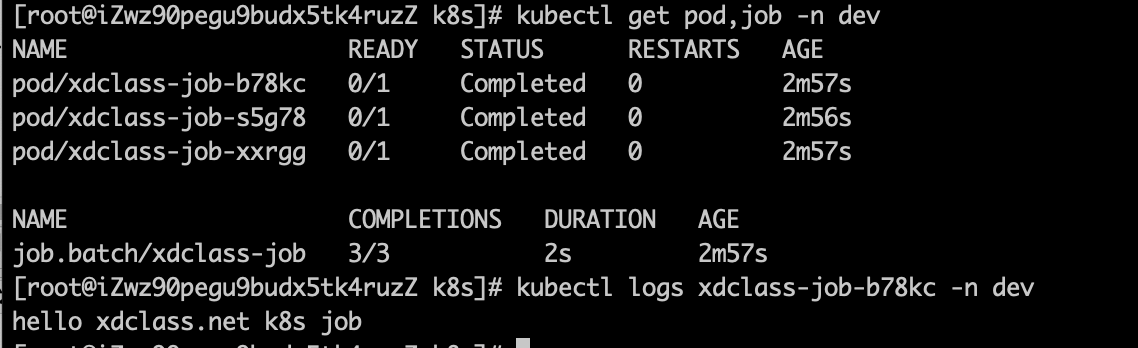

第6集 K8S核心控制器之Job控制器实战

简介:K8S核心控制器之Job控制器实战

Job控制器

- 普通任务容器控制器,只会执行一次,只要完成任务就立即退出,不需要重启或重建

- 容器中的进程在正常运行结束后不会对其进行重启,而是将pod对象置于completed状态

- 若容器中的进程因错误而终止,则需要依据配置确定是否需要重启

- 应用场景:批处理程序,完成后容器就退出等

- 启动pod在运行完毕任务后,就会变成Completed状态,job的状态会更新为complete,这个job任务已经执行完成,pod不在系统中继续运行

参数讲解

xxxxxxxxxxapiVersion: batch/v1kind: Jobmetadata:name: xdclass-jobnamespace: devspec:parallelism: 2 #job并发运行Pods的数量,默认 1completions: 3 #job需要成功运行Pods的次数,默认 1backoffLimit: 5 #job失败后进行重试的次数,默认是6activeDeadlineSeconds: 100 #job运行超时时间,当job超过timeout时间,则job的状态也会更新为failedtemplate:spec:restartPolicy: Never #job重启策略,OnFailure或Nevercontainers:- name: demoimage: busybox:1.35.0# 容器的启动命令列表,在pod中的容器初始化完毕后运行命令command: ["echo","hello xdclass.net k8s job"]BusyBox

- 是一个集成了三百多个最常用Linux命令和工具的软件

- 包含了简单的工具,例如ls、cat和echo等等,还包含了一些更复杂的工具,例grep、find、telnet

案例实战

xxxxxxxxxxapiVersion: batch/v1kind: Jobmetadata:name: xdclass-jobspec:parallelism: 2completions: 3backoffLimit: 5activeDeadlineSeconds: 100template:spec:restartPolicy: Nevercontainers:- name: demoimage: busybox:1.35.0command: ["echo","hello xdclass.net k8s job"]- 查看

xxxxxxxxxxkubectl get job -n dev -o widekubectl get pods -o wide#查看日志kubectl logs xdclass-job-75xfb

愿景:"让编程不再难学,让技术与生活更加有趣"

愿景:"让编程不再难学,让技术与生活更加有趣"

更多架构课程请访问 xdclass.net

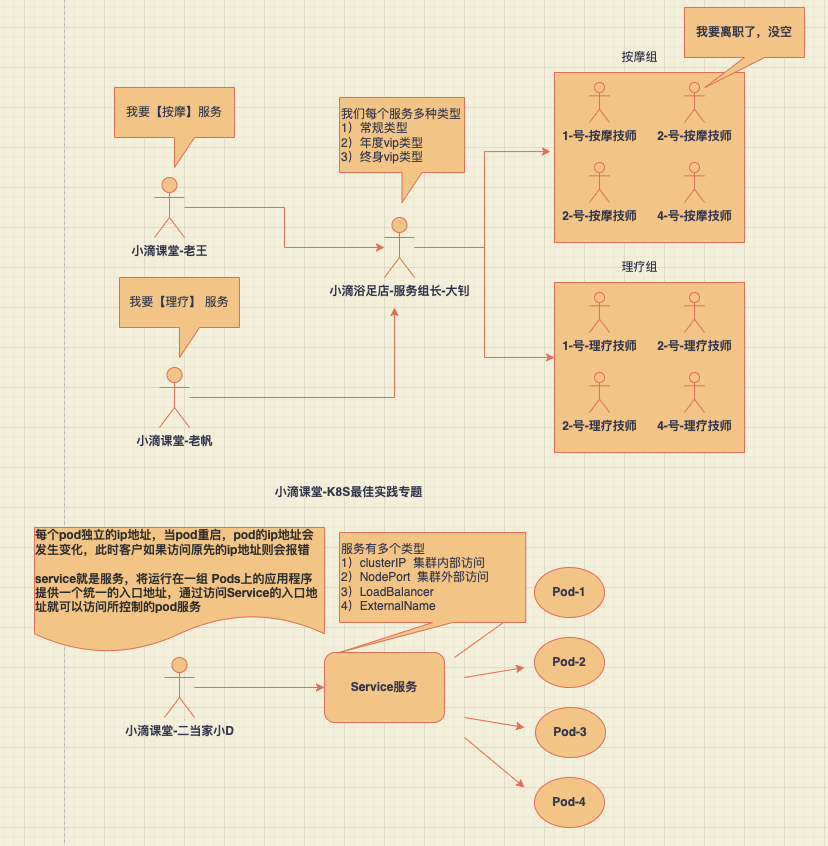

第七章 Kubernetes核心资源之Service服务实战

第1集 带你走近K8S沐足店的Service服务

简介:带你走近K8S沐足店的服务Service

- 什么是服务service?

Service

- 在k8s里面,每个Pod都会被分配一个单独的IP地址,但这个IP地址会随着Pod的销毁而消失,重启pod的ip地址会发生变化,此时客户如果访问原先的ip地址则会报错

Service (服务)就是用来解决这个问题的, 对外服务的统一入口,防止pod失联,定义一组pod的访问策略(服务发现、负载均衡)

一个Service可以看作一组提供相同服务的Pod的对外访问接口,作用于哪些Pod是通过标签选择器来定义的

- Service是一个概念,主要作用的是节点上的kube-proxy服务进程

例子

- 定义了3个商品微服务,由网关作为统一访问入口, 前端不需要关心它们调用了哪个后端副本。 然而组成这一组后端程序的 Pod 实际上可能会发生变化, 前端客户端不应该也没必要知道,而且也不需要跟踪这一组后端的状态。

- Service 定义的抽象能够解耦这种关联。

service分类

ClusterIP

- 默认类型,自动分配一个【仅集群内部】可以访问的虚拟IP

NodePort

- 对外访问应用使用,在ClusterIP基础上为Service在每台机器上绑定一个端口,就可以通过: ip+NodePort来访问该服务

LoadBalancer(花钱的方案)

- 使在NodePort的基础上,借助公有云创建一个外部负载均衡器,并将请求转发到NodePort

- 可以实现集群外部访问服务的另外一种解决方案,不过并不是所有的k8s集群都会支持,大多是在公有云托管集群中会支持该类型

ExternalName(很少)

- 把集群外部的服务引入到集群内部来,在集群内部直接使用。没有任何类型代理被创建,这只有 Kubernetes 1.7或更高版本的kube-dns才支持。

service和pod的关系

- service和pod之间是通过 selector.app进行关联的

xxxxxxxxxxspec: # 描述selector: # 标签选择器,确定当前service代理控制哪些podapp: xdclass-nginxyaml模板文件

xxxxxxxxxxapiVersion: v1kind: Servicemetadata:creationTimestamp: nullname: xdclass-svcspec:ports:- port: 80 # service服务端口protocol: TCPtargetPort: 80 # pod端口,常规和容器内部端口一致selector:app: xdclass-nginx-podstatus:loadBalancer: {}

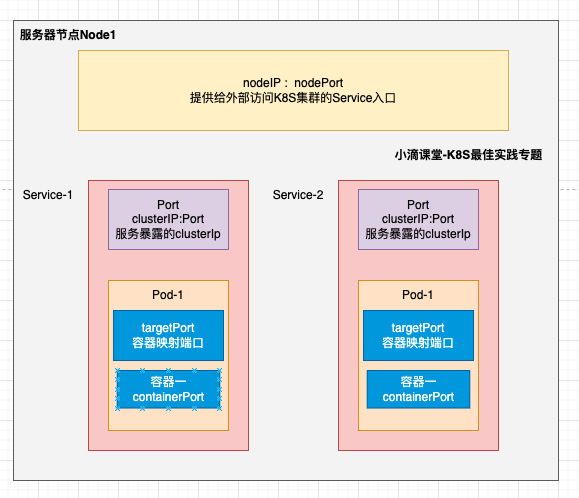

第2集 K8S里面的多种port端口你知道怎么区分不

简介:K8S里面的port-targetPort -nodePort-containerPort 你知道怎么区分不

关于K8S中端口的概念区分

port

- 是service端口,即k8s中服务之间的访问端口 ,clusterIP:port 是提供给集群内部客户访问service的入口

nodePort

- 容器所在node节点的端口,通过nodeport类型的service暴露给集群节点,外部可以访问的端口

targetPort

- 是pod的端口 ,从port和nodePort来的流量经过kube-proxy流入到后端pod的targetPort上,最后进入容器。

containerPort

- 是pod内部容器的端口,targetPort映射到containerPort。

总结

- 4种端口作用不一样,port和nodePort都是service的端口

- port暴露给集群内客户访问服务,nodePort暴露给集群外客户访问服务

- 这两个端口到来的数据都需要经过反向代理kube-proxy流入后端pod的targetPod,从而到达pod中的容器

xxxxxxxxxxapiVersion: v1kind: Podmetadata:name: nginxnamespace: devlabels:app: nginxspec:containers:- name: nginximage: nginx:1.20imagePullPolicy: IfNotPresentports:- containerPort: 80 #容器端口---apiVersion: apps/v1kind: Servicemetadata:name: nginxspec:type: NodePort # 有配置NodePort,外部可访问k8s中的服务 ,ports:- name: nginxport: 80 # 服务service的访问端口protocol: TCPtargetPort: 80 # pod端口,映射到容器端口nodePort: 30015 # NodePort,通过nodeport类型的service暴露给集群外部访问selector:app: nginx

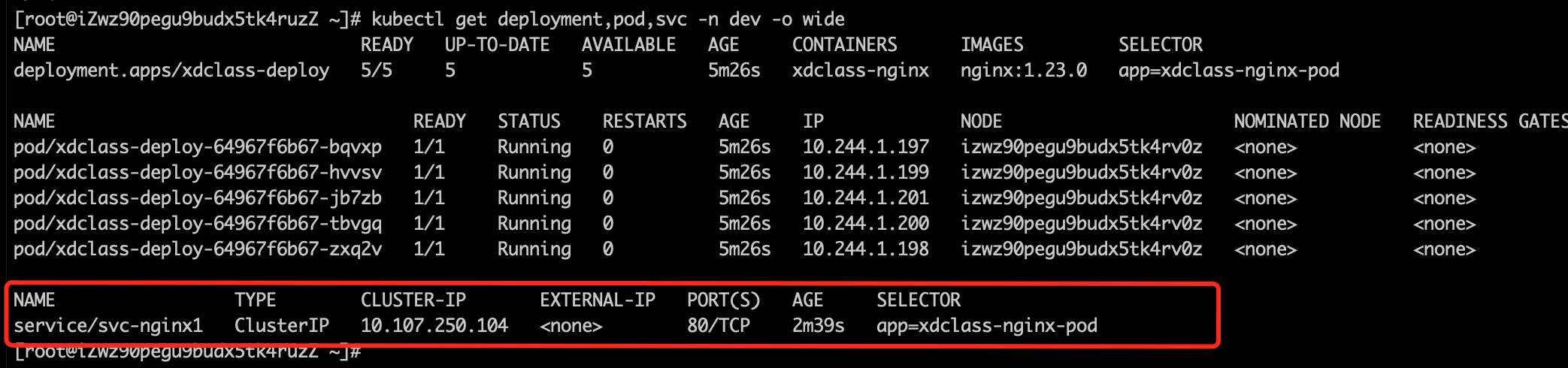

第3集 K8S服务Service的ClusterIP实战

简介:K8S服务Service的ClusterIP实战

- 创建deployment

xxxxxxxxxxkubectl apply -f deploy-nginx-pod.yaml

- 查看deployment和pod(service的缩写是svc)

xxxxxxxxxxkubectl get deployment,pod,svc -n dev -o wide

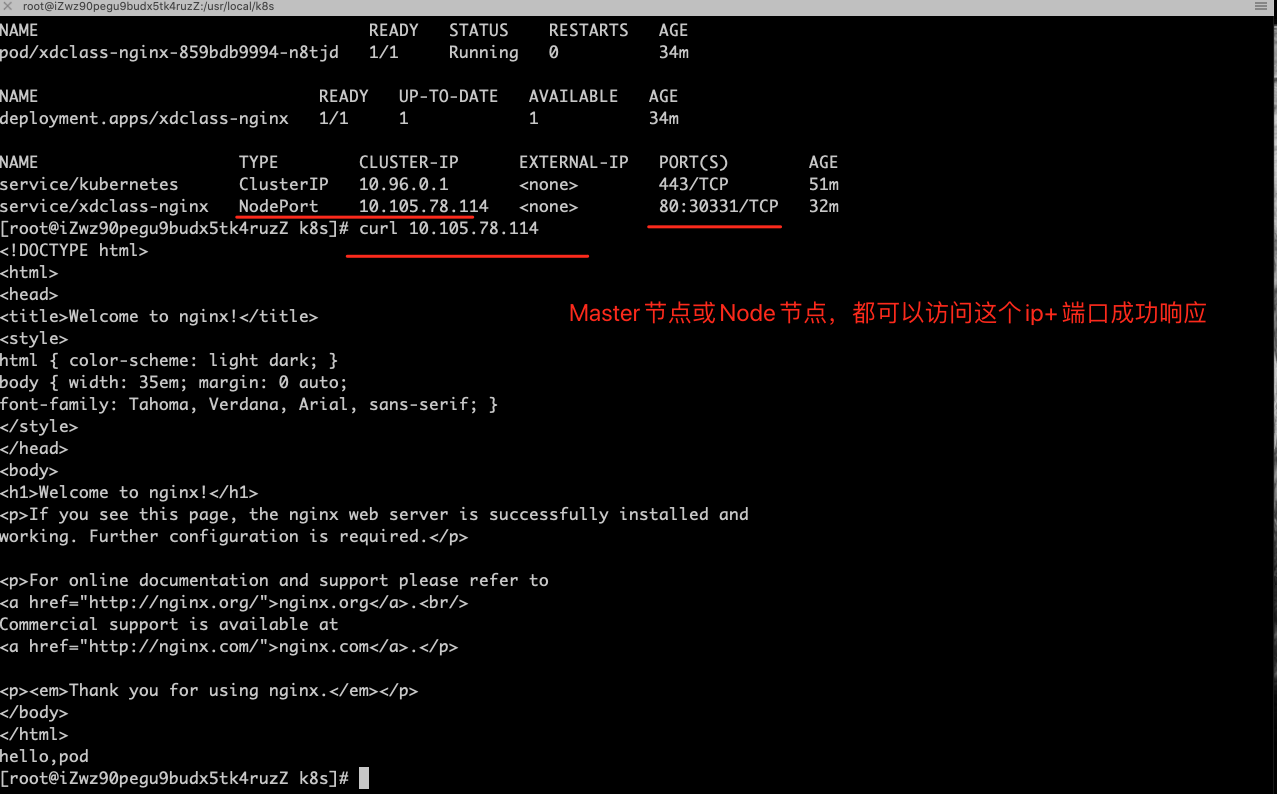

- 暴露服务 clusterIP 类型

xxxxxxxxxxkubectl expose deploy xdclass-deploy --name=svc-nginx1 --type=ClusterIP --port=80 --target-port=80 -n dev

- 查看服务(多了个类型是ClusterIP的,通过curl clusterIp+port可以访问)

xxxxxxxxxxkubectl get deployment,pod,svc -n dev -o wide

- 查看服务详情

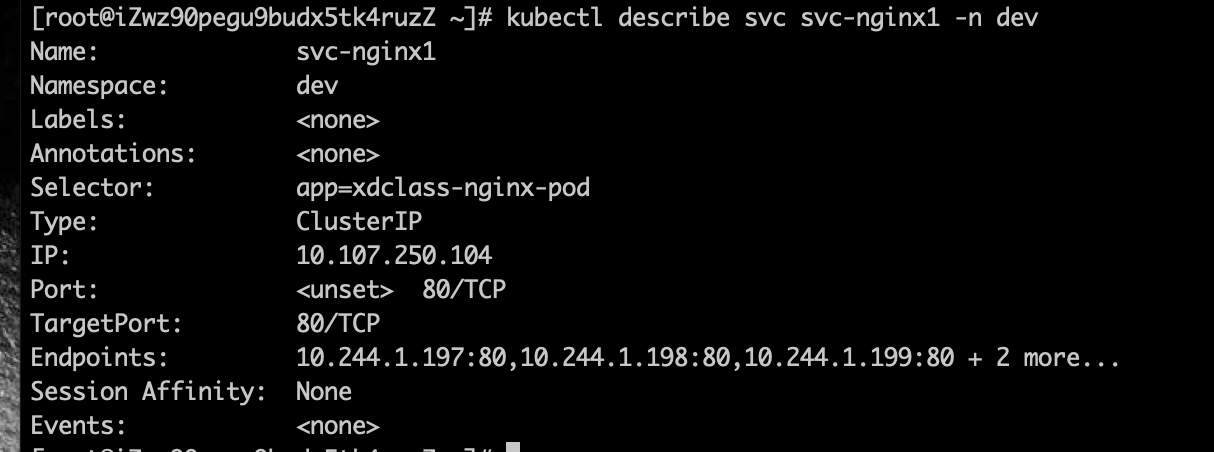

xxxxxxxxxxkubectl describe svc svc-nginx1 -n dev

第4集 K8S服务Service的NodePort和EndPoint实战

简介:K8S服务Service的NodePort和EndPoint实战

NodePort

- 常规业务的场景不全是集群内访问,也需要集群外业务访问

- 那么ClusterIP就满足不了了,NodePort是其中的一种实现集群外部访问的方案

- 对外访问应用使用,在ClusterIP基础上为Service在每台机器上绑定一个端口,就可以通过: ip+NodePort来访问该服务

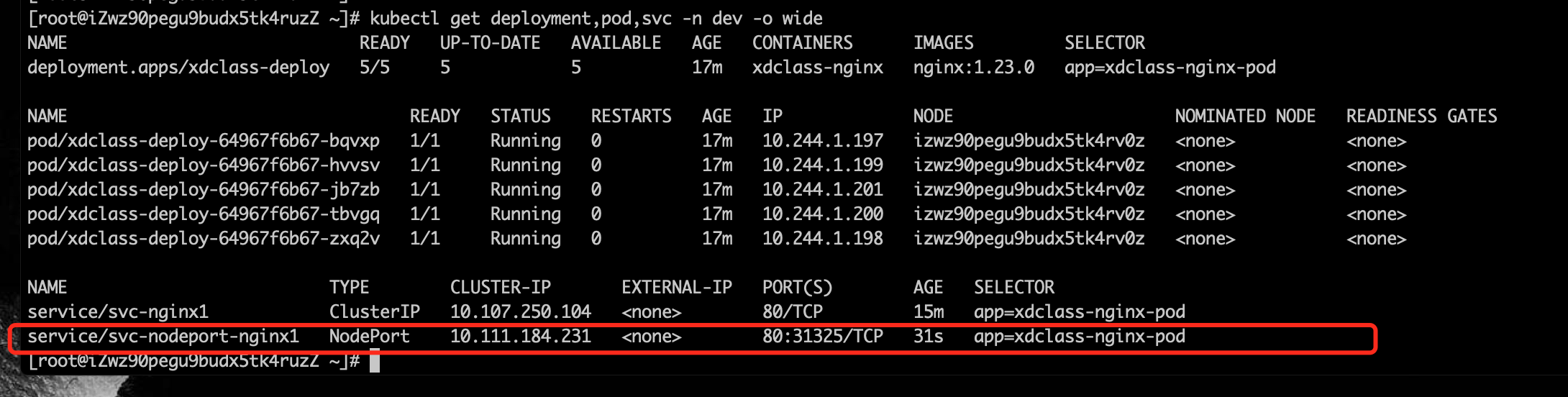

- 创建NodePort类型服务

xxxxxxxxxxkubectl expose deploy xdclass-deploy --name=svc-nodeport-nginx1 --type=NodePort --port=80 --target-port=80 -n dev

- 查看服务(多了个类型是NodePort的,通过curl clusterIp+port可以访问)

在浏览器访问, 工作节点开放端口31325,访问工作节点ip:31325(网络安全组记得开放31325端口)

master、node节点访问这个 开放的端口都可以

Kubeadm部署,暴露端口对外服务,会随机选端口,默认范围是30000~32767,可以修改指定范围

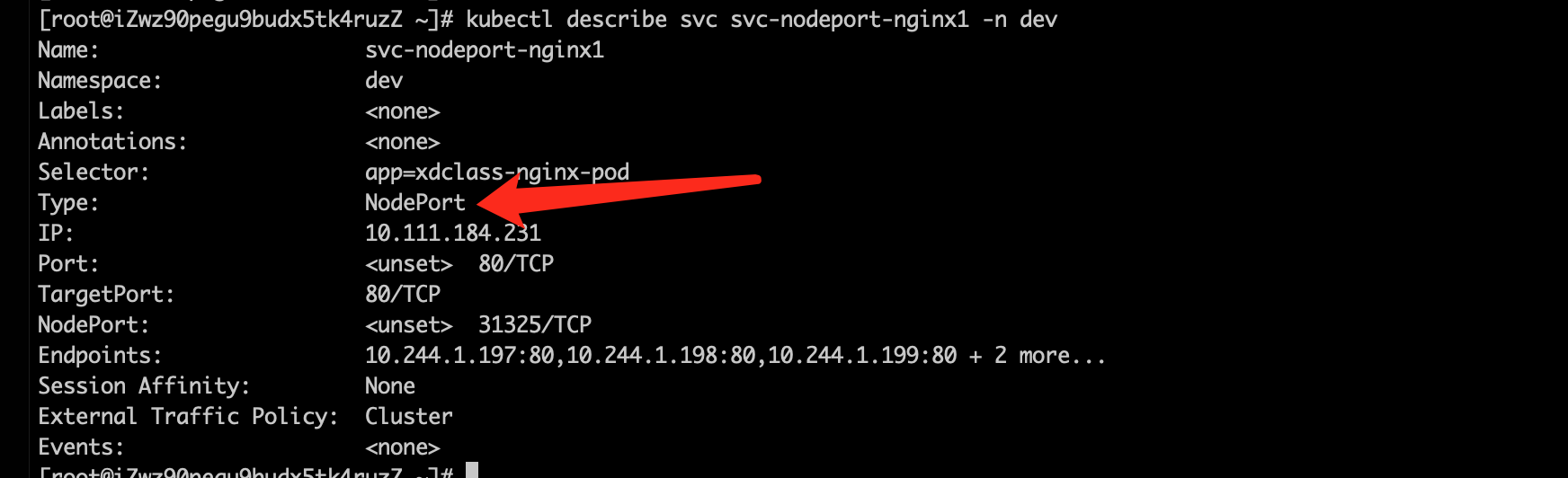

- 查看服务详情

xxxxxxxxxxkubectl describe svc svc-nodeport-nginx1 -n dev

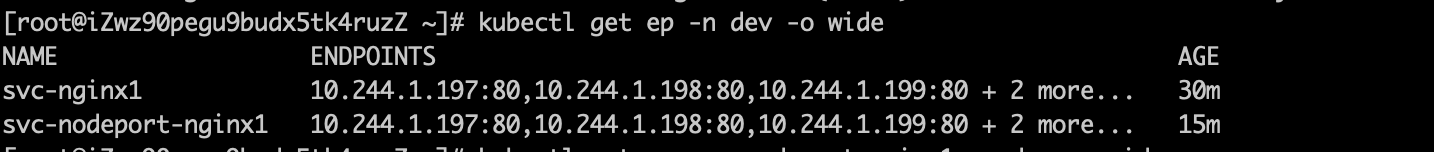

Endpoint(缩写是ep)

- 是k8s中的一个资源对象,存储在etcd中,记录service对应的所有pod的访问地址

- 里面有个Endpoints列表,就是当前service可以负载到的pod服务入口

- service和pod之间的通信是通过endpoint实现的

- 查看endpoint列表

xxxxxxxxxxkubectl get ep svc-nodeport-nginx1 -n dev -o wide

大家的疑惑点,service如何决定分发请求到后端的Pod?

kubernetes提供了两种负载均衡策略

- 默认,kube-proxy的策略,如随机、轮询

- 使用会话保持模式,即同个客户端的请求固定到某个pod,在spec中添加sessionAffinity:ClientIP即可

验证

xxxxxxxxxx#查看全部pod和ipkubectl get pods -n dev -o wide#修改pod里面容器nginx的默认静态页面,内容为Pod所在的ipkubectl exec -it xdclass-deploy-64967f6b67-p66wh -n dev /bin/shecho "xdclass.net 5" > /usr/share/nginx/html/index.html# curl访问ip+port 或 浏览器直接访问

愿景:"让编程不再难学,让技术与生活更加有趣"

愿景:"让编程不再难学,让技术与生活更加有趣"

更多架构课程请访问 xdclass.net

第八章 Kubernetes核心资源之数据存储持久化

第1集 K8S数据存储Volume讲解和EmptyDir实战

简介: K8S数据存储Volume讲解和EmptyDir实战

需求

容器的生命周期可能很短,会被频繁地创建和销毁,容器 中的文件在磁盘上是临时存放的,这给容器中运行的较重要的应用程序带来一些问题

- 问题一 :当容器崩溃时文件丢失,kubelet 会重新启动容器,但容器会以干净的状态重启,之前保存在容器中的数据也会被清除

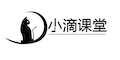

- 问题二:当在一个 Pod 中同时运行多个容器时,常常需要在这些容器之间共享文件

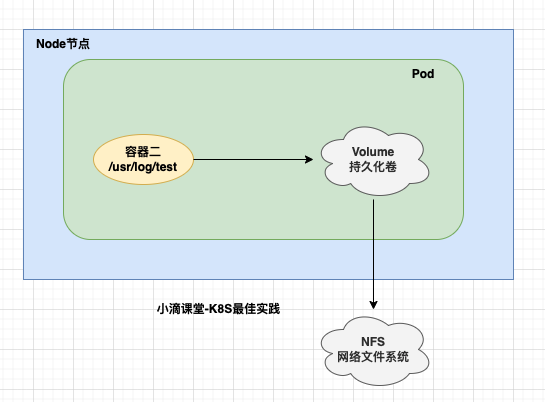

Kubernetes 卷(Volume) 这一抽象概念能够解决这两个问题,卷的核心是包含一些数据的目录,Pod 中的容器可以访问该目录

总结:

- Volume是k8s抽象出来的对象,它被定义在Pod上,然后被一个Pod里的多个容器挂载到具体的文件目录下

- kubernetes通过Volume实现同一个Pod中不同容器之间的数据共享以及数据的持久化存储

- Volume的生命周期不与Pod中单个容器的生命周期相关,当容器终止或者重启时,Volume中的数据也不会丢失。

- K8S可以支持许多类型的卷,Pod 也能同时使用任意数量的卷。

Volume常见的类型:

- 常规存储:EmptyDir、HostPath

- 高级存储:PV、PVC

- 配置存储:ConfigMap、Secret

- 其他:网络存储系统 NFS、CIFS,包括云服务商提供的、本地、分布式

EmptyDir

当 Pod 指定到某个节点上时,首先创建的是一个

emptyDir卷,只要 Pod 在该节点上运行卷就一直存在当 Pod 因为某些原因被从节点上删除时,

emptyDir卷中的数据也会永久删除容器崩溃并不会导致 Pod 被从节点上移除,所以容器崩溃时

emptyDir卷中的数据是安全的。用途

- 临时缓存空间

案例 volume-emptydir.yaml , pod里面定义两个容器,一个产生日志,一个是读日志输出到控制台

xxxxxxxxxxapiVersion: v1kind: Podmetadata:name: xdclass-volume-emptydirnamespace: devspec:containers:- name: xdclass-nginximage: nginx:1.20ports:- containerPort: 80volumeMounts: # 将nginx-log-volume挂在到nginx容器中,对应的目录为 /var/log/nginx- name: nginx-log-volumemountPath: /var/log/nginx- name: xdclass-busyboximage: busybox:1.35.0command: ["/bin/sh","-c","tail -f /usr/local/test/access.log"] # 容器启动后初始命令,读取指定文件中内容volumeMounts: # 将nginx-log-volume挂在到busybox容器中,对应的目录为 /logs- name: nginx-log-volumemountPath: /usr/local/testvolumes: # 这里声明volume存储劵, name为nginx-log-volume,类型是emptyDir- name: nginx-log-volumeemptyDir: {}- 操作

xxxxxxxxxx#创建kubectl apply -f volume-emptydir.yaml#查看kubectl get pods -n dev -o wide#访问nignx 产生访问日志curl ip#查看容器输出 -f 后是 pod的名称kubectl logs -f xdclass-volume-emptydir -n dev -c xdclass-busybox- 删除

xxxxxxxxxxkubectl delete -f volume-emptydir.yaml

第2集 K8S数据存储Volume之hostPath实战

简介: K8S数据存储Volume之hostPath实战

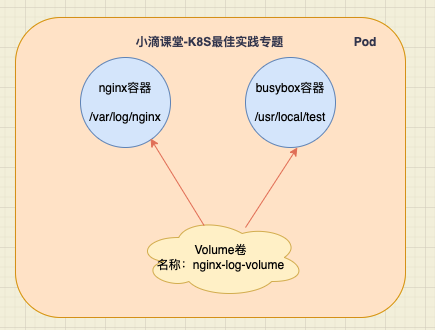

HostPath

emptyDir中数据没做持久化,随着Pod的结束而销毁,需要持久化到磁盘则选其他方式

hostPath类型的磁盘就是挂在了主机的一个文件或者目录

案例

- 某些应用需要用到docker的内部文件,这时只需要挂在本机的/var/lib/docker作为hostPath

HostPath有多种类型,列举常见几个

- Directory 给定的目录路径必须存在

- DirectoryOrCreate 如果给定路径不存在,将根据需要在那里创建一个空目录

- File 给定路径上必须存在对应文件

- FileOrCreate 如果给定路径不存在,将根据需要在那里创建一个空文件

案例 volume-hostpath.yaml

xxxxxxxxxxapiVersion: v1kind: Podmetadata:name: xdclass-volume-hostpathnamespace: devspec:containers:- name: xdclass-nginximage: nginx:1.20ports:- containerPort: 80volumeMounts: # 将nginx-log-volume挂在到nginx容器中,对应的目录为 /var/log/nginx- name: nginx-log-volumemountPath: /var/log/nginx- name: xdclass-busyboximage: busybox:1.35.0command: ["/bin/sh","-c","tail -f /usr/local/test/access.log"] # 容器启动后初始命令,读取指定文件中内容volumeMounts: # 将nginx-log-volume挂在到busybox容器中,对应的目录为 /logs- name: nginx-log-volumemountPath: /usr/local/testvolumes: # 这里声明volume存储劵, name为nginx-log-volume,类型是hostPath- name: nginx-log-volumehostPath:path: /usr/local/testtype: DirectoryOrCreate #如果给定路径不存在,将根据需要在那里创建一个空目录

- 操作

xxxxxxxxxx#创建kubectl apply -f volume-hostpath.yaml#查看kubectl get pods -n dev -o wide#访问nignx 产生访问日志curl ip#查看容器输出 -f 后是 pod的名称kubectl logs -f xdclass-volume-hostpath -n dev -c xdclass-busybox#去节点对应的目录查看文件是否有,即pod运行的节点,主节点上是没的!!!!ls /usr/local/test

- 删除

xxxxxxxxxxkubectl delete -f volume-hostpath.yaml

emptyDir和hostPath对比

- 都是本地存储卷方式

- emptyDir是临时存储空间,完全不提供持久化支持;

- hostPath的卷数据是持久化在node节点的文件系统中的,即便pod已经被删除了,volume卷中的数据还留存在node节点上;

第3集 K8S数据存储ConfigMap实战

简介: K8S数据存储ConfigMap实战

需求

- 很多应用在其初始化或运行期间要依赖一些配置信息

- 大多数时候, 存在要调整配置参数所设置的数值的需求。

- ConfigMap 是 Kubernetes 用来向应用 Pod 中注入配置数据的方法

ConfigMap介绍(缩写cm)

- 是K8S的一种API对象,用来把【非加密数据】保存到键值对中,比如etcd

- 可以用作环境变量、命令行参数等,将环境变量、配置信息和容器镜像解耦,便于应用配置的修改

使用方式

- kubectl create configmap 命令,基于目录、 文件或者键值对来创建 ConfigMap

xxxxxxxxxx格式如下kubectl create configmap NAME --from-literal=key1=value1 --from-literal=key2=value2实操

- 方式一:使用命令行创建

xxxxxxxxxxkubectl create configmap xdclass-config --from-literal=account=xdclass --from-literal=password=123456#查看[root@iZwz90pegu9budx5tk4ruzZ ~]# kubectl get cm xdclass-config -o yamlapiVersion: v1data:account: xdclasspassword: passwordkind: ConfigMapmetadata:creationTimestamp: "2022-07-04T06:36:18Z"name: xdclass-confignamespace: defaultresourceVersion: "1716676"selfLink: /api/v1/namespaces/default/configmaps/xdclass-configuid: 6ae2890e-fad3-452c-9179-78dd63ddbbba- 方式二:使用文件创建configmap.yaml

xxxxxxxxxxapiVersion: v1kind: ConfigMapmetadata:name: xdclass-configmapnamespace: devdata:info:username:xdclasspassword:123456- 命令

xxxxxxxxxx#创建kubectl create -f configmap.yaml# 查看configmap详情kubectl describe cm xdclass-configmap -n dev- 创建pod的yaml,pod-configmap.yaml,然后吧将创建的configmap挂载进去

xxxxxxxxxxapiVersion: v1kind: Podmetadata:name: pod-configmapnamespace: devspec:containers:- name: nginximage: nginx:1.20volumeMounts: # configmap挂载的目录- name: configmountPath: /configvolumes: # 声明configmap- name: configconfigMap:name: xdclass-configmap- 命令

xxxxxxxxxx#创建podkubectl create -f pod-configmap.yaml#查看kubectl get pod pod-configmap -n dev#进入容器kubectl exec -it pod-configmap -n dev -- /bin/sh# cd /config# cat infousername:xdclasspassword:123456

第4集 K8S数据存储之Secret实战

简介: K8S数据存储之Secret实战

需求

- 有些配置需要加密存储,ConfigMap只能使用明文保存,因此不适合

Secret

用来保存敏感信息,例如密码、秘钥、证书、OAuth 令牌和 ssh key等

就不需要把这些敏感数据暴露到镜像或者Pod中

Pod 可以用三种方式之一来使用 Secret:

- 作为挂载到一个或多个容器上的卷 中的文件

- 作为容器的环境变量

- 由 kubelet 在为 Pod 拉取镜像时使用。

secret有多个类型

dockerconfigjson

- 用来存储私有 docker registry的认证信息

Service Account

- 只要与Kubernetes API有交互的Pod,都会自动拥有此种类型的Secret

- K8S自动创建,并且会自动挂载到Pod的 /run/secrets/kubernetes.io/serviceaccount 目录中

xxxxxxxxxx#查看kubectl get pod -A | grep 'kube-proxy'#进到容器,加了 -- /bin/bash,不会有警告kubectl exec -it -n kube-system kube-proxy-9wb4g -- /bin/sh#查看ls -l /run/secrets/kubernetes.io/serviceaccountcd /run/secrets/kubernetes.io/serviceaccountcat ca.crtOpaque

- 加密类型为base64,其特点就是将明文改为了密文

xxxxxxxxxxecho -n 'admin' | base64 #账号echo -n '123456' | base64 #密码#创建secret.yamlapiVersion: v1kind: Secretmetadata:name: mysecrettype: Opaquedata:username: YWRtaW4=password: MTIzNDU2- 命令

xxxxxxxxxx#创建kubectl apply -f secret.yaml# 查看secret的信息kubectl get secret# 查看mysecret详细信息kubectl get secret mysecret -o yaml#将secret挂载到Pod的Volume中,创建pod-secret-volume.yamlapiVersion: v1kind: Podmetadata:name: pod-secretspec:containers:- name: nginximage: nginx:1.20volumeMounts: # secret挂载- name: xdclass-configmountPath: /etc/secretvolumes:- name: xdclass-configsecret:secretName: mysecret#创建podkubectl apply -f pod-secret-volume.yaml#查看kubectl get pod -o wide#查看secret, 在pod中的secret信息实际已经被解密kubectl exec -it pod-secret -- /bin/sh#ls /etc/secret#cat /etc/secret/username#cat /etc/secret/password#删除secretkubectl delete secret mysecret

第5集 数据存储NFS网络文件系统搭建实战

简介: 数据存储NFS网络文件系统搭建实战

什么是NFS(Network File System)

一种基于TCP/IP 传输的网络文件系统协议, 通过使用NFS协议,可以像访问本地目录一样访问远程服务器中的共享资源

NFS服务的实现依赖于RPC (Remote Process Call,远端过程调用)机制,以完成远程到本地的映射过程

一般需要安装nfs-utils、 rpcbind 软件包来提供NFS共享服务,前者用于NFS共享发布和访问,后者用于RPC支持

采用TCP/IP传输网络文件,适合局域网环境,简单操作

- NFS端口:2049

- RPC端口:111

NFS 在 K8S Volume里面的作用

- 当某个节点发生故障的时候,该节点上的pod发生了转移,如何保证这些pod的数据不丢失呢?

- 此时就需要引入外部网络文件系统,例如nfs或者其他具有对象存储功能的系统,可以保存当pod发生转移的时候数据也不丢失

部署NFS服务器

下载nfs-util (对应要用到的节点都需要安装,但是不需要启动)

xxxxxxxxxxyum install nfs-utils -y创建目录(nfs服务器)

xxxxxxxxxx#目录可以自定义mkdir /opt/nfsdata#给路径授权chmod 777 /opt/nfsdata编辑/etc/exports 配置文件(nfs服务器)

xxxxxxxxxxvim /etc/exports# 目录的读写权限暴露给这个网段的全部主机/opt/nfsdata 172.31.101.0/24(rw,insecure,sync)解释172.31.101.0/24表示的IP范围, 换成32位二进制,四组,每组8位/24 表示前24位不变,后8位由全0变化到全1的过程,也就是由“00000000”变化到“11111111”又因为全0是子网网络地址,全1是子网广播地址,这两个地址是不分配给主机使用的。所以有效的可分配的范围是前24位不变,后8位由“00000001”变化为“11111110”的范围再转换回十进制就是172.31.101.1~172.31.101.254参数

- rw 共享目录可读可写

- secure 限制客户端只能从小于1024的tcp/ip端口连接服务器;

- insecure允许客户端从大于1024的tcp/ip端口连接服务器;

- sync 将数据同步写入内存缓冲区与磁盘中,效率低,但可以保证数据的一致性;

- async 将数据先保存在内存缓冲区中,必要时才写入磁盘;

启动rpcbind(安装nfs依赖包会自动下载)和nfs服务

xxxxxxxxxxsystemctl start rpcbindsystemctl start nfs验证

- showmount -e localhost

第6集 K8S数据存储之NFS持久卷挂载实战

简介: K8S数据存储之NF持久卷挂载实战

- 创建pod挂载nfs

xxxxxxxxxxapiVersion: v1kind: Podmetadata:name: xdclass-nfsnamespace: devlabels:apps: nginx-nfsspec:containers:- name: nginximage: nginx:1.20ports:- containerPort: 80volumeMounts:- name: logs-volumemountPath: /var/log/nginxvolumes:- name: logs-volumenfs:server: 172.31.101.8 #nfs服务器地址path: /opt/nfsdata #共享文件路径

暴露服务

xxxxxxxxxxkubectl expose pod xdclass-nfs -n dev --port=80 --target-port=80 --type=NodePort查看nfs服务器的/opt/nfsdata

xxxxxxxxxx[root@iZwz90pegu9budx5tk4ruyZ nfsdata]# lsaccess.log error.log- 此时路径下面已经有内容了

访问nginx服务并查看nfs日志

xxxxxxxxxxtail -f access.log172.18.123.230 - - [05/Jul/2022:06:56:25 +0000] "GET / HTTP/1.1" 200 612 "-" "curl/7.29.0" "-"

第7集 K8S高级存储之PV和PVC讲解

简介: K8S高级存储之PV和PVC讲解

Kubernetes 支持的存储插件很多

- awsElasticBlockStore - AWS 弹性块存储(EBS)

- azureDisk - Azure Disk

- azureFile - Azure File

- cephfs- CephFS volume

- azureDisk - Azure Disk

- hostPath - HostPath 卷

- nfs- 网络文件系统 (NFS) 存储

- ...

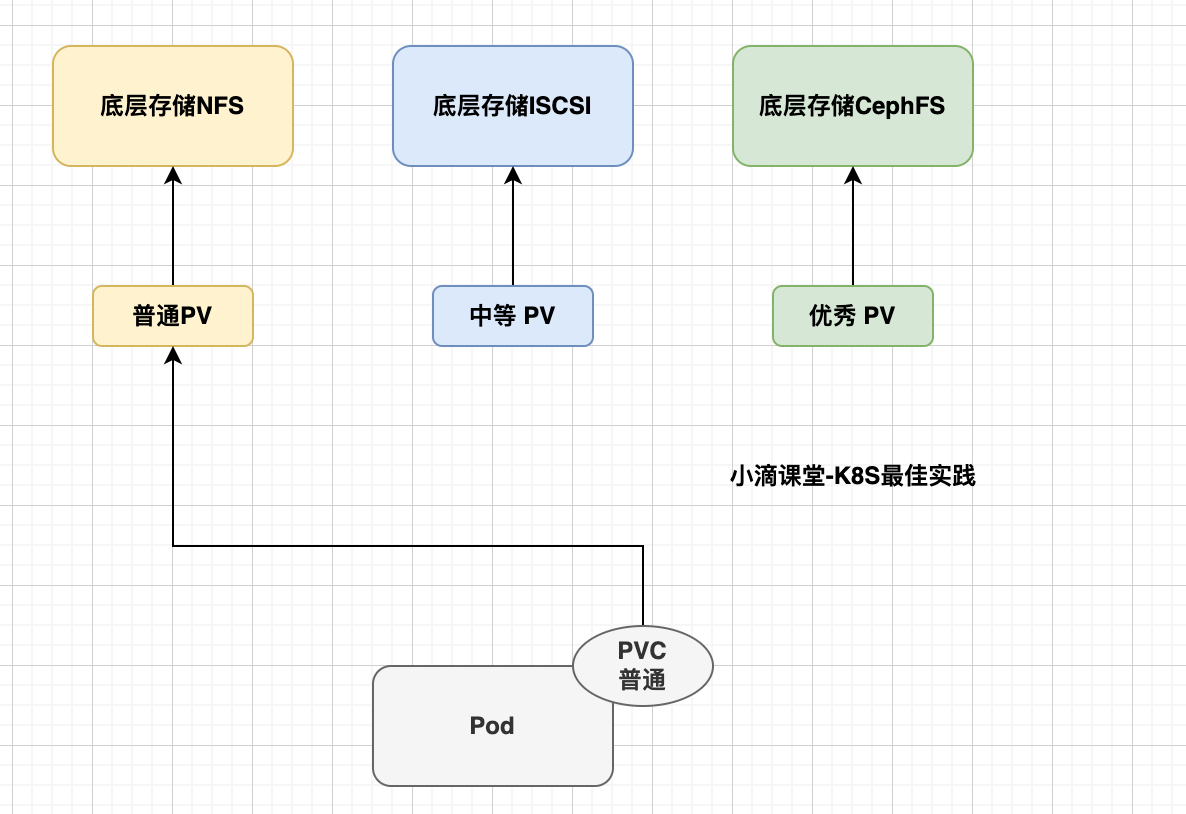

背景

- 在整个k8s集群中,有一些存储的资源,比如说NFS、CIFS等存储,这些存储都是由存储工程师去创建的,不同的存储方式不一样, 如果都掌握才可以使用,则很不方便的

- 所以在k8s中提供了新的对象资源叫做PV(Persistent Volume)和PVC(Persistent Volume Claim),更方便用户直接进行使用

什么是PV 持久卷(Persistent Volume)

- 是集群中由管理员配置的一段网络存储,它是集群的一部分资源和底层存储密切相关,对象包含存储实现的细节,即 对接NFS、CIFS等存储系统

- 不同的PV会对应到不用的存储资源,这样在部署pod的时候直接调用集群内部的pv即可

- PV没有命名空间隔离概念

什么是PVC 持久卷声明 (Persistent Volume Claim)

假如存在很多PV, K8S 要用PV的时候直接调用某个PV的话,那如果需要的是存储能力比较大存储资源,所以这个时候需要一个一个去对比pv,这样很耗费资源(因为要满足需求)

PVC是用户存储的一种声明, PVC 可以请求特定的存储空间和访问模式,PVC 消耗的是 PV 资源

PVC必须与对应的PV建立关系,PVC会根据定义的PV去申请

创建pod的时候会附带一个PVC的请求,PVC的请求相当于就是去寻找一个合适的pv

使用逻辑

- 在 pod 中定义一个存储卷(该存储卷类型为 PVC),定义的时候按指定大小,PVC 必须与对应的 PV 建立关系,PVC 会根据定义的需求【去 PV 申请】,而 PV 是由存储空间创建出来的

PV和PVC逻辑

PV 是集群中的【资源】,PVC 是对这些【资源的请求】

PV 和 PVC 之间的相互作用遵循这个生命周期

- Provisioning(配置) ---> Binding(绑定) ---> Using(使用) ---> Releasing(释放) ---> Recycling(回收)

PV的yaml模板

xxxxxxxxxxapiVersion: v1kind: PersistentVolumemetadata:name: xdclass-pvspec:capacity:storage: 5Gi #存储大小accessModes:#访问模式- ReadWriteOncepersistentVolumeReclaimPolicy: Recycle #回收策略storageClassName: slow #存储类别nfs:#卷插件path: /tmpserver: 172.31.101.8存储大小:存储大小是可以设置和请求的唯一资源。 未来可能会包含 IOPS、吞吐量等属性

访问模式:用户对资源的访问权限

- ReadWriteOnce(RWO):读写权限,只能被单个节点挂载

- ReadOnlyMany(ROX): 只读权限,可以被多个节点挂载

- ReadWriteMany(RWX):读写权限,可以被多个节点挂载

存储类别:

- 每个 PV 可以属于某个类,通过将其 storageClassName属性设置为某个 StorageClass 的名称来指定。

- 特定类的 PV 卷只能绑定到请求该类存储卷的 PVC 申领。

- 未设置 storageClassName 的 PV 卷没有类设定,只能给到那些没有指定特定 存储类的 PVC 申领。

回收策略(当PV不再被使用了之后的处理策略)

- 保留 Retain -- 当PV对象被删除之后,与之相关的位于外部的基础设施中的数据仍然存在(如nfs),需要根据实际情况手动回收

- 回收 Recycle -- 相当于在卷上执行rm -rf /volume/* 操作,之后该卷可以用于新的pvc申领

- 删除 Delete -- 当PV对象被删除之后,与之相关的位于外部的基础设施中的数据也被一并删除(如nfs),需要根据实际情况手动回收,更多是云厂商设备

状态( PV 的生命周期有4种不同状态)

- Available(可用)——一块空闲资源还没有被任何声明绑定

- Bound(已绑定)——卷已经被声明绑定

- Released(已释放)——声明被删除,但是资源还未被集群重新声明

- Failed(失败)——该卷的自动回收失败

PVC的yaml模板

xxxxxxxxxxapiVersion: v1kind: PersistentVolumeClaimmetadata:name: xdclass-pvcnamespace: devspec:accessModes: # 访问模式- ReadWriteManyselector: # 采用label标签对PV选择过滤storageClassName: # 存储类别,设置对应的class的PV才能被系统选出resources: # 需要存储资源的请求requests:storage: 3Gi

第8集 K8S高级存储之NFS+PV和PVC案例实战

简介: K8S高级存储之NFS+PV和PVC案例实战

需求

- 基于NFS存储,创建2个PV

- 创建PVC绑定PV

- 创建Pod挂载PVC

PV和PVC的使用

搭建nfs环境(nfs服务器,基于上面的nfs):

创建目录

xxxxxxxxxxmkdir /opt/nfsdata/pv1mkdir /opt/nfsdata/pv2chmod 777 /opt/nfsdata/pv1chmod 777 /opt/nfsdata/pv2修改配置文件

xxxxxxxxxxvim /etc/exports#暴露nfs服务/opt/nfsdata/pv1 172.31.101.0/24(rw,insecure,sync)/opt/nfsdata/pv2 172.31.101.0/24(rw,insecure,sync)重启nfs

xxxxxxxxxxsystemctl restart nfs

创建两个PV

xxxxxxxxxxapiVersion: v1kind: PersistentVolumemetadata:name: xdclass-pv1spec:capacity:storage: 1GiaccessModes:- ReadWriteManypersistentVolumeReclaimPolicy: Retainnfs:server: 172.31.101.8path: /opt/nfsdata/pv1---apiVersion: v1kind: PersistentVolumemetadata:name: xdclass-pv2spec:capacity:storage: 2GiaccessModes:- ReadWriteManypersistentVolumeReclaimPolicy: Retainnfs:server: 172.31.101.8path: /opt/nfsdata/pv2查看PV

xxxxxxxxxx[root@iZwz99o60h8sytbhpurjc3Z ~]# kubectl get pv -o wideNAME CAPACITY ACCESS MODES RECLAIM POLICY STATUS CLAIM STORAGECLASS REASON AGE VOLUMEMODExdclass-pv1 1Gi RWX Retain Available 25s Filesystemxdclass-pv2 2Gi RWX Retain Available 25s Filesystem创建PVC,使用pvc.yaml (与PV不同,PVC不属于集群资源,拥有自己的名称空间)

xxxxxxxxxxapiVersion: v1kind: PersistentVolumeClaimmetadata:name: xdclass-pvc1namespace: devspec:accessModes:- ReadWriteManyresources:requests:storage: 1Gi---apiVersion: v1kind: PersistentVolumeClaimmetadata:name: xdclass-pvc2namespace: devspec:accessModes:- ReadWriteManyresources:requests:storage: 3Gi查看pvc

xxxxxxxxxx[root@iZwz99o60h8sytbhpurjc3Z ~]# kubectl apply -f pvc.yamlpersistentvolumeclaim/xdclass-pvc1 createdpersistentvolumeclaim/xdclass-pvc2 created[root@iZwz99o60h8sytbhpurjc3Z ~]# kubectl get pvc -n devNAME STATUS VOLUME CAPACITY ACCESS MODES STORAGECLASS AGExdclass-pvc1 Bound xdclass-pv1 1Gi RWX 6sxdclass-pvc2 Pending 6s可以发现目前xdclass-pvc1已经与xdclass-pv1绑定了,而xdclass-pvc2却没有绑定

查看pv

xxxxxxxxxx[root@iZwz99o60h8sytbhpurjc3Z ~]# kubectl get pvNAME CAPACITY ACCESS MODES RECLAIM POLICY STATUS CLAIM STORAGECLASS REASON AGExdclass-pv1 1Gi RWX Retain Bound dev/xdclass-pvc1 20mxdclass-pv2 2Gi RWX Retain Available 20m这是因为pvc2所申请的存储大小为3G,而pv2只能提供2G,因此无法进行绑定。

创建pod 挂载pvc

xxxxxxxxxxapiVersion: v1kind: Podmetadata:name: xdclass-pod1namespace: devspec:containers:- name: xdclass-busyboximage: busyboxcommand: ["/bin/sh","-c","while true;do echo hello xdclass pod1 >> /opt/print.txt; sleep 5; done;"]volumeMounts:- name: volumemountPath: /opt/volumes:- name: volumepersistentVolumeClaim:claimName: xdclass-pvc1readOnly: false---apiVersion: v1kind: Podmetadata:name: xdclass-pod2namespace: devspec:containers:- name: xdclass-busyboximage: busyboxcommand: ["/bin/sh","-c","while true;do echo hello xdclass pod2 >> /opt/print.txt; sleep 5; done;"]volumeMounts:- name: volumemountPath: /opt/volumes:- name: volumepersistentVolumeClaim:claimName: xdclass-pvc2readOnly: false创建pod完成后,到nfs服务器查看 /opt/nfsdata/pv1/print.txt

xxxxxxxxxx[root@iZwz90pegu9budx5tk4ruyZ nfsdata]# tail -f pv1/print.txthello xdclass pod1hello xdclass pod1hello xdclass pod1hello xdclass pod1

愿景:"让编程不再难学,让技术与生活更加有趣"

愿景:"让编程不再难学,让技术与生活更加有趣"

更多架构课程请访问 xdclass.net

第九章 云服务器K8S集群部署SpringBoot项目实战

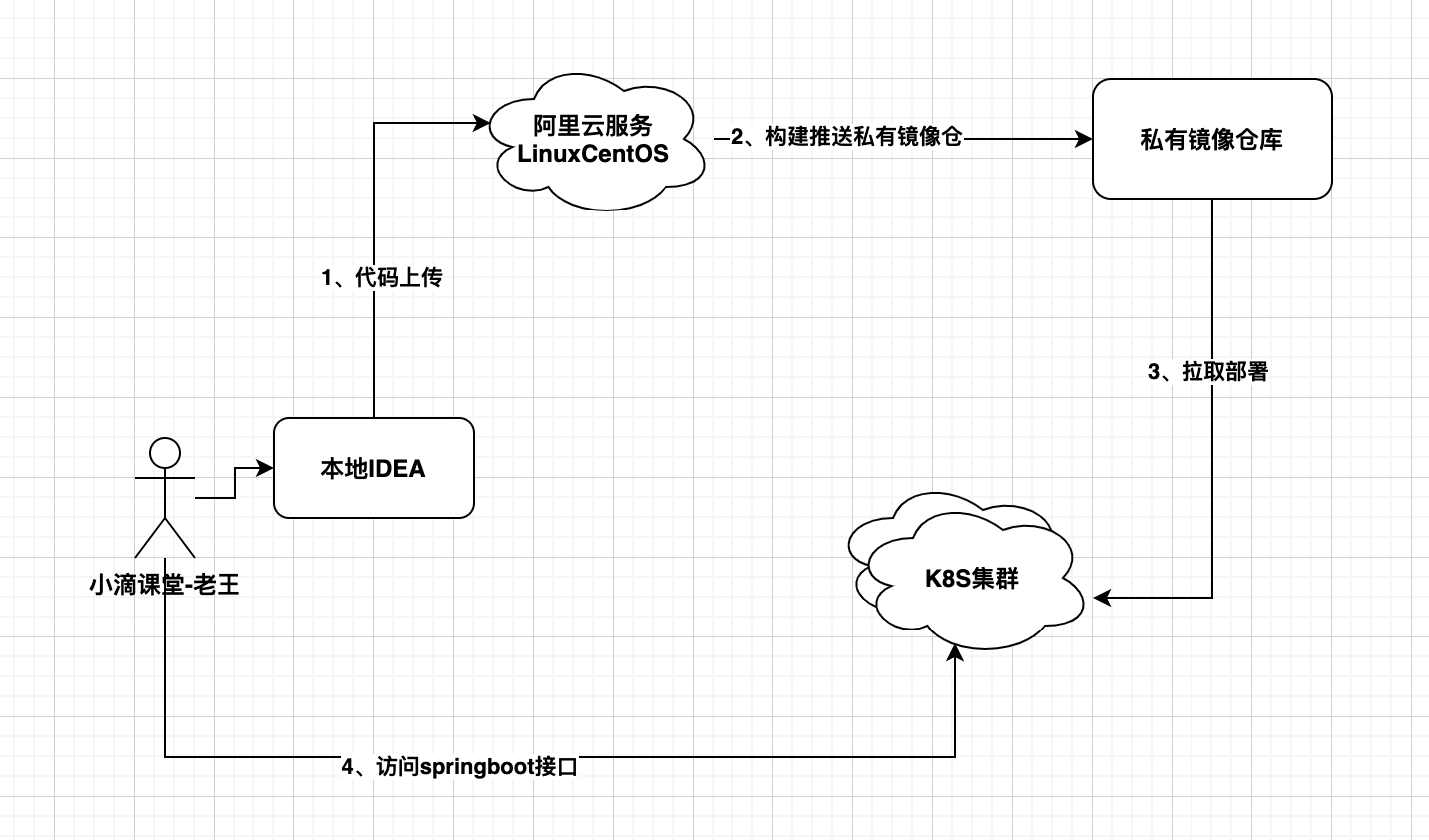

第1集 Kubernetes部署SpringBoot架构讲解

简介: Kubernetes部署SpringBoot架构讲解

需求

- 部署SpringBoot项目到阿里云

- 基于容器打包,推送私有镜像仓库

- 采用K8S集群部署,对外暴露服务,pod副本扩容,公网可以访问

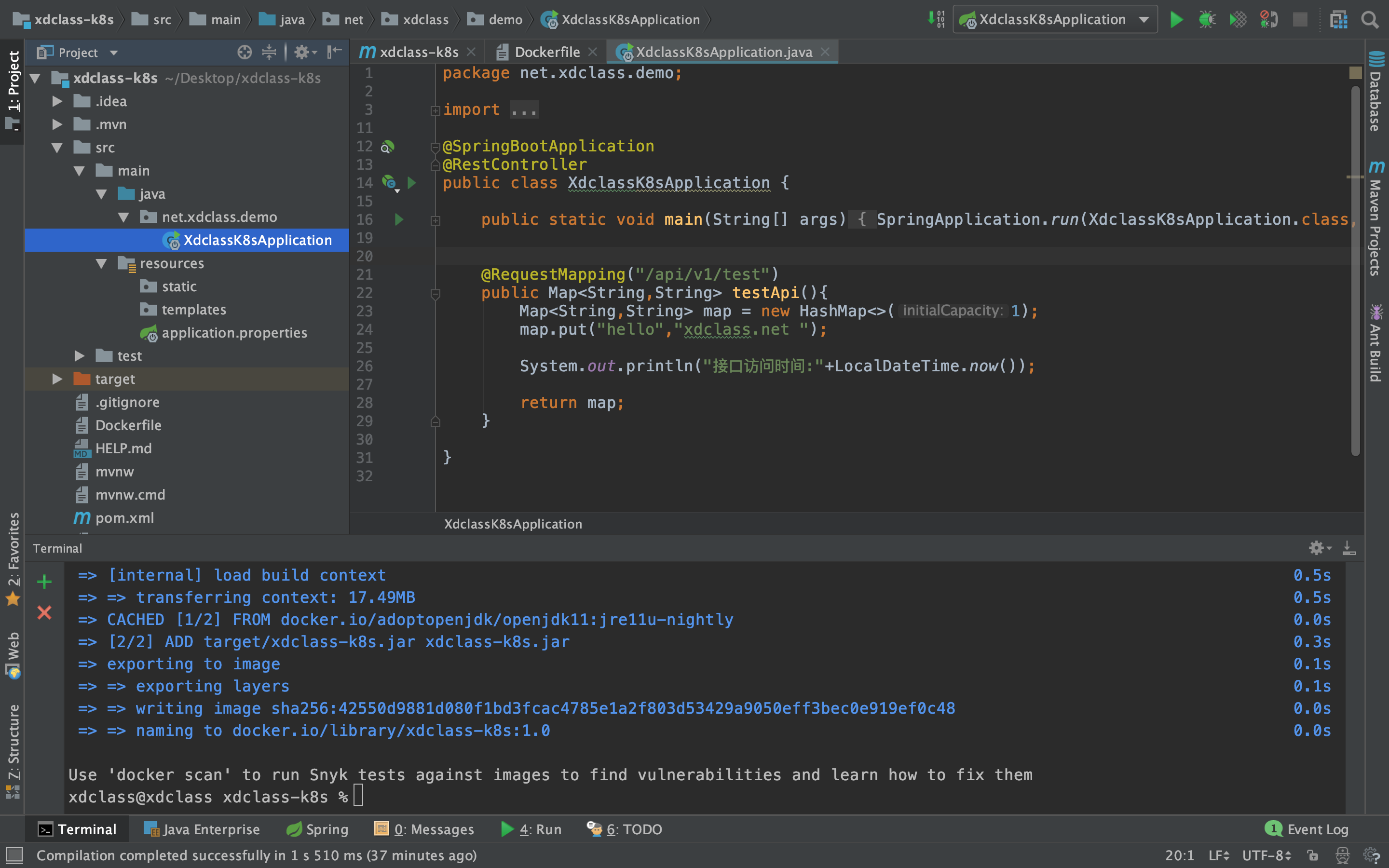

SpringBoot结构代码介绍

- 访问测试接口(本地没环境的可以不访问,需要Jdk11+Maven+IDEA)

部署环境和流程

- 阿里云Linux CentOS 7.X服务器,安装好JDK11、Maven、Docker

- 代码上传阿里云服务器,maven打包,docker构建镜像

- 推送构建好的镜像到私有镜像仓库

- K8S部署服务对外暴露服务

第2集 Linux服务器配置Maven和Jdk11构建环境实战

简介: Linux服务器配置Maven和Jdk构建环境实战

为啥要在Linux下安装Maven和JDK11

- 需要在服务器上打包和构建镜像

安装软件(都在本章本集资料包里面)

安装Docker(本身已经安装)

安装JDK11 配置全局环境变量

- 解压:tar -zxvf jdk-11.0.8_linux-x64_bin.tar.gz

- 重命名

- vim /etc/profile

- 配置

xxxxxxxxxxJAVA_HOME=/usr/local/software/jdk11CLASSPATH=$JAVA_HOME/lib/PATH=$PATH:$JAVA_HOME/binexport PATH JAVA_HOME CLASSPATH环境变量立刻生效

- source /etc/profile

- 查看安装情况 java -version

问题

- 如果环境变量没生效记得重新连接下,重开终端

安装Maven

- 安装 unzip 命令

xxxxxxxxxxyum install unzip -y- 解压 unzip apache-maven-3.5.4-bin.zip

xxxxxxxxxxvim /etc/profileJAVA_HOME=/usr/local/software/jdk/jdk11CLASSPATH=$JAVA_HOME/lib/PATH=$PATH:$JAVA_HOME/binMAVEN_HOME=/usr/local/software/maven3.5PATH=$PATH:$MAVEN_HOME/binexport PATH JAVA_HOME CLASSPATH MAVEN_HOME环境变量立刻生效

- source /etc/profile

- 查看安装情况 mvn -v

第3集 SpringBoot项目构建和打包Docker镜像实战

简介: SpringBoot项目构建和打包Docker镜像实战

上传springboot代码

- 进到项目根目录打包

xxxxxxxxxxmvn clean install- 构建镜像(不要忽略最后的一个点)

xxxxxxxxxxdocker build -t xdclass-k8s:1.0 .- 查看镜像列表

xxxxxxxxxxdocker images- 启动

xxxxxxxxxxdocker run -d -it -p 8080:8080 --name=k8sdemo xdclass-k8s:1.0访问(网络安全组记得开放端口)

- 不要忘记停止这个容器

xxxxxxxxxxdocker logs -f 8e2349c574dbe1bb77c1c78fd714d54374a7f05ea5685ef2092625e341580e99docker stop 8e2349c574dbdocker rm 8e2349c574db

第4集 阿里云私有镜像仓库介绍和镜像推送实战

简介: 阿里云私有镜像仓库介绍和镜像推送实战

官方公共镜像仓库和私有镜像仓库

公共镜像仓库:

- 官方:https://hub.docker.com/,基于各个软件开发或者有软件提供商开发的

- 非官方:其他组织或者公司开发的镜像,供大家免费试用

私有镜像仓库:

用于存放公司内部的镜像,不提供给外部试用;

有哪些?

- Harbor:由VMWare公司开源的容器镜像仓库,Habor是在Docker Registry上进行了相应的企业级扩展

- Registry: 由docker官方提供的私有镜像仓库

- 云厂商提供:阿里云、腾讯云等

开通阿里云私有镜像仓库

登录阿里云账号访问地址:

初次使用会提示开通

配置镜像仓库密码(不是阿里云密码)

推送私有镜像仓

- 登录

xxxxxxxxxxdocker login --username=xdclass666 registry.cn-shenzhen.aliyuncs.com#打tagdocker tag [ImageId] registry.cn-shenzhen.aliyuncs.com/xdclass-k8s/xdclass-demo:[镜像版本号]docker tag 0e0ce8186dbf registry.cn-shenzhen.aliyuncs.com/xdclass-k8s/xdclass-demo:1.0#推送docker push registry.cn-shenzhen.aliyuncs.com/xdclass-k8s/xdclass-demo:[镜像版本号]docker push registry.cn-shenzhen.aliyuncs.com/xdclass-k8s/xdclass-demo:1.0#拉取docker pull registry.cn-shenzhen.aliyuncs.com/xdclass-k8s/xdclass-demo:[镜像版本号]- 查看镜像仓库

第5集 K8S部署SpringBoot项目实战《上》

简介: K8S部署SpringBoot项目实战《上》

K8S部署SpringBoot步骤

- 步骤一:登录私有镜像仓,拉取镜像

- 步骤二:创建deployment

- 步骤三:暴露服务访问端口即可

secret有多个类型

dockerconfigjson

- 存储私有 docker registry的认证信息

- 用来创建用户docker registry认证的Secret,直接使用kubectl create命令创建即可

Service Account

Opaque

步骤

- 创建secert

xxxxxxxxxxkubectl create secret docker-registry xdclass-docker-secret --docker-server=registry.cn-shenzhen.aliyuncs.com --docker-username=用户名 --docker-password=登录密码kubectl create secret docker-registry xdclass-docker-secret --docker-server=registry.cn-shenzhen.aliyuncs.com --docker-username=xdclass666 --docker-password=xdclass.net168- 创建k8sdemo-deployment的yaml文件

xxxxxxxxxxkubectl create deployment k8sdemo --image=registry.cn-shenzhen.aliyuncs.com/xdclass-k8s/xdclass-demo:1.0 --dry-run=client -o yaml > xdclass-k8s.yaml[root@iZwz90pegu9budx5tk4ruzZ ~]# cat xdclass-k8s.yamlapiVersion: apps/v1kind: Deploymentmetadata:creationTimestamp: nulllabels:app: k8sdemoname: k8sdemospec:replicas: 1selector:matchLabels:app: k8sdemostrategy: {}template:metadata:creationTimestamp: nulllabels:app: k8sdemospec:containers:- image: registry.cn-shenzhen.aliyuncs.com/xdclass-k8s/xdclass-demo:1.0name: xdclass-k8sresources: {}status: {}- 修改xdclass-k8s.yaml

xxxxxxxxxx1)修改副本数量为 22)挂载 secretapiVersion: apps/v1kind: Deploymentmetadata:creationTimestamp: nulllabels:app: k8sdemoname: k8sdemospec:replicas: 2selector:matchLabels:app: k8sdemostrategy: {}template:metadata:creationTimestamp: nulllabels:app: k8sdemospec:imagePullSecrets:- name: xdclass-docker-secretcontainers:- image: registry.cn-shenzhen.aliyuncs.com/xdclass-k8s/xdclass-demo:1.0name: xdclass-k8sresources: {}status: {}

第6集 K8S部署SpringBoot项目实战《下》

简介: K8S部署SpringBoot项目实战《下》

- 创建delpoyment控制器

xxxxxxxxxxkubectl apply -f xdclass-k8s.yaml

- 创建service, nodePort类型

xxxxxxxxxxkubectl expose deploy k8sdemo --port=8080 --target-port=8080 --type=NodePort

测试运行

- 工作节点访问pod

xxxxxxxxxxcurl ip+port- 网络安全组开放3XXXX端口后,也可以通过ip+XXXX/api/v1/test访问

- 查看日志

xxxxxxxxxxkubectl get pod -o widekubectl exec -it k8sdemo -- /bin/sh

愿景:"让编程不再难学,让技术与生活更加有趣"

愿景:"让编程不再难学,让技术与生活更加有趣"

更多架构课程请访问 xdclass.net

第十章 容器编排调度-K8S可视化工具Rancher2.x实战

第1集 K8S集群可视化管理工具介绍

简介: K8S集群可视化管理工具介绍

为了解决容器管理的问题,就有了容器编排管理工具

主流的容器编排工具

- Docker Swarm

- Apache Mesos

- Kubernetes

xxxxxxxxxx经过几年的竞争,K8S 击败 Swarm 和 Mesos,几乎成了当前容器编排的事实标准K8S 最初是由 Google 开发的,后来捐赠给了 CNCF(云原生计算基金会,隶属 Linux 基金会)K8S 既然那么猛,直接拿来用不香吗?

- 文档 http://docs.kubernetes.org.cn/251.html

- 如果当练习,看官方文档很快上手,上手的前提要懂很多概念

xxxxxxxxxxPod、Service、Node、kubelet、kube-proxy、API Server、Scheduler、Labels、Deployment...- 当要搭建生产环境的时候,事情就变得不一样了

- 不止搭建集群过程很复杂,后期还要面对更繁琐的 K8S 控制平面维护工作,版本升级、安全管控、数据备份

- 对于k8s集群的运维复杂度也很高

等你掌握一系列概念后且搭建过本地的k8s

- 开发人员的你:一个月后你会忘记80%的知识

- 公司里:能用上k8s的公司,基本不太可能让一个业务开发人员去操作到k8s的东西

- 公司谁负责:运维工程师、容器开发工程师、云平台开发工程师等

什么是K8S 可视化管理工具

- 目前操作k8s可以通过命令行kubectl进行完成,但是如果有可视化工具则更方便

- 可视化工具都是基于K8s提供功能,是比较优秀的k8s集群管理平台,对于降低k8s集群运维复杂度,降低运维成本,使开发人员能尽快上手部署微服务

可视化工具介绍

kubernetes Dashboard

- 是 k8s集群的一个 WEB UI管理工具

- 代码托管在 github 上,https://github.com/kubernetes/dashboard/releases

- 操作Dashboard 可以部署容器、监控、排查故障等功能

KubeSphere

- KubeSphere 是在 Kubernetes 之上构建的面向云原生应用的分布式操作系统,完全开源,支持多云与多集群管理,提供全栈的 IT 自动化运维能力,简化企业的 DevOps 工作流

- 它的架构可以非常方便地使第三方应用与云原生生态组件进行即插即用 (plug-and-play) 的集成。

- 地址:https://kubesphere.com.cn/

Rancher

- 是一个开源的企业级容器管理平台, 通过Rancher企业再也不必自己使用一系列的开源软件去从头搭建容器服务平台。

- Rancher提供了在生产环境中使用的管理Docker和Kubernetes的全栈化容器部署与管理平台

- 地址:https://rancher.com/

第2集 容器编排管理平台Rancher介绍和概念讲解

简介:容器编排管理平台Rancher介绍和概念讲解

什么是Rancher

是一个开源的企业级PaaS容器管理平台。通过Rancher,企业再也不必自己使用一系列的开源软件去从头搭建容器服务平台

Rancher提供了在生产环境中使用的管理Docker和Kubernetes的全栈化容器部署与管理平台

通信模型介绍

- Client-Server模式

- 每个Linux主机是Client端,需要连接到Rancher的Server端

特性

基础设施编排

- 可以使用任何公有云或者私有云的Linux主机资源

- Linux主机可以是虚拟机,也可以是物理机

- Rancher仅需要主机有CPU,内存,本地磁盘和网络资源,从Rancher的角度来说,一台云厂商提供的云主机和一台自己的物理机是一样的

容器编排与调度

- 包含了当前全部主流的编排调度引擎,例如Docker Swarm, Kubernetes, 和Mesos

- 同一个用户可以创建Swarm或者Kubernetes集群。并且可以使用原生的Swarm或者Kubernetes工具管理应用

- 除了Swarm,Kubernetes和Mesos之外,Rancher还支持自己的Cattle容器编排调度引擎

- Cattle被广泛用于编排Rancher自己的基础设施服务以及用于Swarm集群,Kubernetes集群和Mesos集群的配置,管理与升级

中文文档

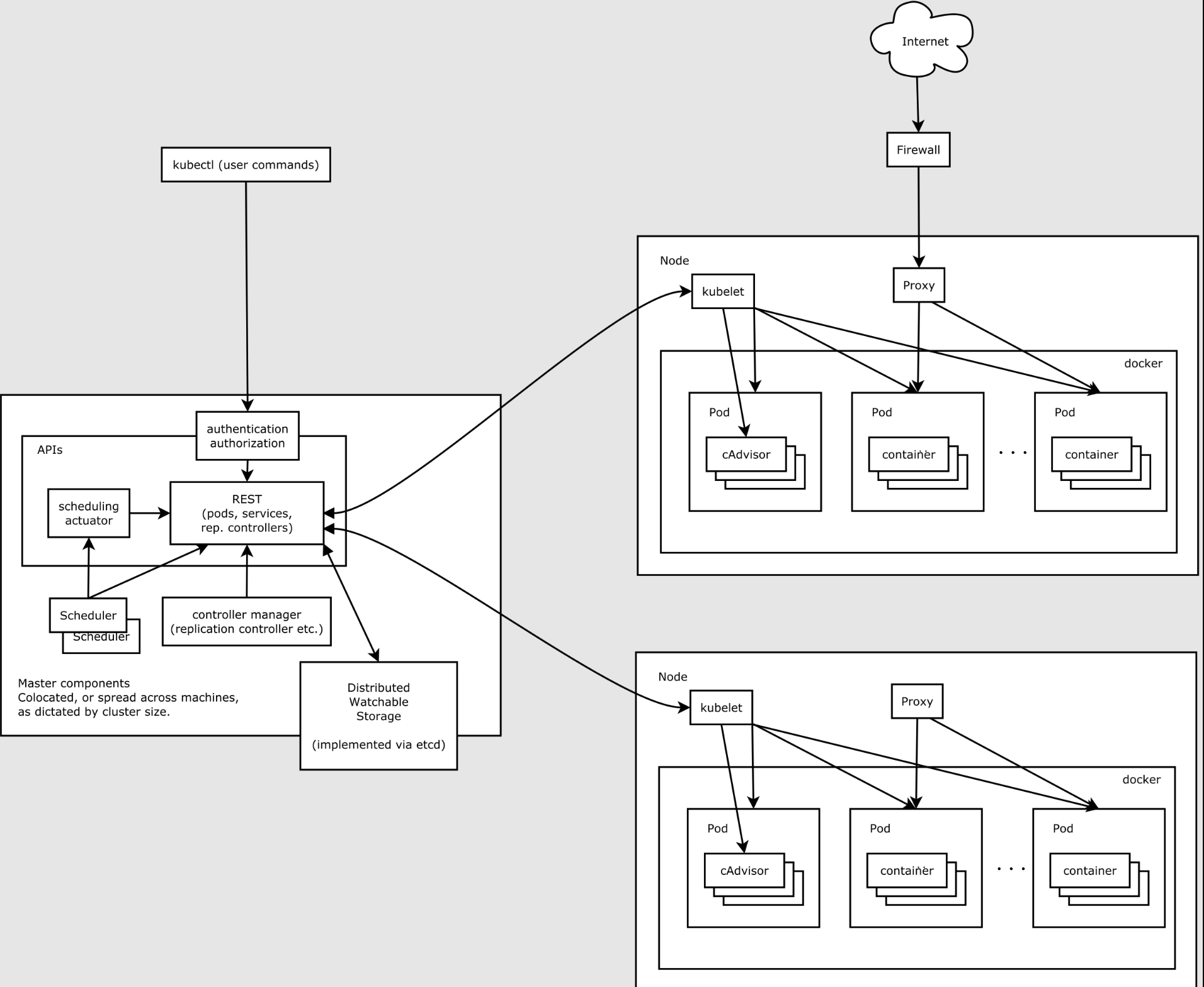

第3集 云服务器Docker容器化部署Rancher2.x实战

简介:云服务器Docker容器化部署Rancher2.x实战

注意事项

基于Docker镜像安装Rancher,阿里云 Linux CentOS 7.8 + Docker-20.10.10

- 2核8g内存+5M带宽

选择Rancher机器可以把【内存+带宽】弄大点,因为Rancher部署好后需要下载很多的镜像,不要因为内存问题导致部署没成功

安装Docker

xxxxxxxxxx# 1.先安装ymlyum install -y yum-utils device-mapper-persistent-data lvm2# 2.设置阿里云镜像sudo yum-config-manager --add-repo http://mirrors.aliyun.com/docker-ce/linux/centos/docker-ce.repo# 3.查看可安装的docker版本yum list docker-ce --showduplicates | sort -r#4. 安装dockeryum -y install docker-ce-20.10.10-3.el7#5. 查看docker版本docker -v#配置开机自启动systemctl enable docker.service#6. 启动dockersystemctl start docker#7. 查看docker 启动状态systemctl status docker安装Rancher

创建Rancher挂载目录

xxxxxxxxxxmkdir -p /data/rancher_home/ranchermkdir -p /data/rancher_home/auditlog部署Rancher

xxxxxxxxxxdocker run -d --privileged --restart=unless-stopped -p 80:80 -p 443:443 \-v /data/rancher_home/rancher:/var/lib/rancher \-v /data/rancher_home/auditlog:/var/log/auditlog \--name xdclass_rancher1 rancher/rancher:v2.5.7登录Rancher

启动成功rancher后, 可以打开浏览器输入IP地址来进入Rancher

登录地址为:http://+IP ,如:http://47.106.69.xxx

配置账号密码,填写完账号密码后直接Continue即可。

保存配置

- 点击Continue后进入到Server URL页面,这里显示的是IP(公网ip)地址,不用管直接点击SaveURL

- 设置Rancher语言,在主页面的右下角点击切换一下即可

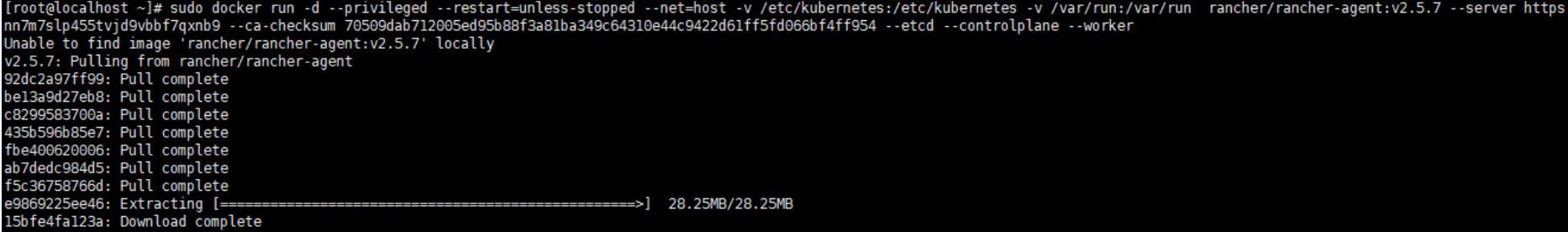

第4集 Rancher2.X添加集群配置RancherAgent节点

简介:Rancher2.X添加集群配置RancherAgent节点

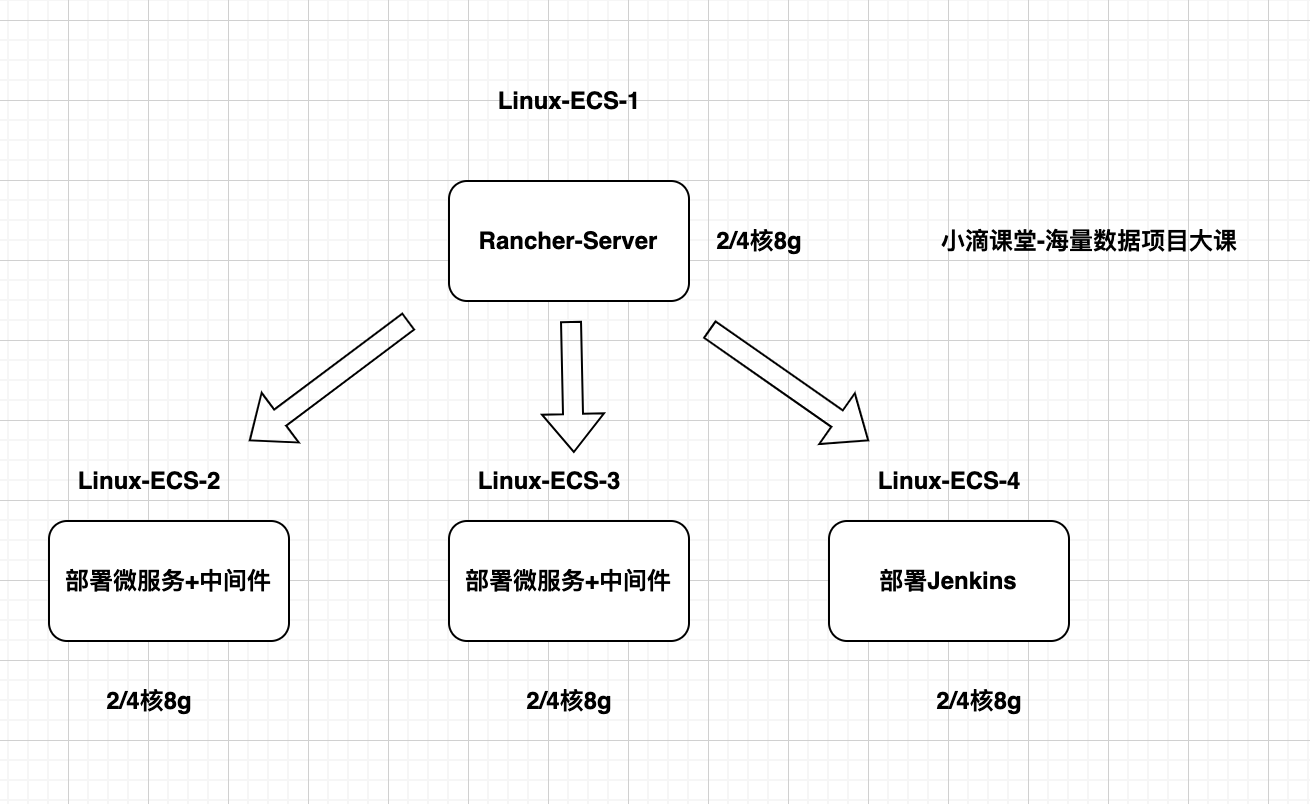

基于K8S集群的Rancher可以加很多节点

- 只要资源足够多,可以部署很多中间件

- 需要的Linux服务器资源比较多,前期就两台节点部署

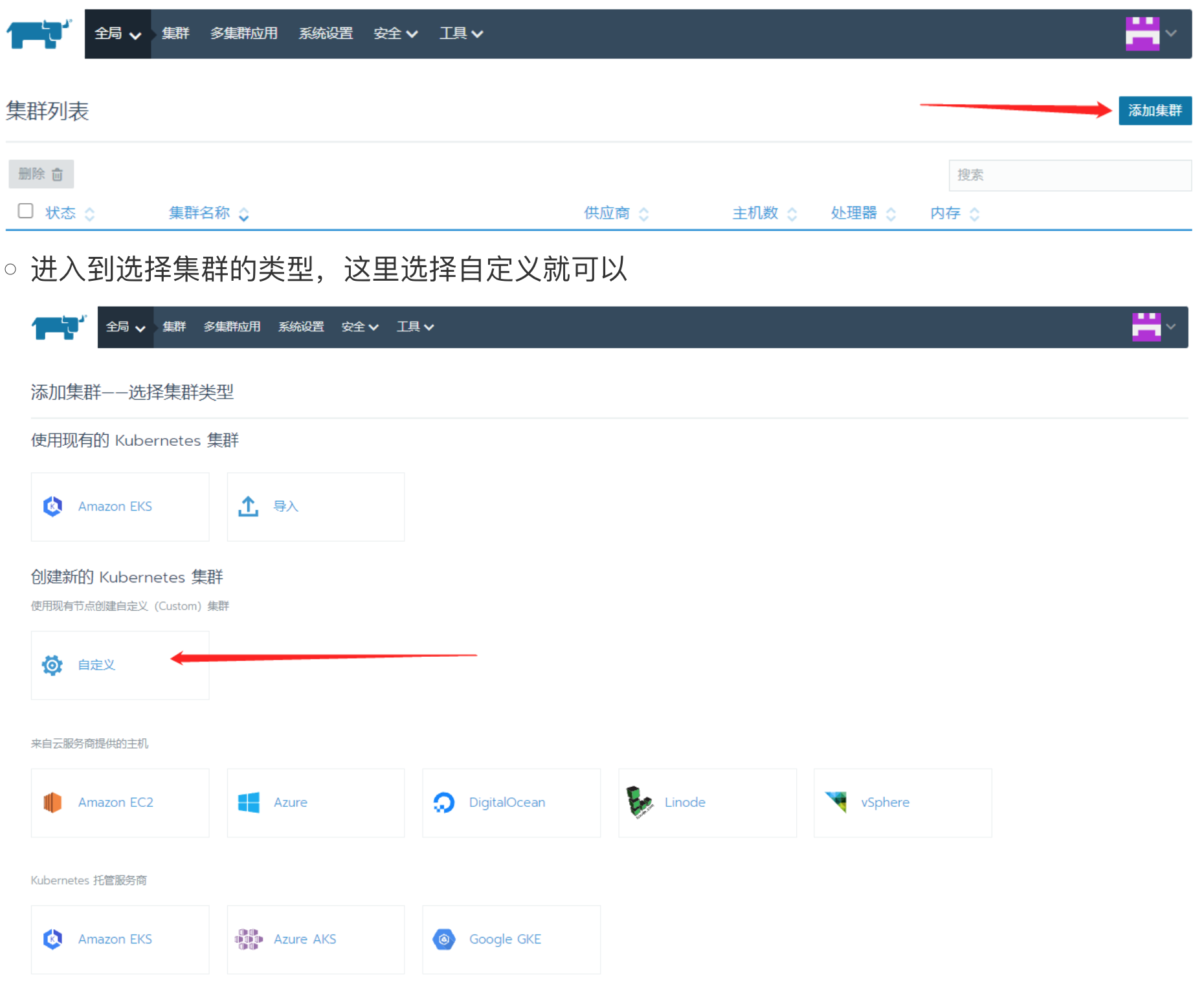

- 创建项目集群

- 进入到选择集群的类型,这里选择自定义就可以

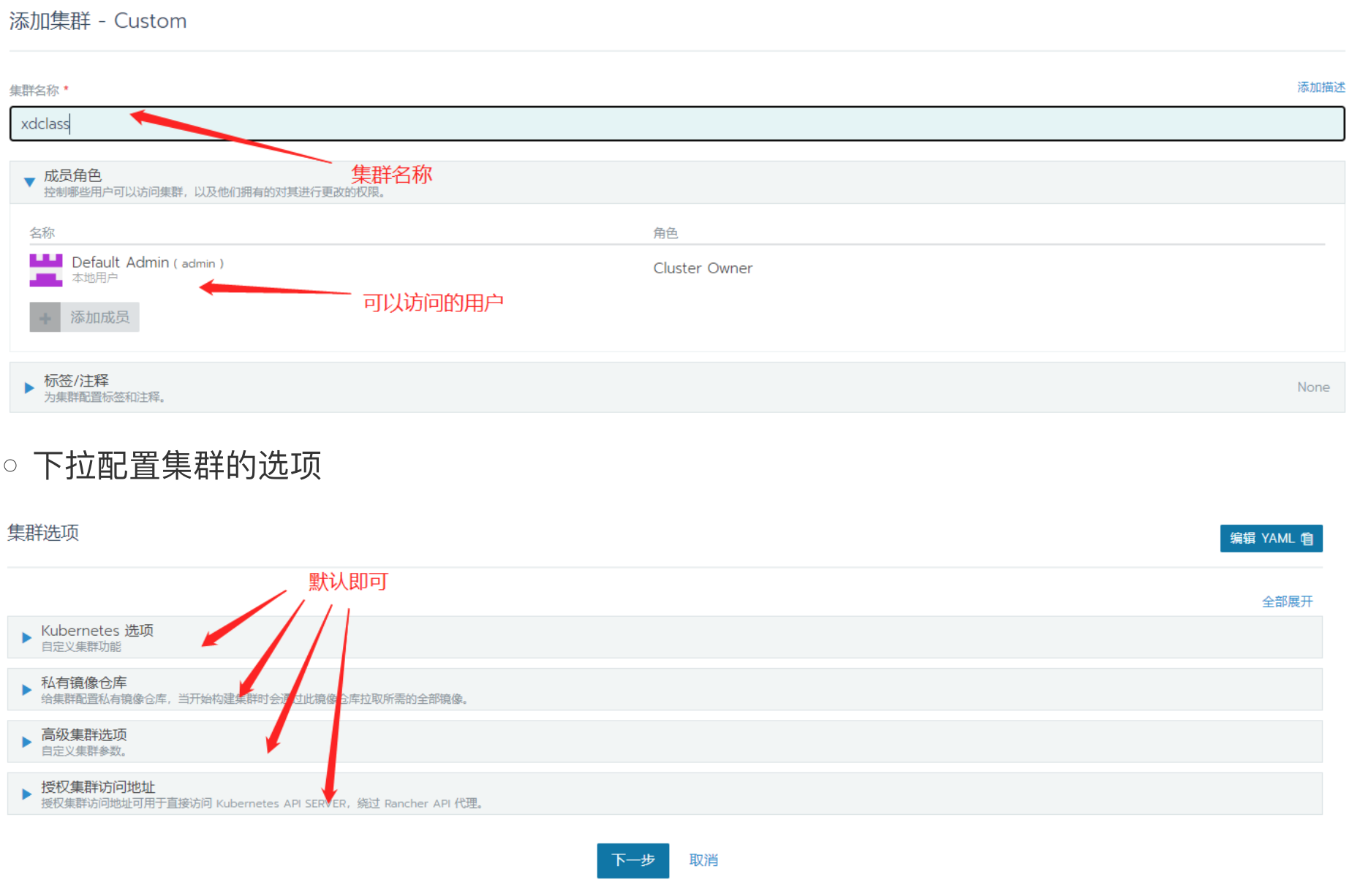

- 进入到添加集群-Custom页面

- 我们点击下一步

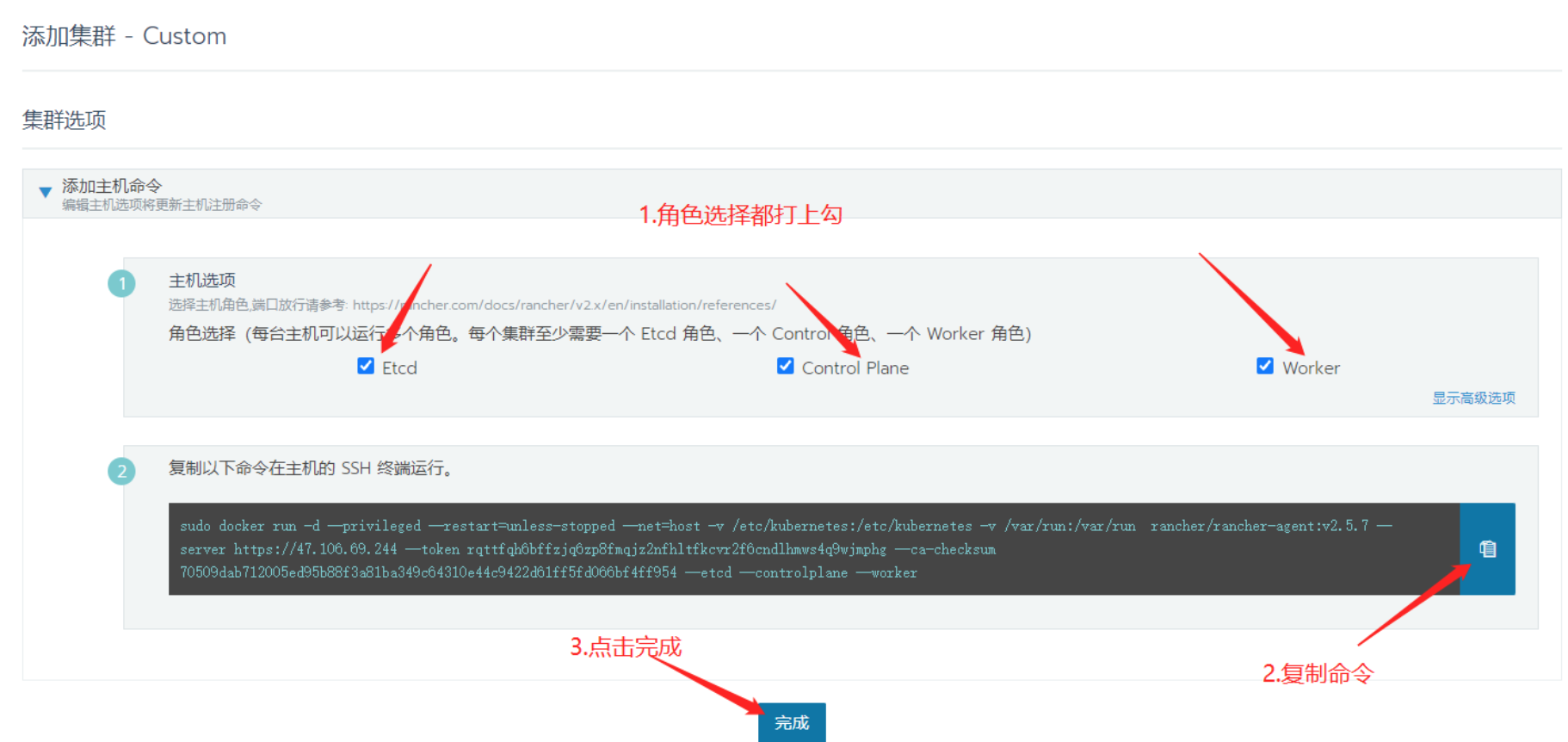

添加Linux主机节点(主机节点安装启动好docker)

xxxxxxxxxx# 1.先安装ymlyum install -y yum-utils device-mapper-persistent-data lvm2# 2.设置阿里云镜像sudo yum-config-manager --add-repo http://mirrors.aliyun.com/docker-ce/linux/centos/docker-ce.repo# 3.查看可安装的docker版本yum list docker-ce --showduplicates | sort -r#4. 安装dockeryum -y install docker-ce-20.10.10-3.el7#5. 查看docker版本docker -v#配置开机自启动systemctl enable docker.service#6. 启动dockersystemctl start docker#7. 查看docker 启动状态systemctl status docker- 终端中运行复制下来的命令按Enter键等待下载好相应的镜像即可

- 我们就把主机给添加到所创建的集群中

- 回到Rancher的主界面

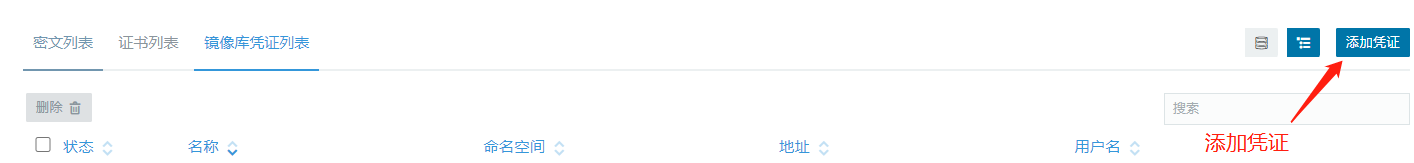

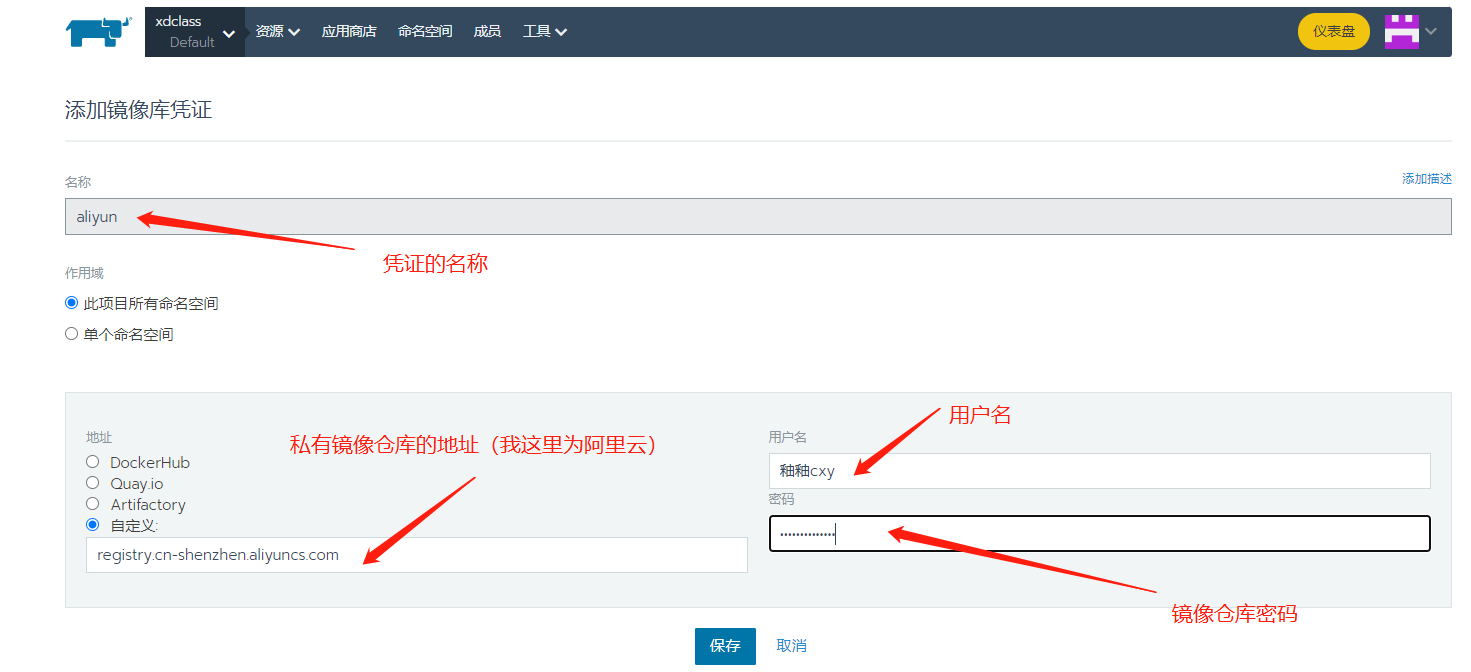

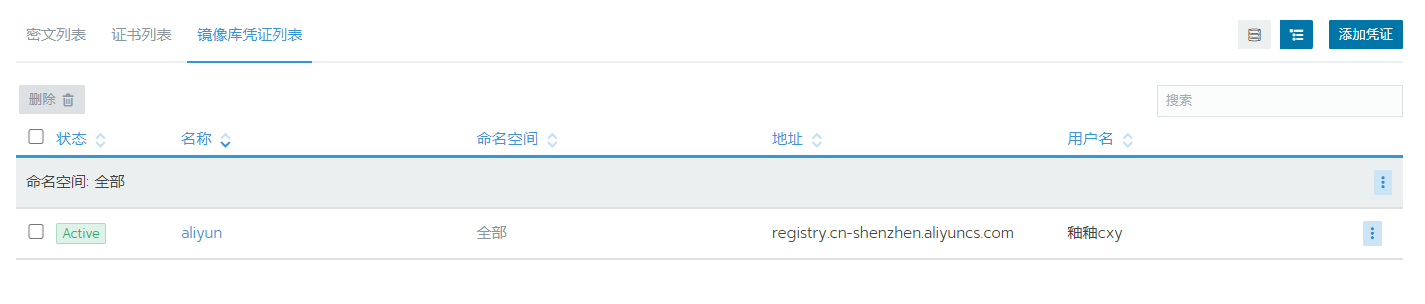

第5集 Rancher2.X配置Docker私有镜像仓库实战

简介:Rancher2.X配置私有镜像仓库实战

私有镜像仓库配置

- 在顶部的导航栏找到-资源->密文

- 最右边有添加凭证按钮,点击进去

- 添加镜像库凭证

- 成功添加镜像库凭证

愿景:"让编程不再难学,让技术与生活更加有趣"

愿景:"让编程不再难学,让技术与生活更加有趣"

更多架构课程请访问 xdclass.net

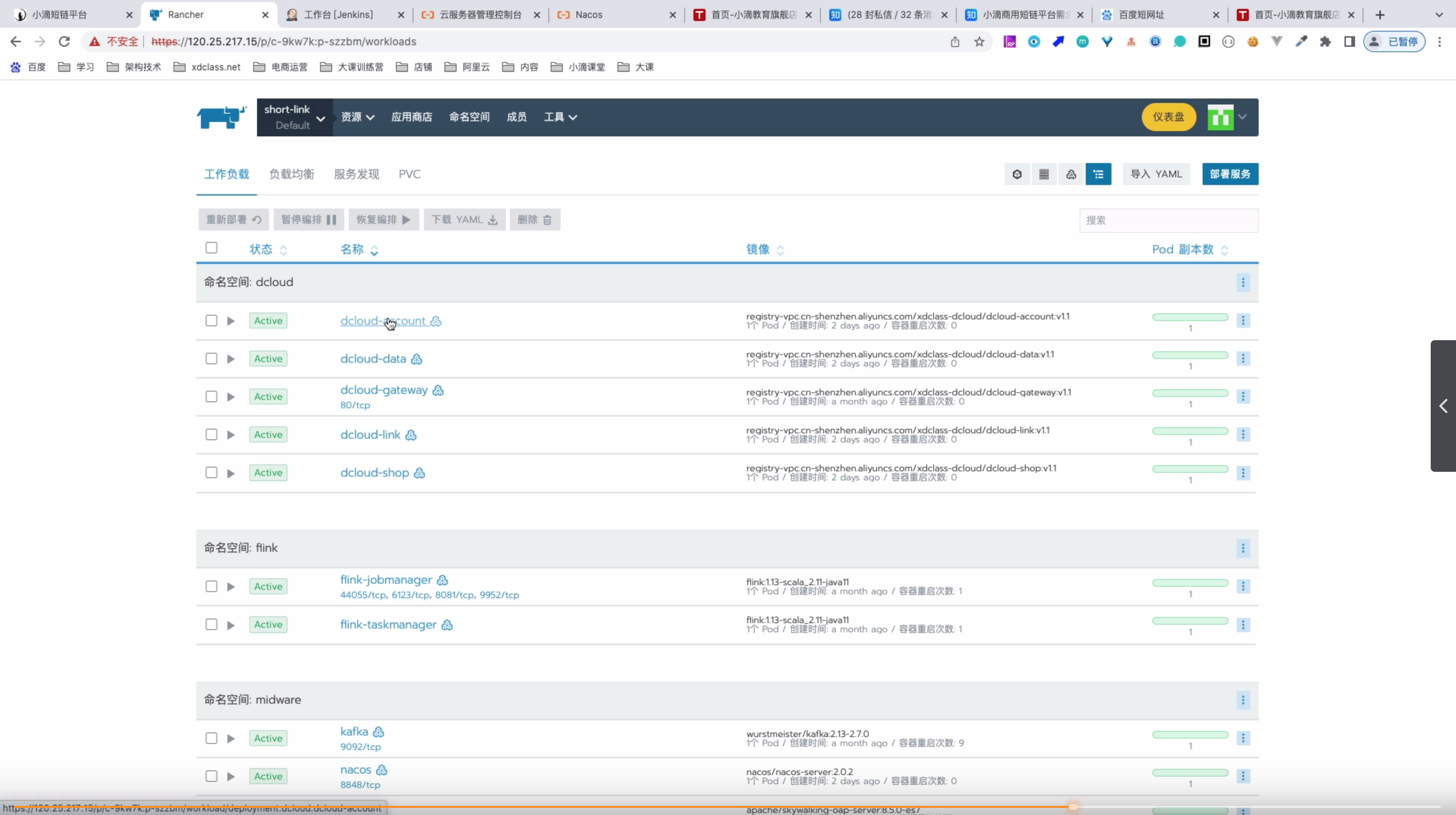

第十一章 Rancher2.X部署多案例镜像实战

第1集 Rancher部署SpringBoot私有镜像实战

简介: Rancher部署SpringBoot私有镜像实战

部署之前K8S命令部署的应用

备注

- 看过 微服务架构海量数据项目大课 或 高并发项目大课的同学,各个参数更明白

- 地址:https://detail.tmall.com/item.htm?id=659917587313

- 强烈推荐看完 K8S专题课程后看上面的海大

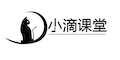

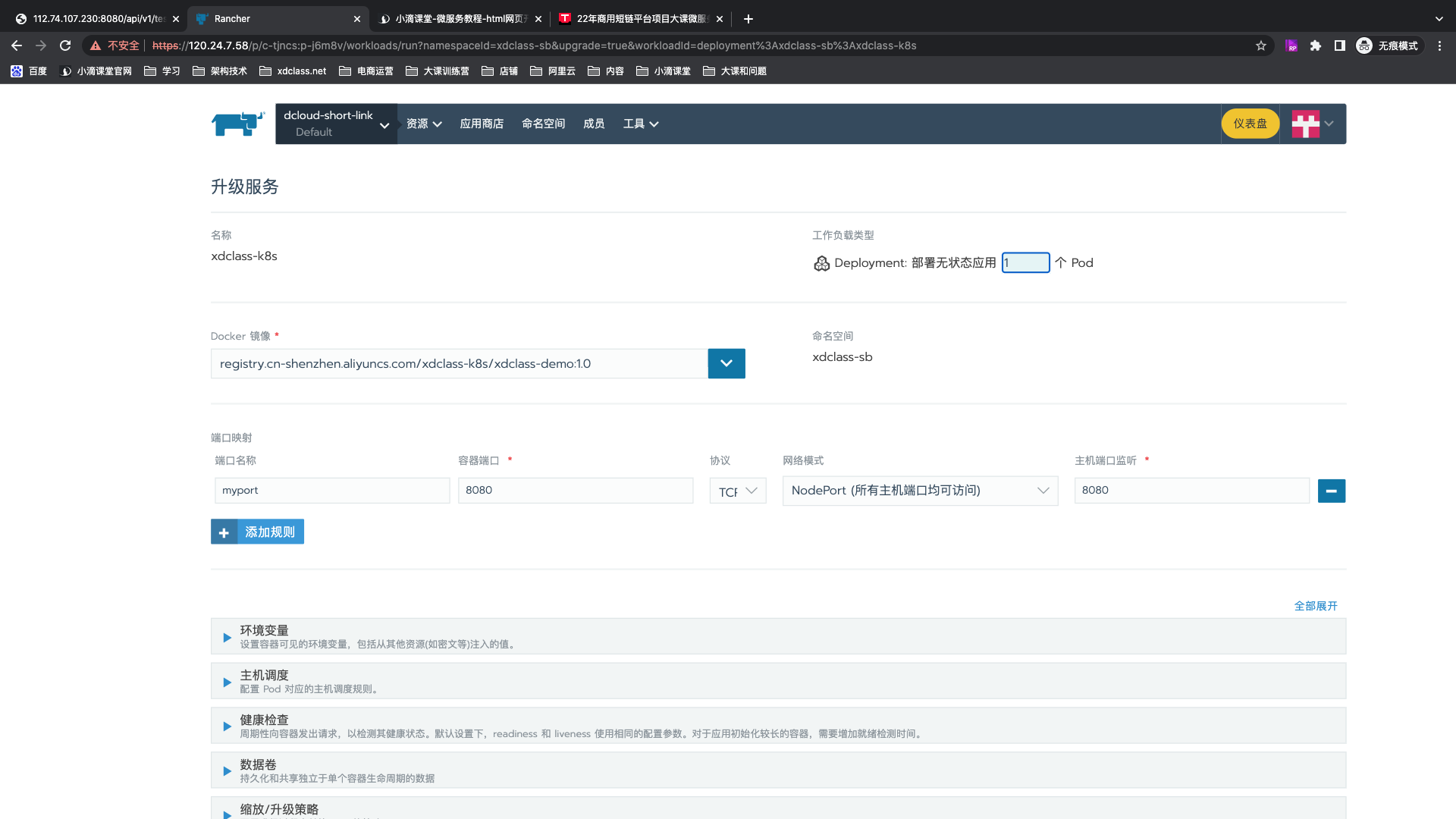

新增工作负载

- 编辑集群-端口可用范围(可以指定对外暴露的服务端口)

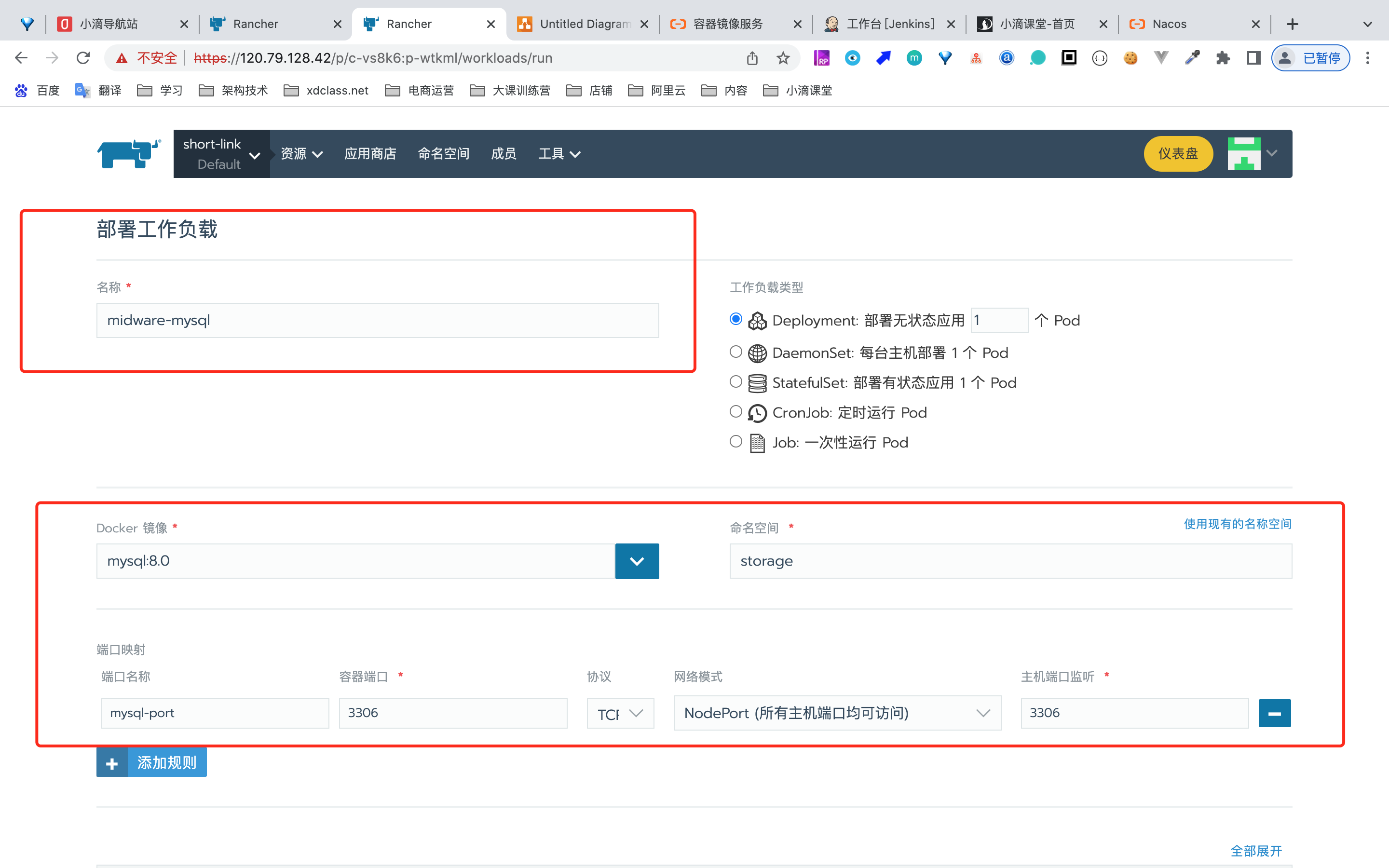

第2集 Rancher2.X部署中间件-Mysql8.0

简介:Rancher2.X部署中间件-Mysql8.0

注意

常规互联网企业里面的中间件,运维工程师负责搭建

部分组件可以选择直接部署:容器、源码编译,并非一定要某个方式

- 比如某些组件需要特定的版本,但是平台存在不兼容或者配置方式不支持等

同个Rancher命名空间下,ip可以使用【容器服务名称】进行替代

部署Mysql

业务微服务使用

- 名称:service-mysql

- 端口 :3306:3306

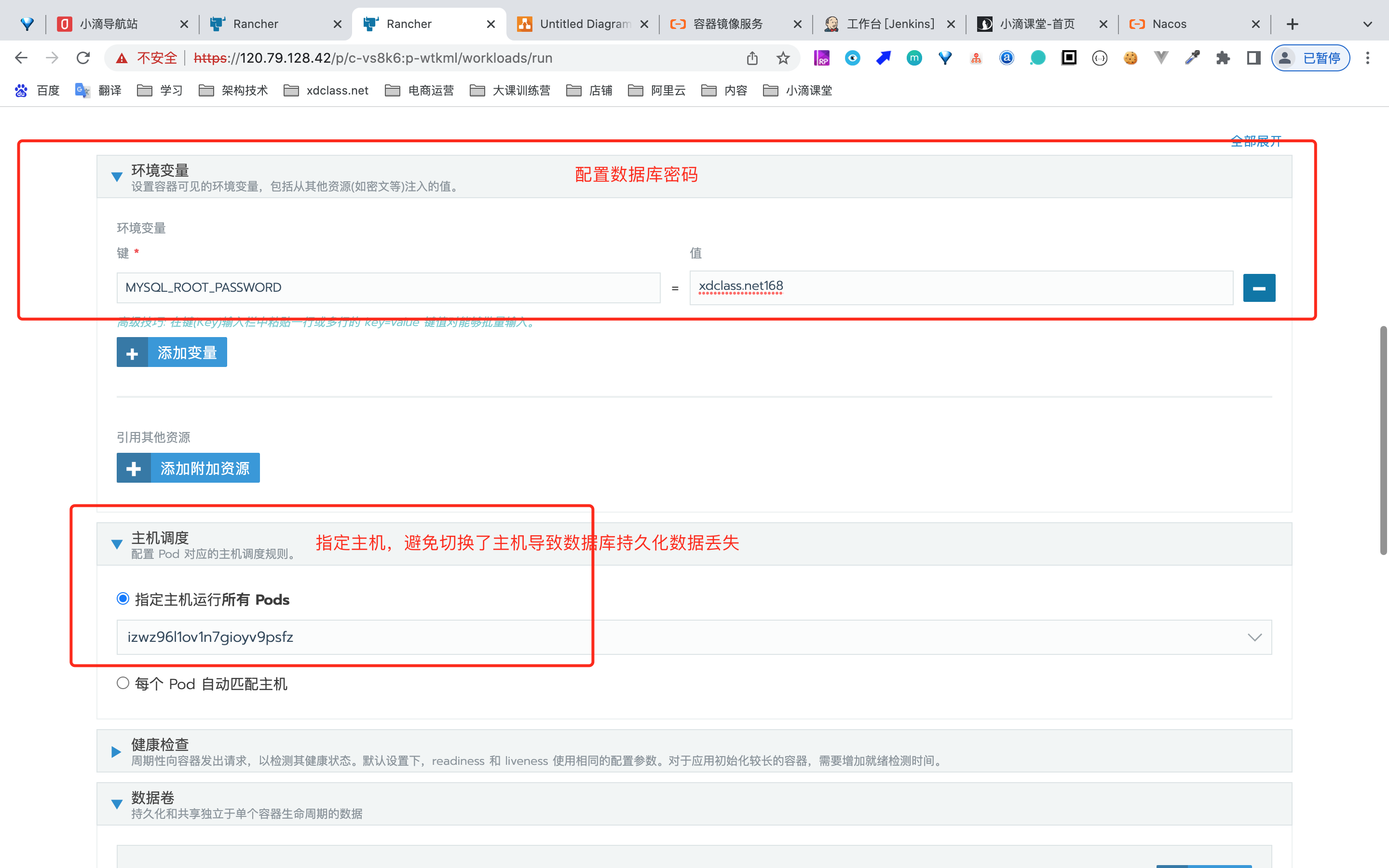

配置

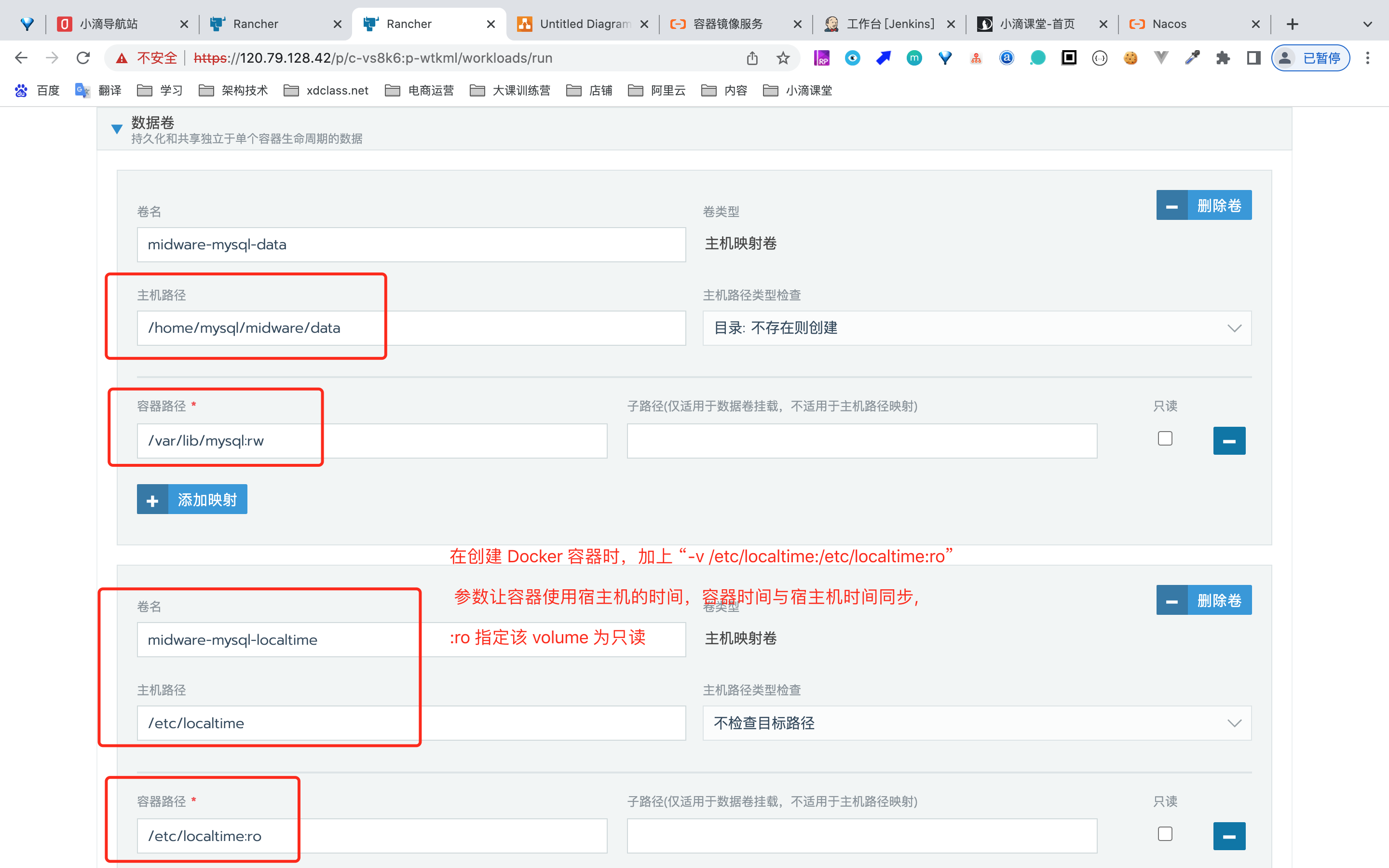

xxxxxxxxxx镜像:mysql:8.0环境变量:MYSQL_ROOT_PASSWORD=xdclass.net168路径映射/home/data/mysql/data/var/lib/mysql:rw/etc/localtime/etc/localtime:ro在创建 Docker 容器时,加上 “-v /etc/localtime:/etc/localtime:ro” 参数让容器使用宿主机的时间,容器时间与宿主机时间同步,:ro 指定该 volume 为只读

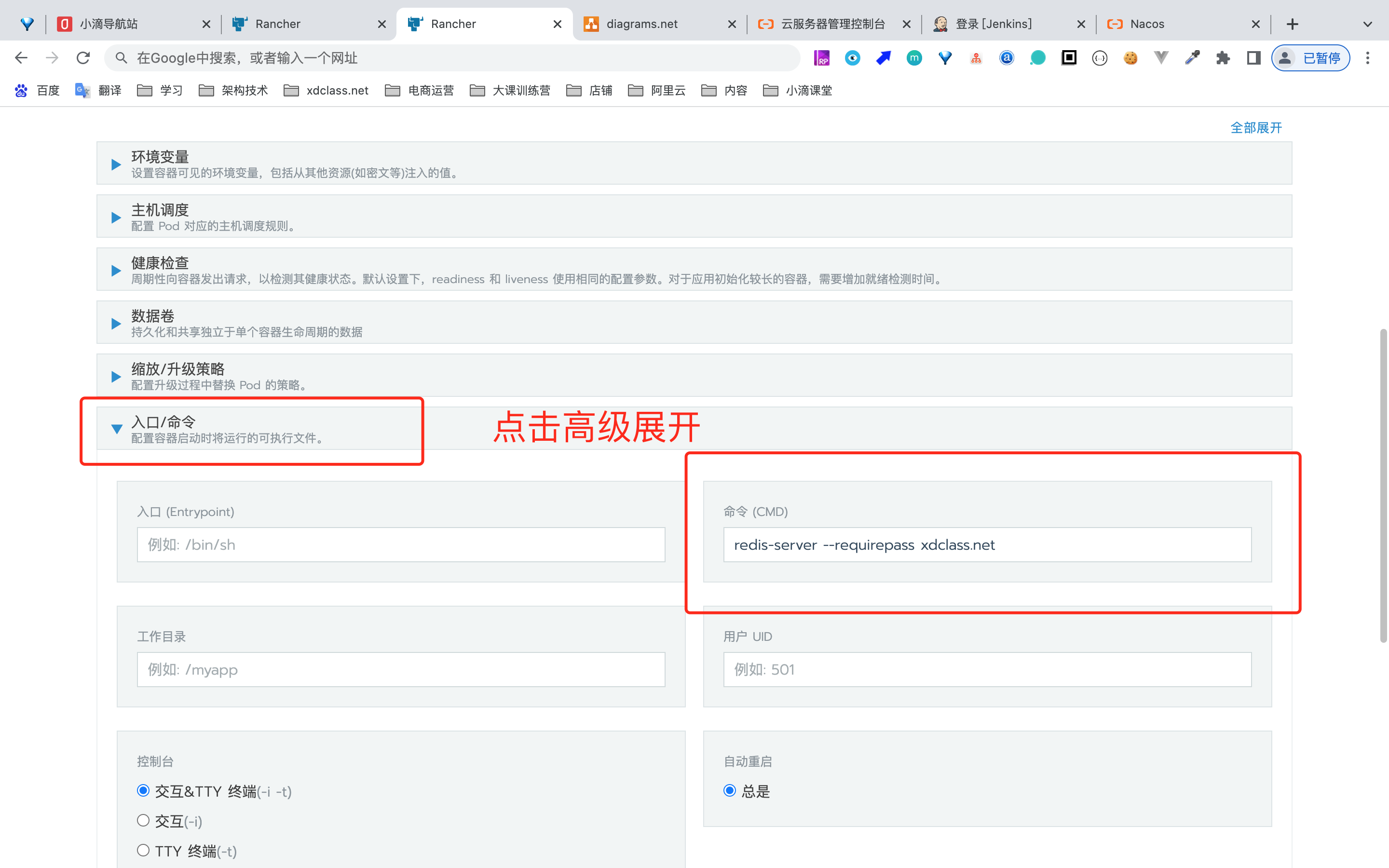

第3集 Rancher2.X部署分布式缓存Redis7实战

简介:Rancher2.X部署分布式缓存Redis7实战

注意

- 很多中间件并非要Rancher部署,常规源码或者Docker部署就行

- 课程方便管理为主则用Rancher部署

- 实际公司里面,运维负责搭建安装部署,开发人员使用即可

部署Redis

- 在rancher中设置的,redis密码不是环境变量,而是命令入口配置

- 网络安全组记得开放端口

xxxxxxxxxx镜像:redis:7.0.2端口:6379:6379数据卷:/mydata/redis/data/data入口命令redis-server --requirepass xdclass.net

第4集 Rancher里面kubectl命令解析和yaml备份

简介: Rancher里面kubectl命令解析和yaml备份

- Rancher里面kubectl命令操作

yaml文件备份

- 导出和导入

- yaml查看

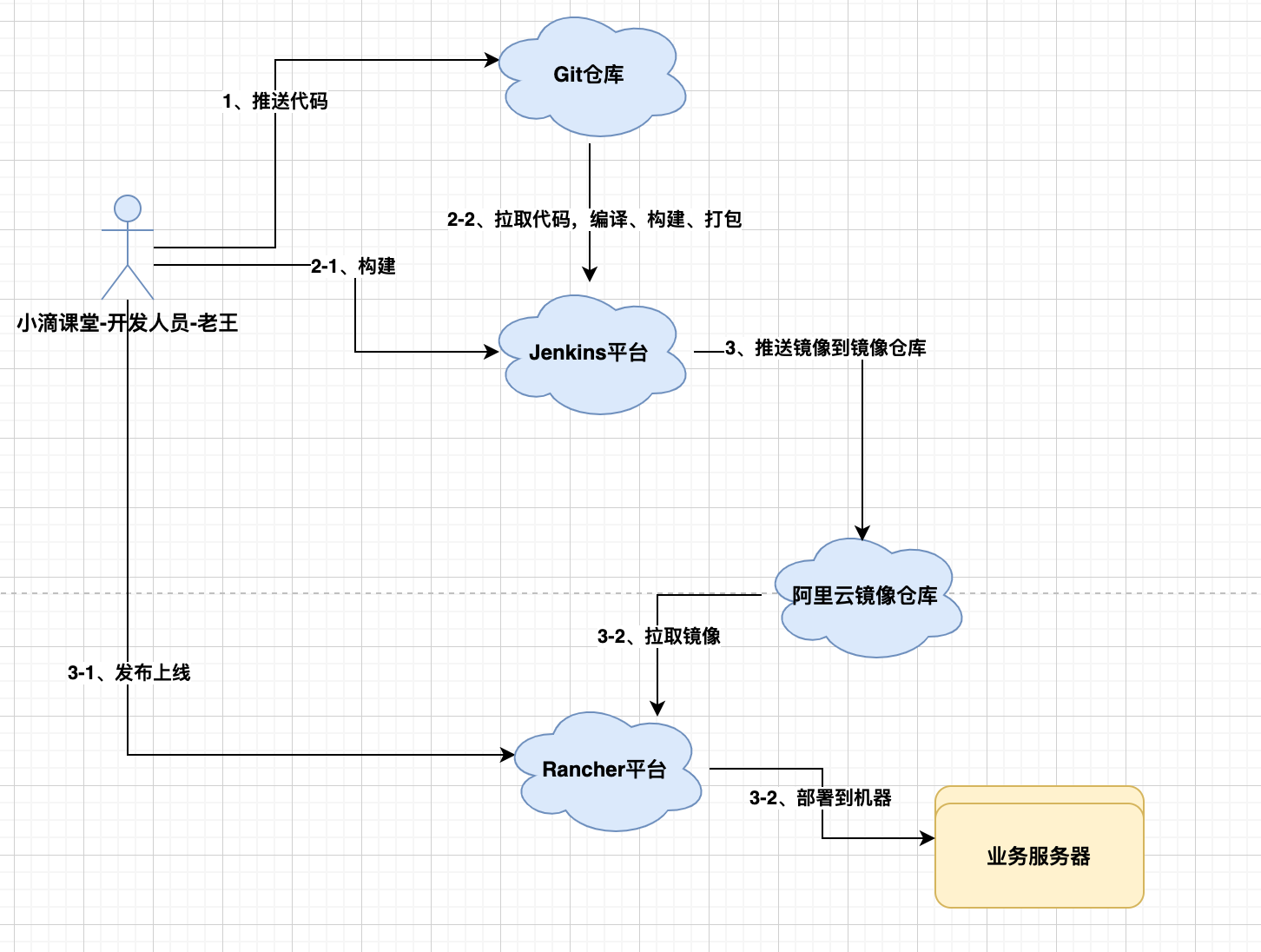

第5集 一线大厂标准化DevOpS架构-容器编排调度

简介: 一线大厂标准化DevOpS架构-容器编排调度

软件生命周期

一个软件从零开始到最终交付

- 需求评审-》设计-》开发-》测试-》灰度-》上线-》版本迭代

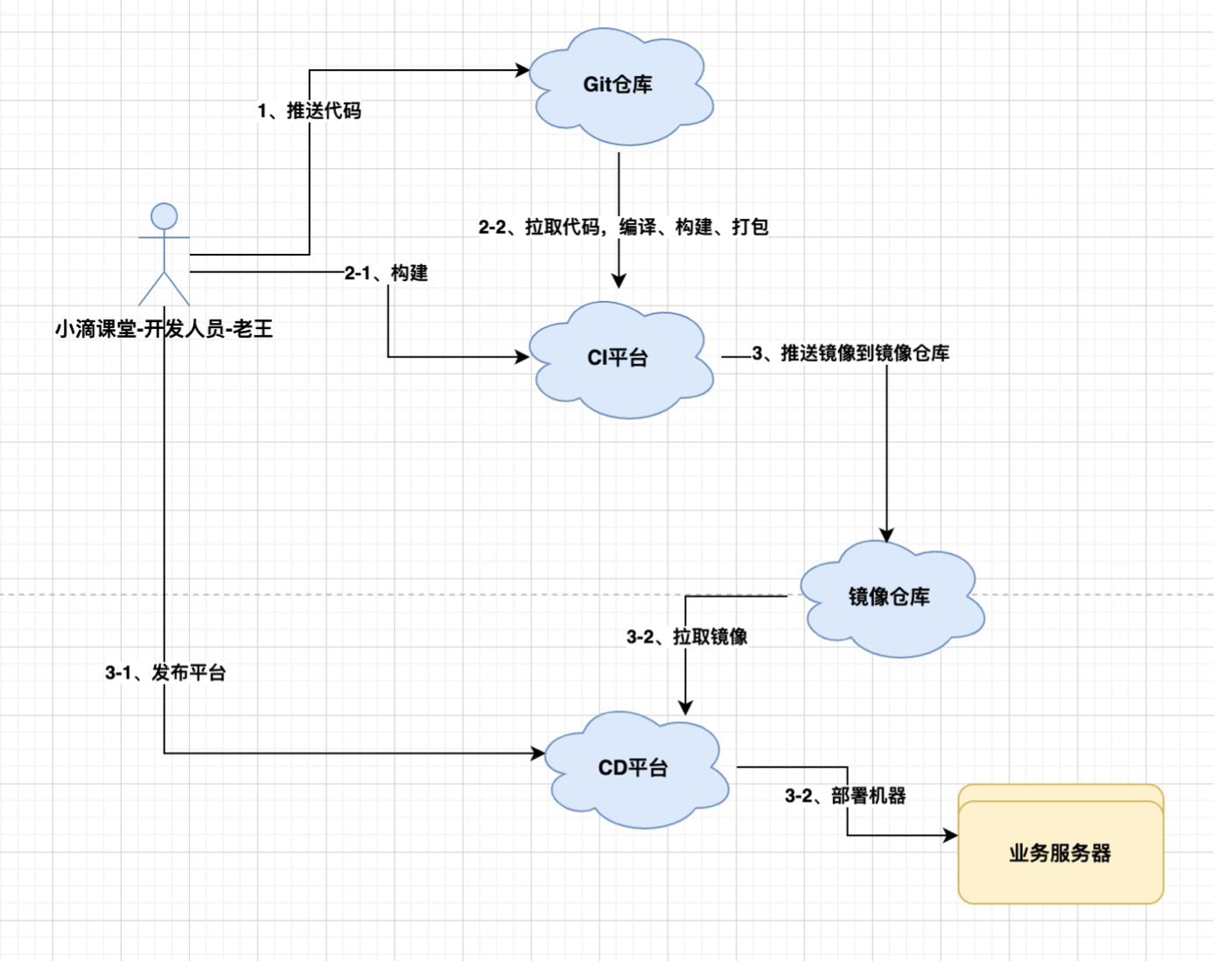

【小滴课堂】 为例子

前期(功能简单)

- 技术人员:老王,一人搞定所有阶段的工作

中期(增加需求)

- 技术人员:老王、老帆、大钊、Anna(测试)、冰冰(运 维)

- 不同人员完成不同的工作,等一个阶段所有工作完成再 进入下一个阶段,瀑布模型

- 上线发布,每次都要【冰冰】进行操作,一堆shell控制

后期(功能多、项目多、时间少)

- 应对快速变化需求的软件开发能力,就是敏捷开发,结合CI持续集成、CD持续部署

- 运维人员:定义好规则,发布平台、监控平台、运维平台

- 开发人员:根据运维人员提供的平台和定义的规则,自 主完成发布上线

什么是CICD

- 是指持续集成、持续发布,是一套实现软件的构建测试部署的自动化流程。

什么是DevOps

- 一词是由英文 Development(开发)和 Operations (运 维)组合而成

- 一种思想,强调软件开发测试运维的一体化,减少各个部⻔之 间的沟通成本从而实现软件的快速高质的发布

- DevOps与CICD紧密相关,DevOps要实现人员一体化,须要 借助CICD工具来自动化整个流程

通俗易懂的话

- DevOps是 开发+测试+运维 交集

- 以前是单一职责 现在一专多能 考虑配合提效,

- CI/CD 多环境-构建-打包-测试-上线-监控

- 快速迭代产品,每次代码的改动都触发校验,每刻都可进行 新版本的上线

愿景:"让编程不再难学,让技术与生活更加有趣"

愿景:"让编程不再难学,让技术与生活更加有趣"

更多架构课程请访问 xdclass.net

第十二章 容器编排调度K8S课程总结和架构路线学习

第1集 容器编排调度K8S最佳实践专题课程总结

简介: 容器编排调度K8S最佳实践专题课程总结

K8S知识点回顾

Kubernetes核心资源管理操作实战

Kubernetes核心资源之名称空间和Pod实战

Kubernetes核心资源之Pod控制器实战

Kubernetes核心资源之Service服务实战

Kubernetes核心资源之数据存储持久化

云服务器K8S集群部署SpringBoot项目实战

容器编排调度-K8S可视化工具Rancher2.x实战

Rancher2.X部署多案例镜像实战

- K8S可视化工具-Rancher里面部署微服务

- 后端工程师掌握常规的容器编排调度即可

容器编排调度K8S课程总结和架构路线学习

第2集 微服务海量数据项目-商用短链平台大课先导集《上》

简介: 微服务架构-海量数据项目-商用短链平台大课先导集《上》

第3集 微服务海量数据项目-商用短链平台大课先导集《下》

简介: 微服务架构-海量数据项目-商用短链平台大课先导集《下》

第4集 架构师成长路线- 如何选择IT技术人的职场充电站

简介:小滴课堂架构师学习路线和大课训练营介绍

技术培训的你应该知道的事情

- 技术是每年一小变,三年一大变,持续学习是关键

- 大家也是过来人,小滴课堂-每个技术栈课程不贵,从专题技术到大课,不同阶段你收获也不一样

- 市面上技术视频很多,但是与其不如四处搜索,还不错选个靠谱的平台持续学习

- 提升自己技术能力 + 不浪费时间 + 涨薪,是超过N倍的收益

- 我也在学习每年参加各种技术沙⻰和内部分享会投 入超过6位数,但是我认为是值的,且带来的收益更大

- 定时复习专题课程笔记+大课里面的笔记和解决方案

- 技术是不断演进的,后端+大数据,小滴课堂也会不断上架新的技术,做好技术储备,就不会被淘汰!!!

为啥说免费的才是最贵的,比如【盗版视频】或者【割韭菜的机构】

视频录制时间旧 或者 讲师水平Low,导致学不到技术甚至还【学错了技术】

课程资料、代码缺少,导致自己花了大量时间去调试最后还不一定解决

项目源码不规范、思考维度缺少,什么样的老师带出什么样的学生

正版学习群的关键性

- 盗版群里你能结实到什么人员,各种混杂人员,遇到问题卡死,花了几百块还盗版人员跑路不更新

- 正版学习群里,不少大厂技术负责人,本身内推和招聘,风气也好、价值观也好

- 遇到问题有群里的学霸和讲师帮你解决,也有更多面经分享等

大家计算下自己的时薪、日薪

月薪20k, 一天8小时,一个月工作22天,你一小时值多少钱、一天值多少钱 ,1千块!!

还有很多互联网公司,一年14到16个月工资+股票,那一天就是好几千了,阿里P6级别都是30k月薪

举个跳槽例子

- 老王月薪10k,花了4k学了大课,一线城市找到了20k Offer

- 入职第一个月月薪的四分之一就回本了,后续都是自己更高的收入

记住!!!!

跳槽涨薪不是你说跳就跳的,说涨就涨的

你需要有让面试官给你这个薪资的理由

- 比如你有好项目经历、各种高并发、分布式解决方案

- 能给公司和技术团队带来新血液,提升一个档次

- 你学了大课,里面N多技术难点解决方案,就可以让你靠这些去跳槽涨薪!!!

小滴课堂永久会员 & 小滴课堂年度会员

适合IT人员,零基础就业、在职充电、架构师学习路线-专题技术方向

- 包括业界主流技术栈,前端、后端、测试、架构、大数据 等等课程,接近上百套视频,深度+广度

- 包括 从零基础到就业班,高级工程师、技术负责人、架构师技术栈 全套学习路线

- 永久会员可以观看全部专题IT技术,作为一个终生学习平台,每个月更新多套视频

- 如何获取最新路线图,有你想学的多数主流技术栈,持续更新!!!

学后水平:一线城市 15~25k

适合人员:校招、应届生、培训机构出来、工作1~10年的同学都适合

大课综合训练营

适合用于专项拔高,适合有一定工作经验的同学,架构师方向发展的训练营,包括多个方向

综合项目大课训练营

海量数据分库分表大课训练营

架构解决方案大课训练营

全链路性能优化大课训练营

安全攻防大课训练营

数据分析大课训练营

算法刷题大课训练营

技术人的导航站(涵盖我们主流的技术网站、社区、工具等等,即将上线)

- 地址:open1024.com

- 地址:xdclass.net

后端/前端 一对一小班辅导

适合人员

- 计算机专业应届毕业生、非IT专业转行/编程爱好者

- 计划往 测试/前端/运维工程师 方向发展并就业的同学

亮点:

远程解决bug+简历辅导+模拟面试,对标一线城市12~20K月薪

7*12小时在线答疑,问题不过夜

人员配置:课程讲师+专业技术人员

后端/前端 保涨薪就业班

小班制学习,培训时间:3~8个月

Level1:薪资目标(12-18k)

Level2:薪资目标(18-30k)

报名条件

学历:大专及大专以上

年龄:18-32周岁

工作经验:至少1年以上或者 校招是本科以上

就业城市:互联网一线及二线城市

满足基础要求提交简历和入学考试,根据成绩进行老师评估(负责人:二当家小D)

学习时间要求

- Level1( 保证每周学习时长+作业提交+考核成绩)

- Level2( 保证每周学习时长+作业提交+考核成绩)